シングルクラウドAIを越えて:OpenAIコンピューティング問題から学ぶ企業の教訓

OpenAIの最近の動向は、AI業界に波紋を広げている。 サム・アルトマン 決意 マイクロソフトを超える は、AIを導入する企業が直面する重要な課題である「インフラの拡張性」を浮き彫りにしている。この戦略的転換は、AIを導入する企業にとって貴重な教訓となる。

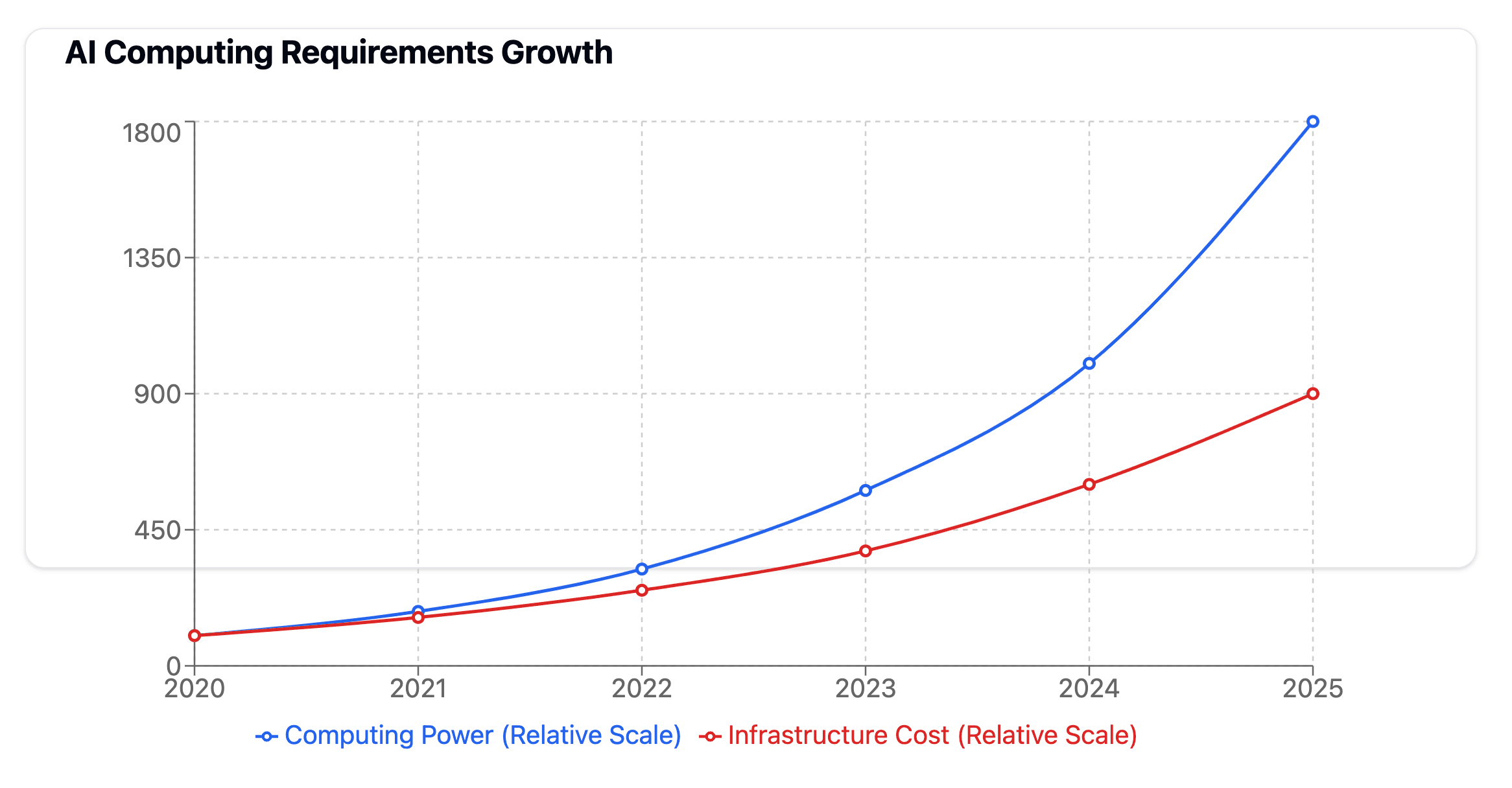

コンピューティング・パワーの危機

AIを取り巻く環境は、コンピューティング・インフラに対するかつてない要求を経験している。OpenAIがマイクロソフト以外のパートナーシップを模索する動きは、単なるビジネス上の決定ではなく、あらゆる規模の組織が最終的に取り組まなければならない基本的な課題への対応なのです。

これを踏まえて考えると、高度なAIモデルのトレーニングには膨大なコンピューティング・リソースが必要となる:

1回の大規模な言語モデルのトレーニング実行で、数千のハイエンドGPUと同等の計算能力を消費することができる。

企業は、開発プロセスを通じて何度もインフラを更新する必要があるかもしれない。

AIプロジェクトでは、コンピューティング・リソースへのアクセスがしばしば重要なボトルネックとなる。

テック界の巨人も苦戦する理由

マイクロソフトの膨大なリソースに支えられたOpenAIのような企業がコンピューティングの制約に直面することは、AI機能を構築する企業にとって重要な問題を提起する。課題はリソースへのアクセスだけでなく、インフラスタック全体の効率性と拡張性だ。

このような状況を後押ししている主な要因には、以下のようなものがある:

モデルサイズの指数関数的成長

複雑化するAIアプリケーション

限られたチップ供給競争

エネルギー消費への懸念

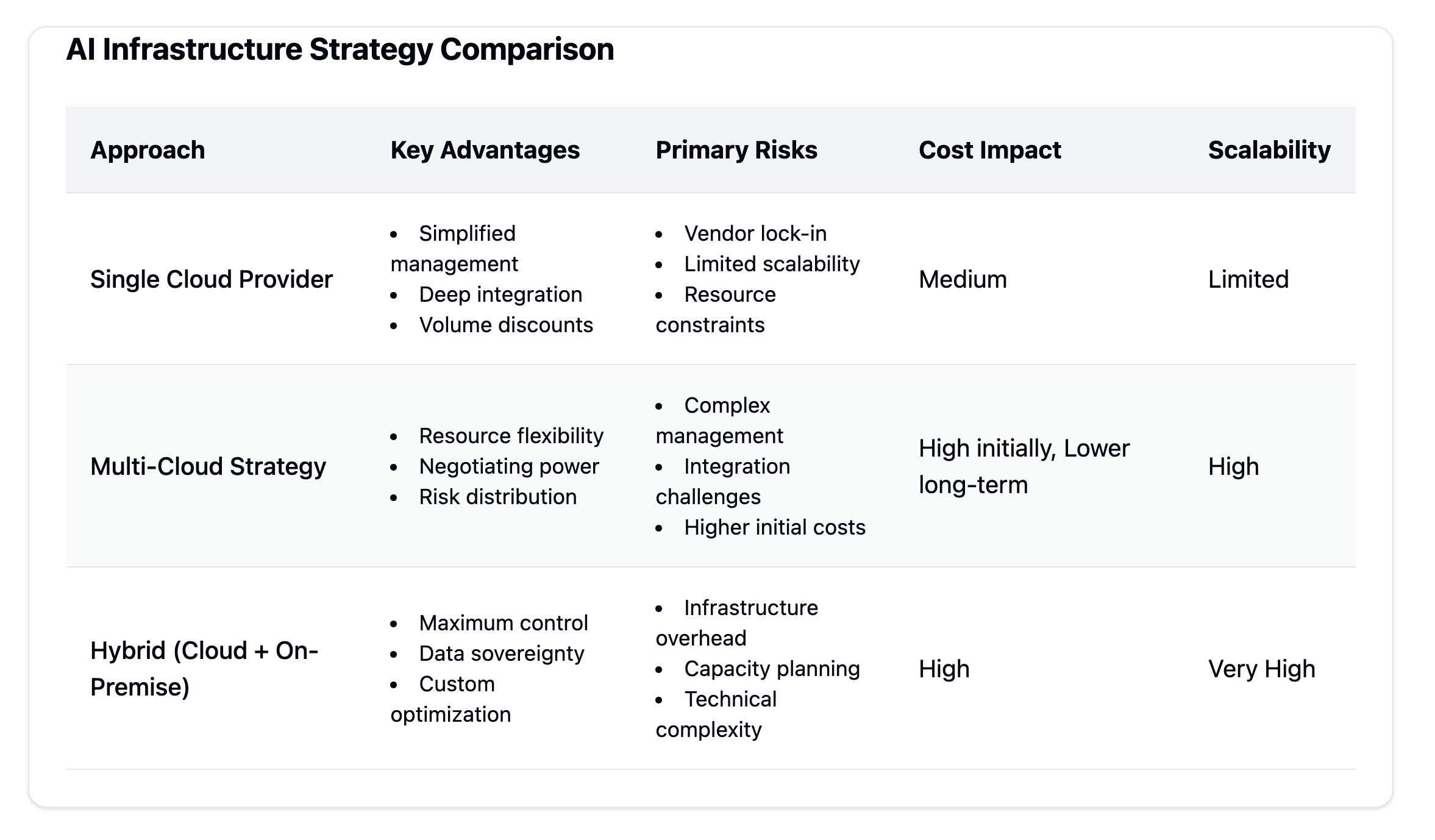

戦略的インフラの決定

組織は、AIインフラストラクチャーに対して戦略的なアプローチを取り、目先のコンピューティング・パワー・ニーズと長期的なスケーラビリティのバランスを取る必要がある。このプロセスでは、最終的に組織のAI能力を形成する複数の要因を慎重に検討する必要がある。

現在の能力の評価

インフラを決定する前に、企業は既存のコンピューティングリソースと将来の要件を評価する必要があります。この最初のステップは、潜在的なボトルネックと改善領域を特定するのに役立つ。企業は、現在のワークロード、予測される成長、特定のAIモデルの要件を理解することに集中する必要があります。

マルチベンダー戦略の考察

OpenAIのリードに従い、企業はマルチベンダー・アプローチの利点を評価すべきである。この戦略はいくつかの重要な利点を提供できる:

単一プロバイダーへの依存度の低減

コスト最適化の機会を強化

リソースの利用可能性の向上

より強力な交渉ポジション

ハイブリッド・インフラ計画

の未来 エンタープライズAI インフラストラクチャーは、ますますハイブリッドモデルを指向するようになっている。これらのソリューションは通常、次のような組み合わせになっている:

拡張性と柔軟性のためのクラウドリソース

機密性の高いワークロードのためのオンプレミス・コンピューティング

レイテンシが重要なアプリケーションのためのエッジコンピューティング

このような戦略を導入する場合、企業はデータ・セキュリティ要件、パフォーマンス要求、全体的なコスト構造などの要因を考慮しながら、特定のニーズを慎重に評価する必要がある。目標は、運用効率を維持しながら、変化するAIコンピューティングの需要に適応できる柔軟なインフラを構築することである。

エンタープライズAIの将来性

企業がAI機能を拡張するにつれて、長期的な成功のためには、将来を見据えたインフラストラクチャーが重要になってくる。OpenAIコンピューティングが直面している課題は、AI開発の最前線にいる企業でさえ、進化する需要に対応するためにインフラ戦略を常に更新しなければならないことを示している。

今日のAIアプリケーションは、かつてないほどのコンピューティング・パワーを必要とし、この需要はますます高まるだろう。組織は、それに適応できるスケーラブルなインフラを開発する必要がある:

モデルの大型化と複雑化

増大するデータ処理要件

ビジネス・アプリケーションの拡大

ダイナミックな作業負荷パターン

重要なのは、適切なコンピューティング・リソースへのアクセスを維持しながら、インフラストラクチャー戦略に柔軟性を組み込むことです。これには、組織のAI機能が成熟するにつれて、簡単にアップグレードまたは拡張できるモジュール式システムを導入することも含まれる。

エネルギー消費もまた、AIインフラ計画における重要な要素として浮上している。組織は考慮しなければならない:

コンピューティング・リソースの電力効率

冷却システムの要件

持続可能なエネルギー源

カーボンフットプリントへの影響

大規模なAIモデルのトレーニングを検討している企業は、アプリケーションに必要なコンピューティング・パワーを維持しながら、最終的にエネルギー使用量の最適化を支援できるデータセンター・プロバイダーと緊密に連携すべきである。

OpenAIのカスタムチップへの取り組みを含む最近の市場動向は、半導体戦略の重要性を浮き彫りにしている。組織はこうあるべきだ:

ハードウェア・サプライヤーの多様化

特定のワークロードのためのカスタムソリューションを検討する

複数のベンダーとの関係維持

潜在的なサプライチェーンの混乱に対する計画

組織のためのアクション・ステップ

堅牢なAIインフラの導入と維持を成功させるために、組織はビジネス目標と能力に沿った構造化されたアプローチに従うべきである。

評価の枠組み

現在のポジションと将来のニーズを評価することから始めよう:

既存のコンピューティング・リソースの監査

AIプロジェクトの要件をマップする

組織内のスキルギャップを分析する

予算の制約とROIの期待値を評価する

実施戦略

インフラ配備の段階的アプローチを開発する:

ソリューションのテストと検証のためのパイロット・プロジェクトから始める。

成功した実装を徐々に拡大する

パフォーマンスを監視し、必要に応じて調整する

将来のアップデートに柔軟に対応

リスク軽減

AIへの投資を保護する

重要システムに冗長性を導入する

サービス中断に対する緊急時対応計画の策定

プロセスの詳細な文書化

明確なエスカレーション手順の作成

定期的な見直しと更新サイクルの確立

前進するためには、企業はAIインフラストラクチャーの開発に積極的な姿勢をとる必要がある。これらの要素を慎重に検討し、適切な対策を講じることで、企業はAIイニシアチブの強固な基盤を構築することができ、同時にこの分野の将来の発展にも適応し続けることができる。

結論

OpenAIのインフラ決定が示すように、エンタープライズAIの未来は、クラウド大手だけに依存することを超えて広がっている。組織は最終的に、AIインフラストラクチャの構築と拡張に対して戦略的なアプローチを取る必要があり、コンピューティングパワーの要件とコスト考慮や将来のスケーラビリティとのバランスを慎重に取らなければならない。この領域での成功には、運用効率を維持しながら急速な技術変化に適応できる柔軟で多面的な戦略が必要だ。

AIインフラを評価し、実装し、将来を見据えた重要なステップを今すぐ踏むことで、企業は業界リーダーでさえ直面するボトルネックを回避しながら、AIの変革能力をフルに活用できる体制を整えることができる。重要なのは、堅牢なAIインフラへの道のりは継続的であり、進化していることを明確に理解した上で、今すぐプロセスを開始することである。