LLMのための数発プロンプト、学習、微調整 - AI&YOU #67 LLMのための数発プロンプト、学習、微調整 - AI&YOU #67

LLMのための数発プロンプト、学習、微調整 - AI&YOU #67 LLMのための数発プロンプト、学習、微調整 - AI&YOU #67

今週のスタッツ コイン画像分類のための数ショット学習に関するMobiDevの研究では、コインの額面ごとにわずか4つの画像例を使用することで、~70%の精度を達成することができました。

AIでは、限られたデータから効率的に学習する能力が重要になっている。そのため、企業にとって、数ショット学習、数ショットプロンプト、LLMの微調整を理解することが重要なのだ。

今週のAI&YOUでは、私たちが公開した3つのブログから得た洞察を紹介します:

LLMのための数発のプロンプト、学習、微調整 - AI&YOU #67

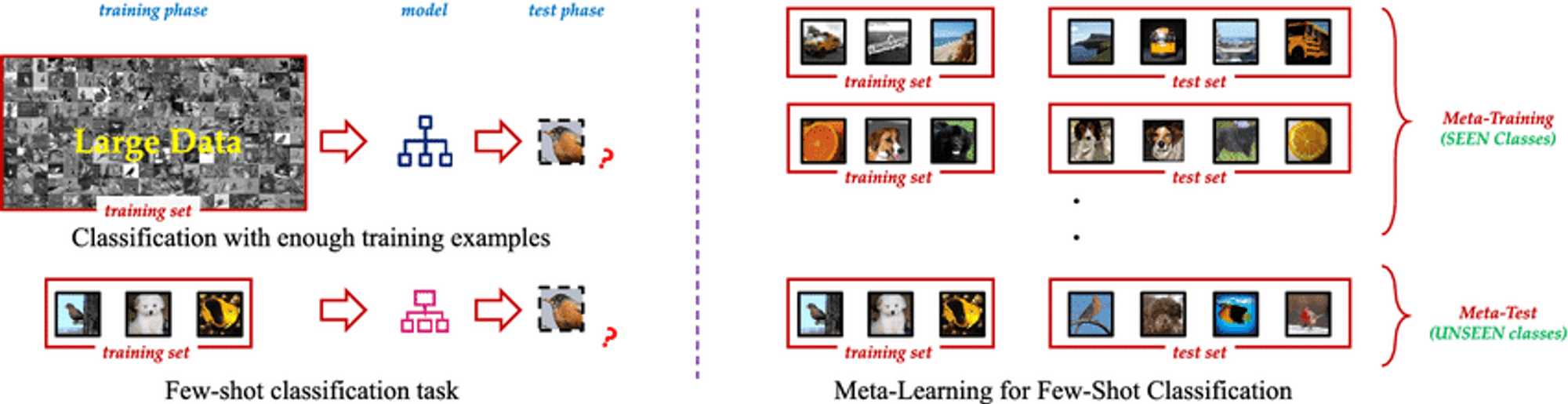

Few Shot Learningは、AIモデルがわずかな例から新しい概念やタスクを学習することを可能にする革新的な機械学習パラダイムである。ラベル付けされた膨大な学習データを必要とする従来の教師あり学習手法とは異なり、Few Shot Learningの手法では、わずかな数のサンプルを使ってモデルを効果的に汎化することができる。このアプローチは、大規模な反復を必要とせず、新しいアイデアを素早く理解する人間の能力を模倣している。

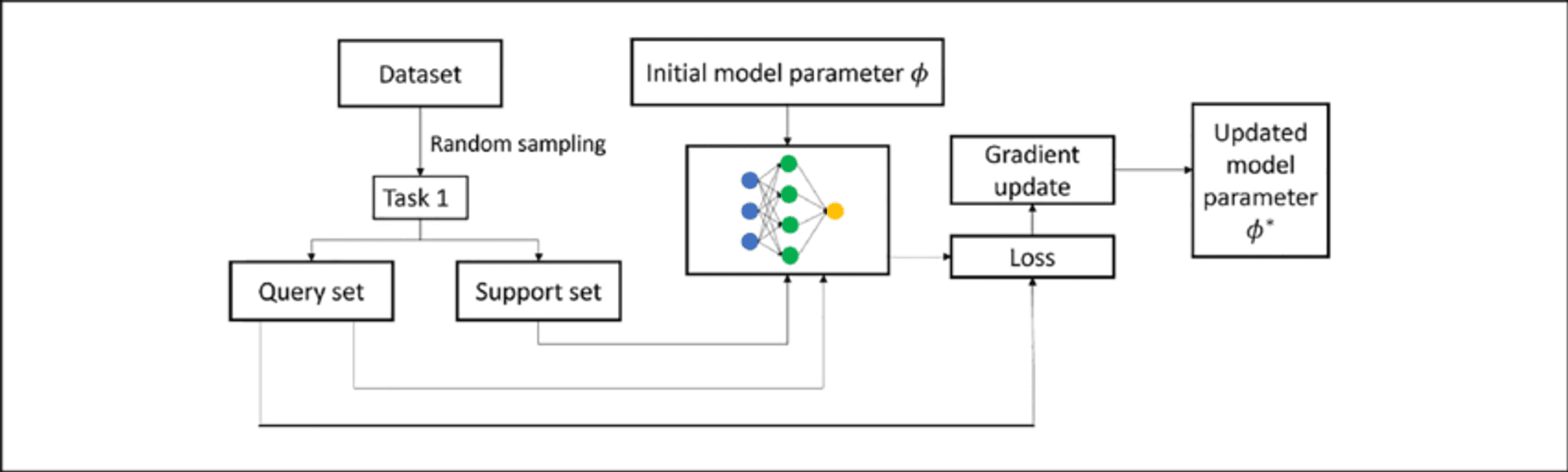

フューショットラーニングの本質は、事前知識を活用し、新しいシナリオに迅速に適応する能力にある。モデルが「学習方法を学習する」メタ学習などのテクニックを使うことで、Few Shot Learningアルゴリズムは、最小限の追加トレーニングで幅広いタスクに取り組むことができる。この柔軟性により、データが乏しかったり、入手にコストがかかったり、常に進化し続けるようなシナリオにおいて、非常に貴重なツールとなる。

AIにおけるデータ不足の課題

すべてのデータが同じように作成されるわけではなく、高品質のラベル付きデータは希少で貴重な商品となり得る。この希少性は、従来の教師あり学習アプローチにとって大きな課題となる。教師あり学習アプローチでは、満足のいく性能を達成するために、通常、数千から数百万のラベル付き事例を必要とする。

データ不足の問題は、希少疾患の症例が限られているヘルスケアなどの専門領域や、新しいカテゴリーのデータが頻繁に出現する変化の激しい環境において特に深刻である。このようなシナリオでは、大規模なデータセットを収集し、ラベル付けするために必要な時間とリソースは法外なものとなり、AIの開発と展開におけるボトルネックとなる。

数発学習と従来の教師あり学習の比較

フューショットラーニングと従来の教師あり学習の違いを理解することは、その実社会への影響を把握する上で極めて重要である。

トラディショナル 教師付き学習強力ではあるが、欠点もある:

データ依存性: 限られたトレーニングデータで苦戦。

柔軟性がない: 訓練された特定の作業のみでうまくこなす。

資源強度: 大規模で高価なデータセットを必要とする。

継続的なアップデート: ダイナミックな環境では頻繁な再訓練が必要。

数少ないショット学習 はパラダイムシフトを提案する:

サンプル効率: メタ学習を使って、少ない例から一般化する。

迅速な適応: 最小限の例を示すだけで、新しい仕事に素早く適応できる。

リソースの最適化: データ収集とラベリングの必要性を軽減。

継続的な学習: 新しい知識を忘れることなく取り入れるのに適している。

汎用性がある: コンピュータ・ビジョンからNLPまで、さまざまな領域に適用可能。

これらの課題に取り組むことで、フューショットラーニングはより適応的で効率的なAIモデルを可能にし、AI開発の新たな可能性を切り開く。

サンプル効率学習のスペクトラム

ゼロショット学習、ワンショット学習、数ショット学習など、必要な学習データを最小限に抑えるための魅力的なアプローチがある。

ゼロショット学習:例なしに学習する

テキスト記述のような補助情報を使って未知のクラスを認識する

すべてのクラスについてラベル付けされた例が実用的でない、あるいは不可能である場合に価値がある。

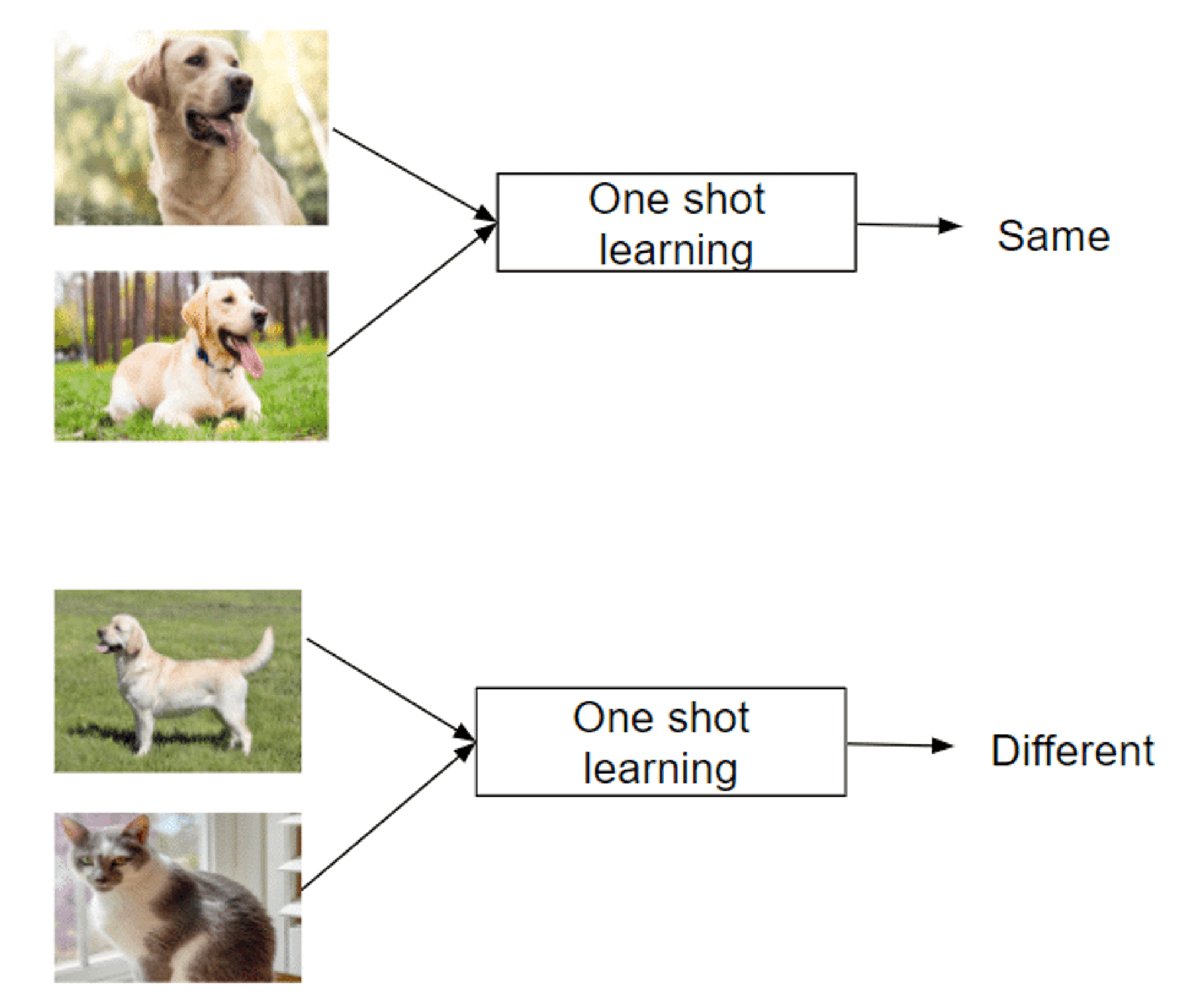

ワンショット学習:単一インスタンスからの学習

たった1つの例から新しいクラスを認識

概念を素早く理解する人間の能力を模倣

顔認識などの分野で成功

数撃ちゃ当たる学習:最小限のデータでタスクをマスターする

新しいクラスごとに2~5個のラベル付き例を使用

極端なデータ効率と伝統的な手法のバランス

新しいタスクやクラスへの迅速な適応が可能

メタ学習戦略を活用して学習方法を学ぶ

このようなアプローチは、限られた例から学習するという課題に取り組む上でユニークな能力を提供し、データが乏しい領域では貴重な存在となる。

数発のプロンプティングと微調整のLLM

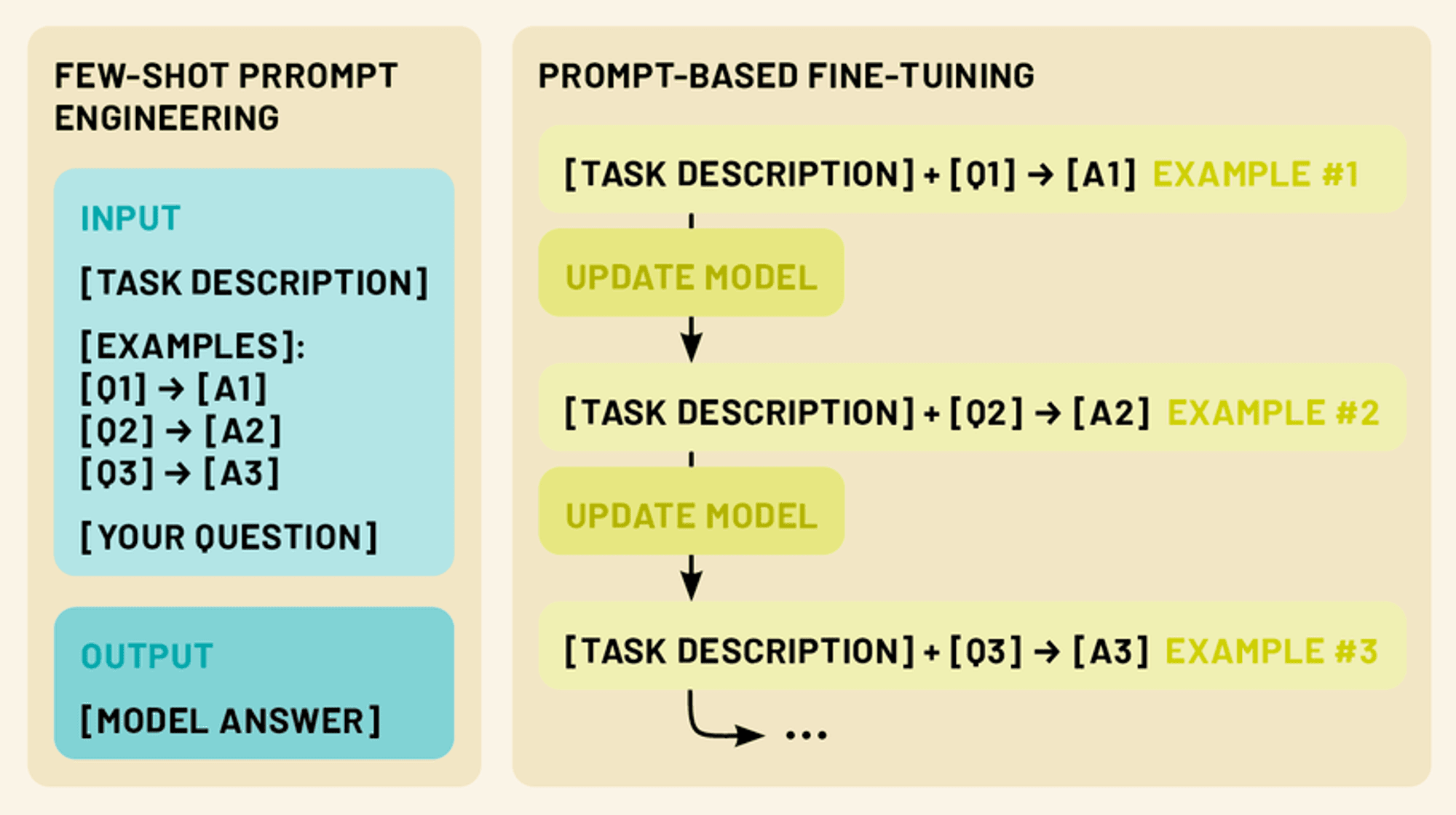

この領域には、より強力な2つのテクニックが存在する。スモールショット・プロンプトでは、少数の例を含む巧みな入力プロンプトを作成し、追加トレーニングなしで特定のタスクを実行するようモデルを誘導する。一方、ファインチューニングでは、限られたタスク固有のデータを使用してモデルのパラメータを更新し、その膨大な知識を特定のドメインやアプリケーションに適応させる。

どちらのアプローチも、少数ショット学習の傘下にある。これらのテクニックを活用することで、LLMの性能と汎用性を劇的に向上させることができ、自然言語処理をはじめとする幅広いアプリケーションにおいて、より実用的で効果的なツールとなる。

フューショット・プロンプティングLLMの可能性を引き出す

スモールショット・プロンプトは、LLMの指示を理解する能力を利用し、LLMを効果的に "プログラミング "する。

数ショットのプロンプトは、モデルのパターン認識と適応性を活用して、希望するタスクを示す1~5例を提供する。これにより、LLMの文脈内学習能力を活用し、明示的に訓練されていないタスクの実行が可能になる。

明確な入出力パターンを提示することで、数ショットのプロンプトは、LLMが新しい入力に同様の推論を適用するよう誘導し、パラメータを更新することなく新しいタスクに素早く適応することを可能にする。

数ショットのプロンプトの種類(ゼロショット、ワンショット、数ショット)

数発プロンプトは、提供される例の数によって定義される、さまざまなアプローチを包含する。(数発学習と同じように):

ゼロショットのプロンプト: このシナリオでは、例題は提供されない。その代わり、モデルにはタスクの明確な指示や説明が与えられる。例えば、"次の英文をフランス語に翻訳してください:[入力テキスト]"。

一発プロンプト: ここでは、実際の入力の前に一つの例が提供される。これはモデルに、期待される入出力関係の具体的な例を与える。例えば「次のレビューのセンチメントをポジティブかネガティブかに分類しなさい。例:「この映画は素晴らしかった!」 - 肯定的な入力:「筋書きに耐えられなかった。- モデルは応答を生成する]"

数発のプロンプト: このアプローチでは、実際の入力の前に複数の例(通常2~5)を提供する。これにより、モデルはタスクのより複雑なパターンやニュアンスを認識することができる。例えば「次の文を質問か文に分類しなさい:空は青い。- 文『今何時ですか』 - 質問『私はアイスクリームが大好きです』。- 文の入力:'近くのレストランはどこにありますか' - [モデルが応答を生成する]"

効果的な数発プロンプトをデザインする

効果的なプロンプトを作成することは、芸術であると同時に科学でもあります。ここでは、いくつかの重要な原則を紹介します:

明快さと一貫性: 例や指示が明確で、一貫した形式に従っていることを確認しましょう。そうすることで、モデルがパターンを認識しやすくなります。

多様性: 複数の例を使用する場合は、モデルにタスクのより広い理解を与えるために、考えられる入力と出力の範囲をカバーするようにしてください。

関連性がある: 対象とする特定のタスクやドメインに密接に関連する例を選びます。こうすることで、モデルが知識の最も関連性の高い側面に集中できるようになります。

簡潔さ: 十分な文脈を提供することは重要ですが、モデルを混乱させたり、重要な情報を薄めたりするような、長すぎたり複雑すぎたりするプロンプトは避けてください。

実験: あなたの特定のユースケースに最適なものを見つけるために、繰り返し、さまざまなプロンプトの構造や例を試すことを恐れないでください。

数発のプロンプトを使いこなすことで、LLMの潜在能力を最大限に引き出し、追加入力やトレーニングを最小限に抑えながら、さまざまなタスクに取り組ませることができる。

LLMの微調整:限られたデータでモデルを調整する

数ショットのプロンプトは、モデル自体に変更を加えることなく、LLMを新しいタスクに適応させるための強力なテクニックであるが、ファインチューニングは、特定のタスクやドメインでさらに優れたパフォーマンスを発揮するために、モデルのパラメータを更新する方法を提供する。ファインチューニングにより、事前に訓練されたLLMにエンコードされた膨大な知識を活用しながら、タスク固有のわずかなデータを使用して、特定のニーズに合わせてLLMを調整することができます。

LLMの文脈でファインチューニングを理解する

LLMのファインチューニングでは、事前に訓練されたモデルを、タスクに特化した小規模なデータセットでさらに訓練する。このプロセスでは、既存の知識をベースにしながらモデルをターゲットタスクに適応させるため、ゼロから学習するよりも少ないデータとリソースで済みます。

LLMでは通常、微調整によってタスクに特化した上位層の重みが調整されるが、下位層はほとんど変化しない。この "転移学習 "アプローチは、専門的な能力を開発しながら、幅広い言語理解を維持する。

数ショットの微調整テクニック

Few-shotファインチューニングは、クラスまたはタスクごとに10~100サンプルだけを使用してモデルを適応させるもので、ラベル付きデータが少ない場合に有用である。主なテクニックは以下の通り:

プロンプトベースの微調整: 数発のプロンプトとパラメータ更新を組み合わせる。

メタ学習アプローチ: などの方法がある。 MAML 迅速な適応のための良い初期化ポイントを見つけることを目的としている。

アダプター・ベースの微調整:学習済みモデル層間に小さな「アダプター」モジュールを導入し、学習可能なパラメーターを減らす。

インコンテクスト学習: LLMを微調整し、プロンプトのみによる適応をよりよく実行できるようにする。

これらの技術は、LLMが最小限のデータで新しいタスクに適応することを可能にし、その汎用性と効率を高める。

数発のプロンプティングと微調整:正しいアプローチの選択

LLMを特定のタスクに適応させる場合、数発のプロンプトと微調整の両方が強力な解決策を提供する。しかし、それぞれの方法には長所と限界があり、適切なアプローチを選択するかどうかはさまざまな要因に左右される。

数発のプロンプティングの強み:

モデルのパラメータを更新する必要がなく、元のモデルを維持できる。

柔軟性が高く、その場で適応可能

追加のトレーニング時間や計算リソースは不要

迅速なプロトタイピングや実験に役立つ

制限事項:

特に複雑な作業では、パフォーマンスが安定しないことがある。

モデル本来の能力と知識による制限

専門性の高い領域や業務に苦戦する可能性がある

強みを微調整する:

多くの場合、特定のタスクでより良いパフォーマンスを達成する

新しいドメインや専門的な語彙にモデルを適応させることができる

同じようなインプットでより一貫した結果

継続的な学習と改善の可能性

制限事項:

追加のトレーニング時間と計算リソースが必要

注意深く管理しなければ、大惨事を引き起こす危険性がある。

小さなデータセットではオーバーフィットする可能性がある

柔軟性に欠け、大幅なタスク変更には再トレーニングが必要

数撃ちゃ当たるの研究論文トップ5

今週は、この分野を大きく前進させ、AI能力を再構築する革新的なアプローチを紹介した以下の5つの論文も紹介する。

1️⃣ 一発学習のためのマッチングネットワーク」(Vinyals et al.)

記憶と注意のメカニズムを利用した画期的なアプローチを導入。マッチング機能により、クエリー例とラベル付けされたサポート例を比較し、数発学習法の新たな基準を打ち立てた。

2️⃣ 数ショット学習のためのプロトタイプ・ネットワーク」(Snell et al.)

クラスが単一のプロトタイプで表現される計量空間を学習する、よりシンプルで効果的なアプローチを提示した。そのシンプルさと有効性から、その後の研究のベースラインとして人気を博した。

3️⃣ 比較する学習:数ショット学習のための関係ネットワーク」(Sung et al.)

学習可能な関係モジュールを導入し、モデルが特定のタスクやデータ分布に合わせた比較指標を学習できるようにした。様々なベンチマークで強力なパフォーマンスを実証。

4️⃣ フューショット分類に迫る」(Chen et al, 2019)

既存の手法を包括的に分析し、一般的な仮定に挑戦。より複雑なアプローチに匹敵するか、それを上回るシンプルなベースラインモデルを提案し、特徴的なバックボーンとトレーニング戦略の重要性を強調。

5️⃣ メタ・ベースライン:数ショット学習のためのシンプルなメタ学習の探求」(Chen et al.)

標準的な事前学習とメタ学習ステージを組み合わせ、最先端のパフォーマンスを達成。標準的な訓練とメタ学習の目的間のトレードオフを強調。

これらの論文は、学術研究を進展させただけでなく、エンタープライズAIにおける実用的な応用への道を開いた。これらの論文は、限られたデータから学習できる、より効率的で適応性の高いAIシステムへの進歩を象徴している。

結論

数ショット学習、プロンプト、および微調整は、LLMが最小限のデータで特殊なタスクに迅速に適応できるようにする画期的なアプローチである。私たちが探求してきたように、これらのテクニックは、自然言語処理タスクの強化から、ヘルスケア、法律、テクノロジーなどの分野でのドメイン固有の適応の実現まで、LLMを業界全体の多様なアプリケーションに調整する上で、これまでにない柔軟性と効率性を提供する。

AI & YOU』をお読みいただきありがとうございます!

インフォグラフィックス、統計、ハウツーガイド、記事、ビデオなど、エンタープライズAIに関するその他のコンテンツについては、Skim AIをフォローしてください。 LinkedIn

創業者、CEO、ベンチャーキャピタル、投資家の方で、AIアドバイザリー、AI開発、デューデリジェンスのサービスをお探しですか?貴社のAI製品戦略や投資機会について、十分な情報に基づいた意思決定を行うために必要なガイダンスを得ることができます。

企業向けAIソリューションの立ち上げにお困りですか?当社のAIワークフォースマネジメント・プラットフォームを使用して独自のAI労働者を構築することをお考えですか?ご相談ください

ベンチャーキャピタルやプライベートエクイティが支援する以下の業界の企業向けに、カスタムAIソリューションを構築しています:医療テクノロジー、ニュース/コンテンツアグリゲーション、映画/写真制作、教育テクノロジー、リーガルテクノロジー、フィンテック&暗号通貨。