ラマ3.1とプロプライエタリLLMの比較:企業にとっての費用対効果分析

大規模言語モデル(LLM)は、以下のようなオープンウェイトモデルとの戦いの場となっている。 メタのラマ 3.1 と、OpenAIのような技術大手が提供するプロプライエタリな製品。企業がこの複雑な地形をナビゲートするとき、オープンモデルを採用するか、クローズドソースのソリューションに投資するかの決断は、イノベーション、コスト、長期的なAI戦略にとって重要な意味を持つ。

Llama 3.1、特にその強力な405Bパラメータ・バージョンは、GPT-4oやClaude 3.5のような主要なクローズド・ソース・モデルに対する強力な競争相手として浮上している。この変化により、企業はAI実装へのアプローチを再評価する必要に迫られ、単なるパフォーマンス指標を超えた要素を考慮しなければならなくなった。

この分析では、Llama 3.1と独自のLLMのコスト・ベネフィット・トレードオフを深く掘り下げ、企業の意思決定者がAI投資について十分な情報に基づいた選択を行うための包括的なフレームワークを提供します。

コストの比較

ライセンス料:プロプライエタリモデルとオープンモデル

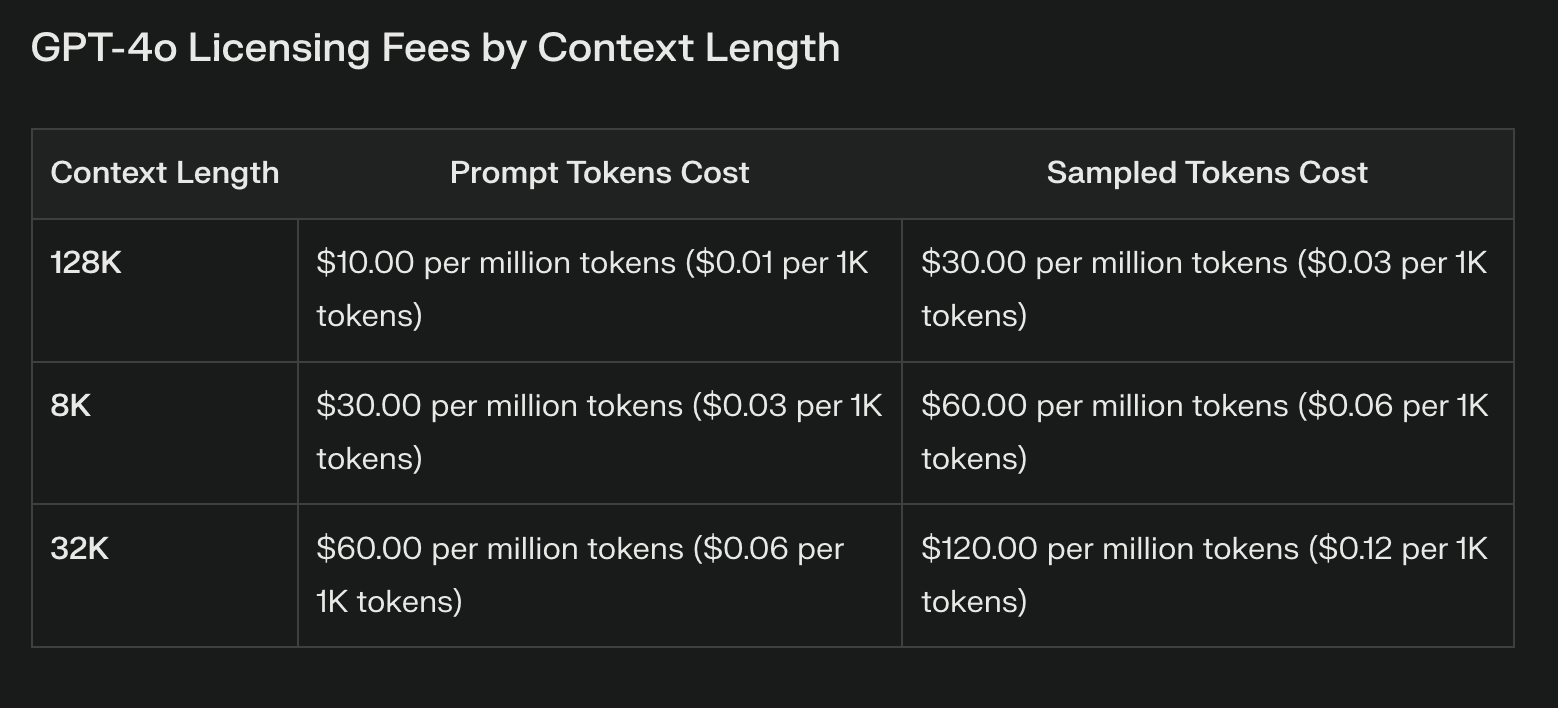

Llama 3.1とプロプライエタリ・モデルの最も明白なコストの違いは、ライセンス料にある。プロプライエタリなLLMは、多くの場合、かなりの経常コストがかかり、それは使用量によって大きく増減する。これらの費用は、最先端技術へのアクセスを提供する一方で、予算を圧迫し、実験を制限する可能性がある。

オープンウエイトのLlama 3.1では、ライセンス料が完全に不要になる。このコスト削減は、特に大規模なAIの導入を計画している企業にとっては、大きな意味を持つ。しかし、ライセンス料が不要だからといってコストがゼロになるわけではないことに注意する必要がある。

インフラと配備コスト

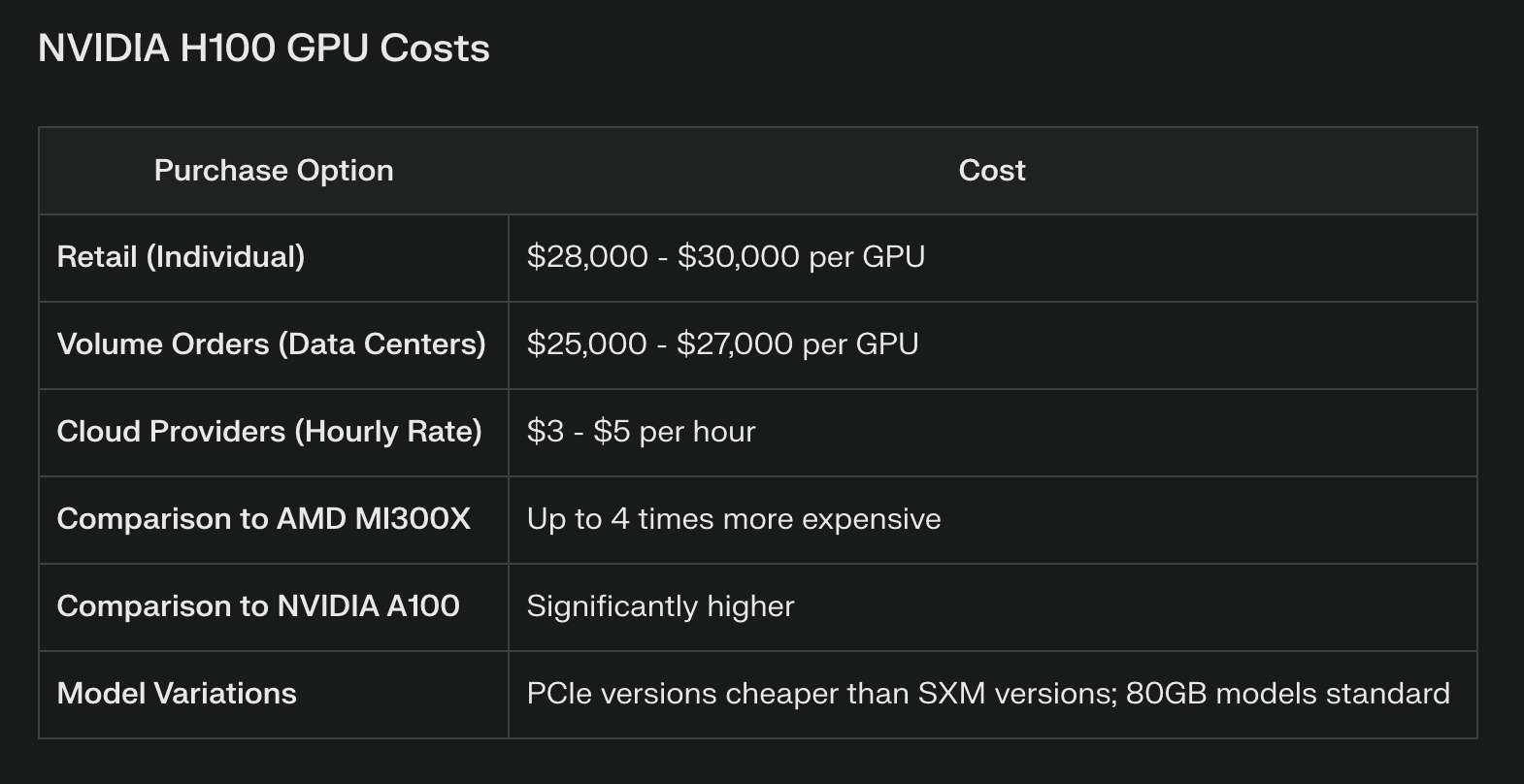

Llama 3.1はライセンシングを節約できるかもしれないが、特に405Bパラメータモデルには大きな計算リソースが必要となる。企業は、ハイエンドのGPUクラスターやクラウド・コンピューティング・リソースを含む、堅牢なハードウェア・インフラに投資しなければなりません。例えば、405Bのフルモデルを効率的に実行するには、複数のNVIDIA H100 GPUが必要となり、かなりの資本支出となります。

一般的にAPIを通じてアクセスできる独自のモデルは、これらのインフラ・コストをプロバイダーにオフロードする。これは、複雑なAIインフラを管理するためのリソースや専門知識を持たない企業にとって有利に働く可能性がある。しかし、大量のAPI呼び出しはすぐにコストを蓄積し、初期のインフラ節約を上回る可能性もある。

継続的なメンテナンスとアップデート

Llama 3.1のようなオープンウエイトモデルを維持するには、専門知識とリソースへの継続的な投資が必要です。企業はそのための予算を割り当てなければならない:

定期的なモデルの更新と微調整

セキュリティ・パッチと脆弱性管理

パフォーマンスの最適化と効率の改善

プロプライエタリ・モデルには、こうしたアップデートがサービスの一部として含まれていることが多く、社内チームの負担を軽減できる可能性がある。しかし、この利便性の代償として、更新プロセスの制御が低下し、微調整されたモデルに混乱が生じる可能性があります。

パフォーマンス比較

様々なタスクにおけるベンチマーク結果

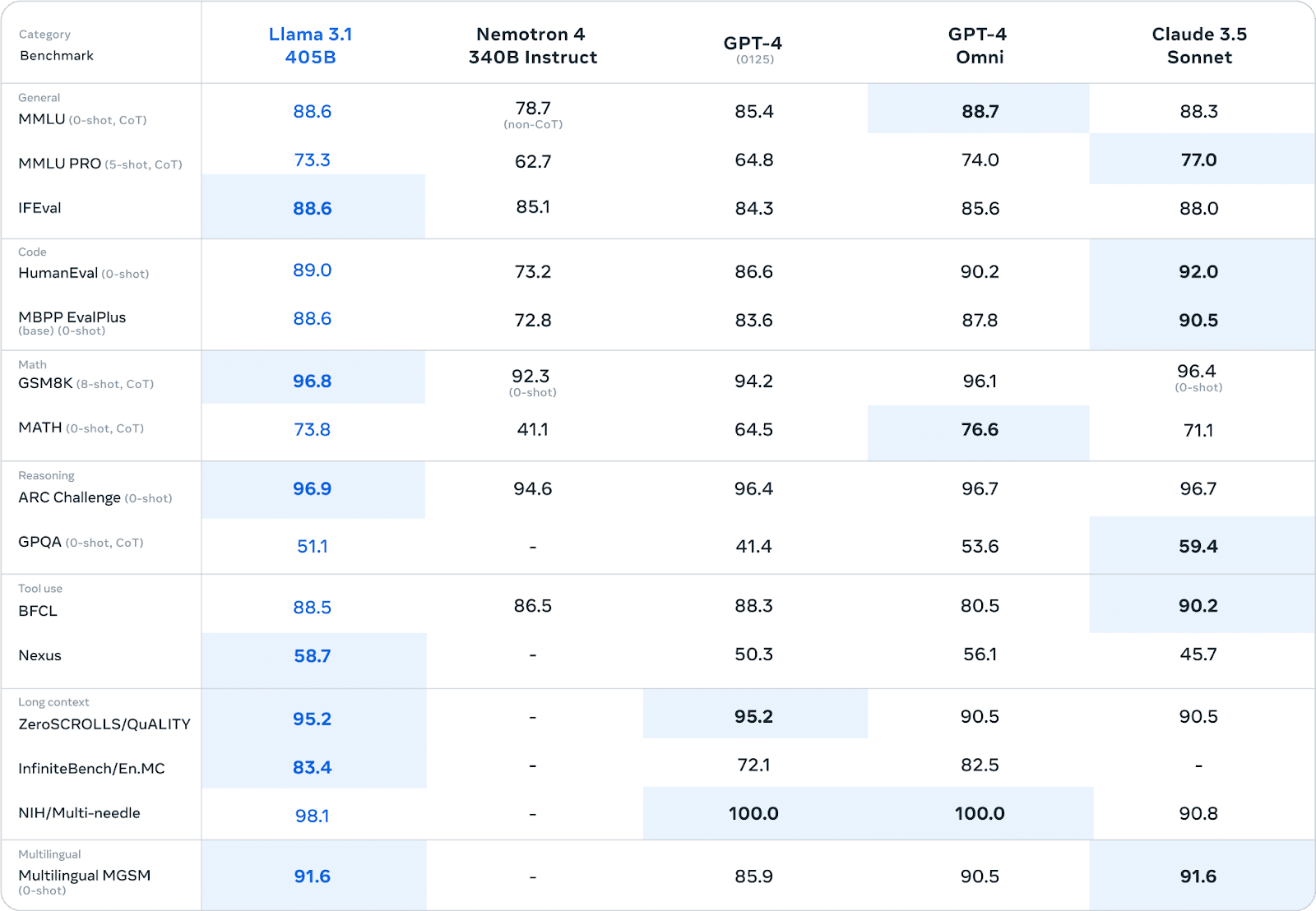

Llama 3.1は、様々なベンチマークにおいて、しばしばプロプライエタリ・モデルに匹敵する、あるいはそれを凌駕する、素晴らしいパフォーマンスを実証してきました。広範な人間による評価と自動テストにおいて、405Bパラメータ・バージョンは、以下のような分野で主要なクローズド・ソース・モデルに匹敵するパフォーマンスを示している:

一般知識と推論

コード生成とデバッグ

数学的問題解決

多言語能力

例えば、MMLU(大規模マルチタスク言語理解)ベンチマークでは、Llama 3.1 405Bは86.4%のスコアを達成し、GPT-4のようなモデルと直接競合している。

企業における実際のパフォーマンス

ベンチマークは貴重な洞察を与えてくれるが、企業環境における実際のパフォーマンスは、LLMの能力の真のテストである。

ここでは、より微妙なニュアンスになる:

カスタマイズの優位性: Llama 3.1を使用している企業は、ドメイン固有のデータでモデルを微調整することで、大きな利点を得ていると報告しています。このようなカスタマイズにより、特殊なタスクに対 して、既製のプロプライエタリ・モデルを凌駕するパフォーマンスが得ら れることがよくあります。

合成データ生成: Llama 3.1の合成データ生成機能は、トレーニングデータセットの補強や複雑なシナリオのシミュレーションを検討している企業にとって価値があることが証明されている。

効率のトレードオフ:Llama3.1のモデル蒸留のような技術によって、特化された効率的なモデルを作成する能力は、本番環境での全体的な結果を向上させます。

レイテンシーの考慮: API経由でアクセスする独自モデルは、単一のクエリに対してより低いレイテンシを提供する可能性があり、これはリアルタイムのアプリケーションにとって非常に重要です。しかし、専用ハードウェア上でLlama 3.1を実行している企業では、高負荷の下でより安定したパフォーマンスを報告しています。

パフォーマンスの比較は、特定のユースケースや実装の詳細に大きく依存することは注目に値する。企業は、正確なパフォーマンス評価を行うために、独自の環境で徹底的なテストを実施する必要がある。

長期的な考察

LLMの将来的な発展は、意思決定において非常に重要な要素である。Llama 3.1は、世界的な研究コミュニティによって推進される迅速な反復から恩恵を受け、画期的な改良につながる可能性がある。資金力のある企業に支えられた独自モデルは、一貫したアップデートを提供し、独自技術の統合の可能性がある。

について LLM市場 は混乱しやすい。Llama 3.1のようなオープンモデルがプロプライエタリな代替モデルの性能に近づいたり、それを上回ったりするにつれて、ベースモデルのコモディティ化や専門化の傾向が強まるかもしれない。新たなAI規制も、さまざまなLLMアプローチの実行可能性に影響を与える可能性がある。

より広範な企業のAI戦略との整合性は極めて重要である。Llama 3.1を採用することで、社内のAI専門家の育成を促進することができる一方、独自のモデルにコミットすることで、ハイテク大手との戦略的提携につながる可能性がある。

意思決定の枠組み

ラマ3.1が有利なシナリオは以下の通り:

大規模なカスタマイズを必要とする高度に専門化された業界アプリケーション

モデル管理ができる強力な社内AIチームを持つ企業

データ主権とAIプロセスの完全管理を優先する企業

独自のモデルが好まれるシナリオには、次のようなものがある:

最小限のインフラで即座に展開する必要がある

広範なベンダーサポートと保証されたSLAの要件

既存の独自AIエコシステムとの統合

結論

Llama 3.1とプロプライエタリなLLMのどちらを選択するかは、AIの展望をナビゲートする企業にとって重要な決定ポイントです。Llama 3.1は、これまでにない柔軟性、カスタマイズの可能性、ライセンス料のコスト削減を提供する一方で、インフラと専門知識に多大な投資を必要とします。プロプライエタリ・モデルは、使いやすさ、強固なサポート、一貫したアップデートを提供するが、その代償として制御性が低下し、ベンダーに囲い込まれる可能性がある。最終的には、企業固有のニーズ、リソース、長期的なAI戦略によって決定される。この分析で概説した要因を慎重に比較検討することで、意思決定者は組織の目標と能力に最も合致した方針を描くことができる。