Llama 3.1 vs. LLM proprietari: Un'analisi costi-benefici per le aziende

Il panorama dei modelli linguistici di grandi dimensioni (LLM) è diventato un campo di battaglia tra modelli di peso aperto come Il lama di Meta 3.1 e le offerte proprietarie di giganti tecnologici come OpenAI. Mentre le aziende si muovono su questo terreno complesso, la decisione di adottare un modello aperto o di investire in una soluzione closed-source ha implicazioni significative per l'innovazione, i costi e la strategia di AI a lungo termine.

Llama 3.1, in particolare la sua formidabile versione con parametri 405B, è emersa come un forte concorrente contro i principali modelli closed-source come GPT-4o e Claude 3.5. Questo cambiamento ha costretto le aziende a rivalutare il loro approccio all'implementazione dell'IA, prendendo in considerazione fattori che vanno oltre le semplici metriche di prestazione.

In questa analisi, ci immergeremo in profondità nei compromessi costi-benefici tra Llama 3.1 e gli LLM proprietari, fornendo ai responsabili delle decisioni aziendali un quadro completo per fare scelte informate sui loro investimenti nell'IA.

Confronto dei costi

Costi di licenza: Modelli proprietari e modelli aperti

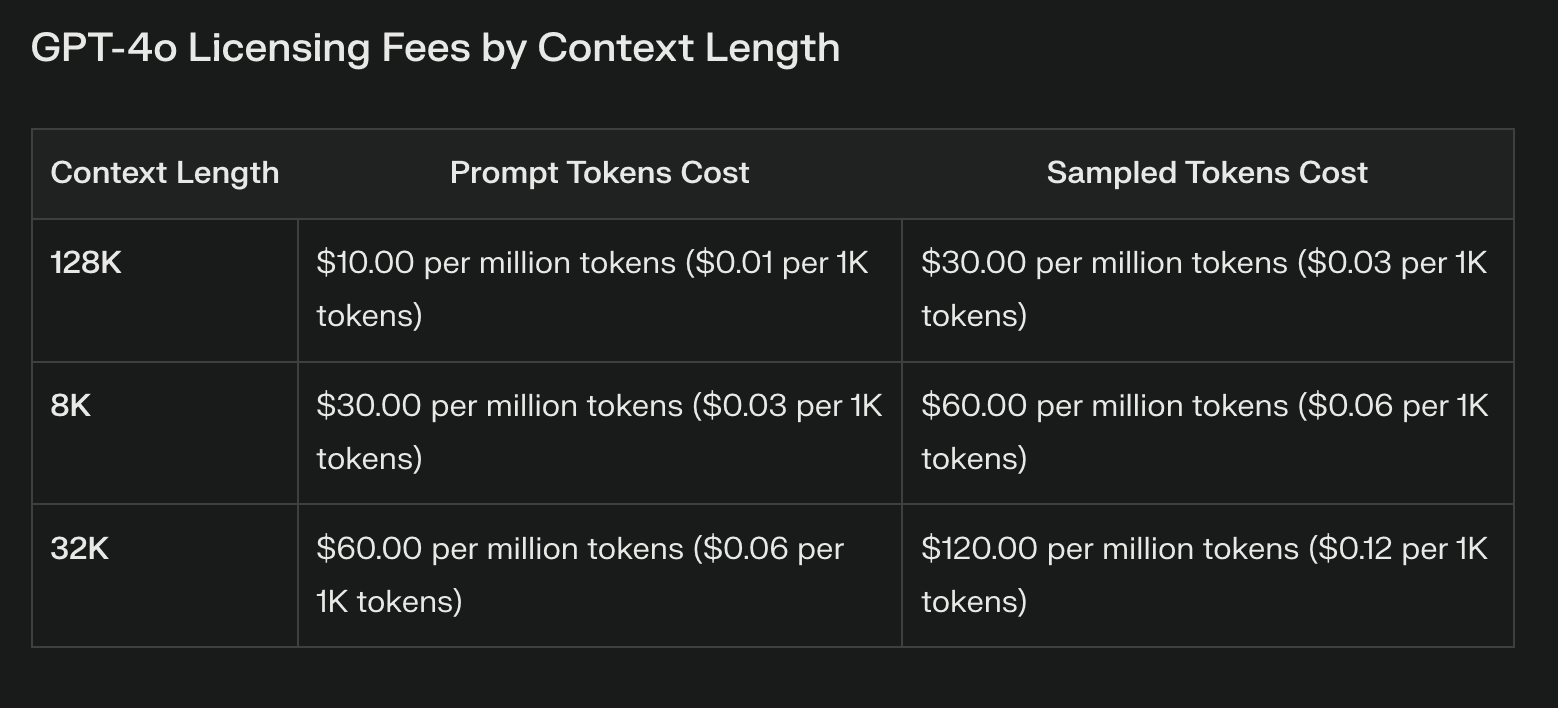

La differenza di costo più evidente tra Llama 3.1 e i modelli proprietari risiede nei costi di licenza. I LLM proprietari spesso comportano costi ricorrenti sostanziali, che possono aumentare in modo significativo con l'utilizzo. Questi costi, pur fornendo l'accesso a una tecnologia all'avanguardia, possono gravare sui bilanci e limitare la sperimentazione.

Llama 3.1, con i suoi pesi aperti, elimina completamente i costi di licenza. Questo risparmio può essere sostanziale, soprattutto per le aziende che stanno pianificando un'ampia implementazione dell'intelligenza artificiale. Tuttavia, è fondamentale notare che l'assenza di costi di licenza non equivale a costi zero.

Costi dell'infrastruttura e dell'implementazione

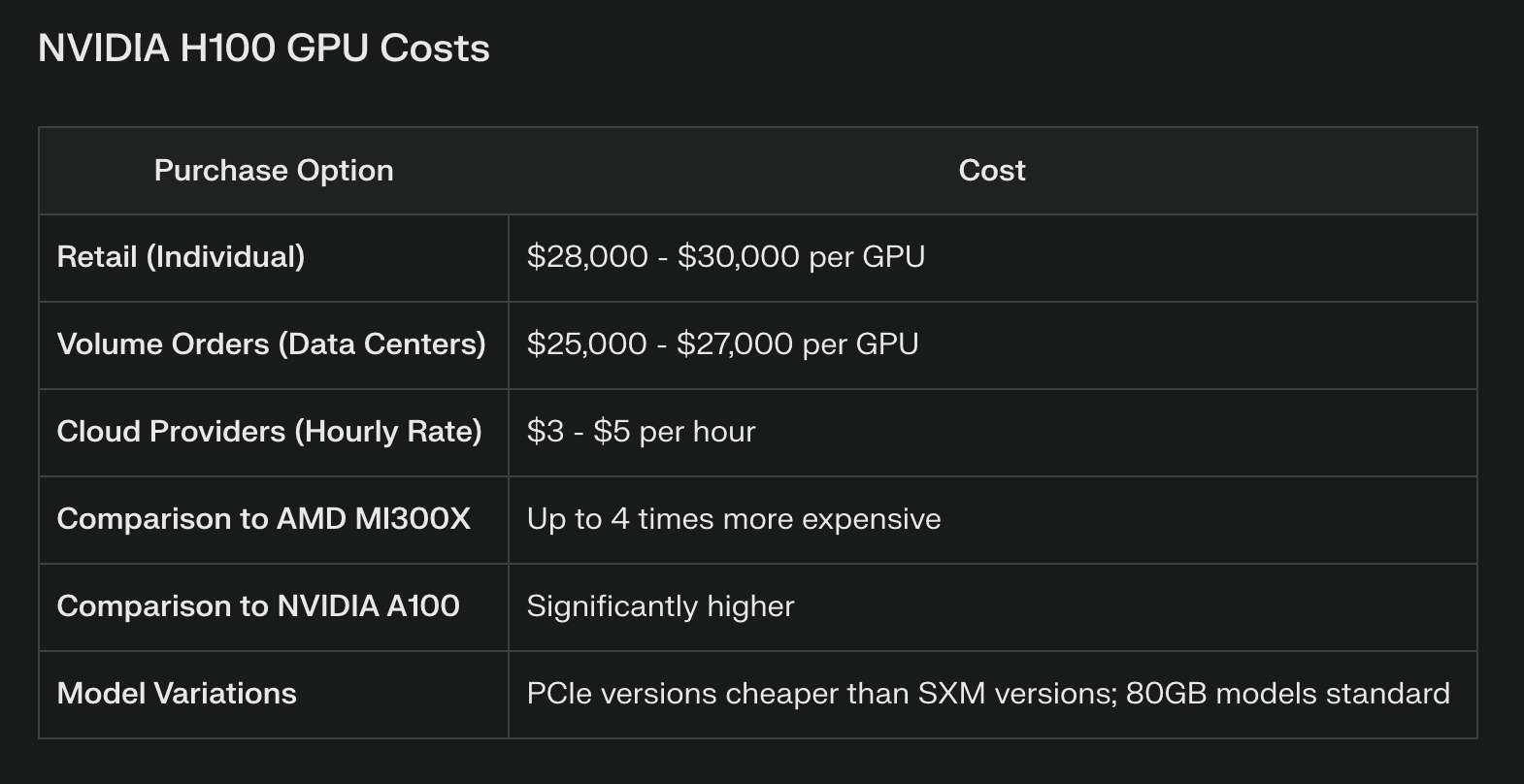

Se da un lato Llama 3.1 può far risparmiare sulle licenze, dall'altro richiede notevoli risorse di calcolo, in particolare per il modello dei parametri 405B. Le aziende devono investire in una solida infrastruttura hardware, che spesso comprende cluster di GPU di fascia alta o risorse di cloud computing. Ad esempio, l'esecuzione efficiente dell'intero modello 405B può richiedere più GPU NVIDIA H100, il che rappresenta una spesa di capitale considerevole.

I modelli proprietari, in genere accessibili tramite API, scaricano questi costi di infrastruttura sul fornitore. Ciò può essere vantaggioso per le aziende che non dispongono delle risorse o delle competenze necessarie per gestire una complessa infrastruttura di IA. Tuttavia, anche le chiamate API ad alto volume possono accumulare rapidamente i costi, superando potenzialmente i risparmi iniziali sull'infrastruttura.

Manutenzione e aggiornamenti continui

Il mantenimento di un modello di peso aperto come Llama 3.1 richiede un investimento continuo in competenze e risorse. Le aziende devono stanziare un budget per:

Aggiornamenti regolari del modello e messa a punto

Patch di sicurezza e gestione delle vulnerabilità

Ottimizzazione delle prestazioni e miglioramento dell'efficienza

I modelli proprietari spesso includono questi aggiornamenti come parte del loro servizio, riducendo potenzialmente l'onere per i team interni. Tuttavia, questa comodità ha il costo di un controllo ridotto sul processo di aggiornamento e di potenziali interruzioni della messa a punto dei modelli.

Confronto delle prestazioni

Risultati del benchmark su diversi compiti

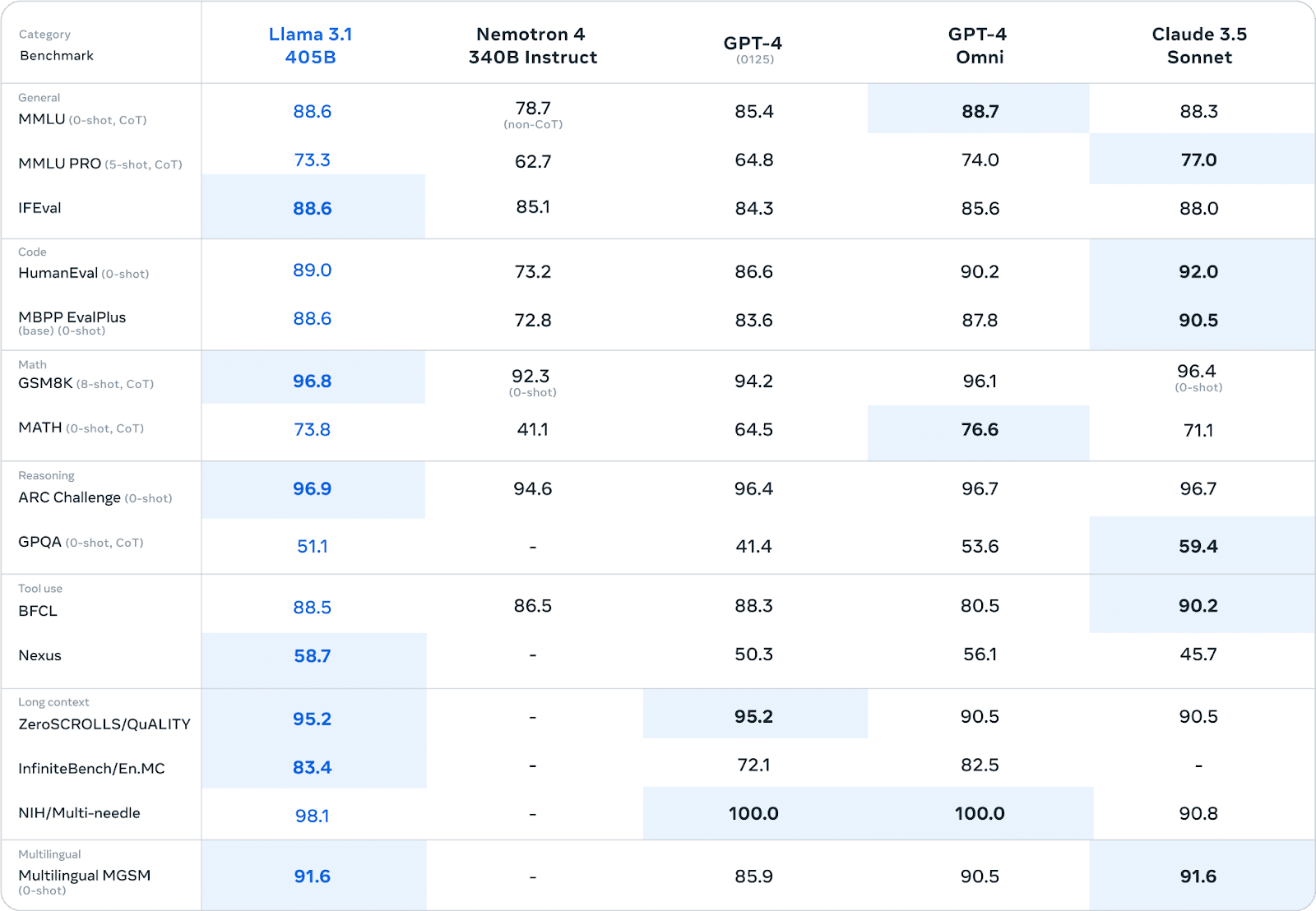

Llama 3.1 ha dimostrato prestazioni impressionanti in vari benchmark, spesso rivaleggiando o superando i modelli proprietari. In ampie valutazioni umane e test automatici, la versione con 405B parametri ha dimostrato prestazioni paragonabili ai principali modelli closed-source in aree quali:

Conoscenza generale e ragionamento

Generazione e debug del codice

Risoluzione di problemi matematici

Competenza multilingue

Ad esempio, nel benchmark MMLU (Massive Multitask Language Understanding), Llama 3.1 405B ha ottenuto un punteggio di 86,4%, ponendosi in diretta concorrenza con modelli come il GPT-4.

Prestazioni nel mondo reale in ambienti aziendali

Sebbene i benchmark forniscano indicazioni preziose, le prestazioni reali in ambito aziendale sono il vero banco di prova delle capacità di un LLM.

Qui il quadro diventa più sfumato:

Vantaggio della personalizzazione: Le aziende che utilizzano Llama 3.1 riferiscono di aver tratto notevoli vantaggi dalla messa a punto del modello su dati specifici del dominio. Questa personalizzazione spesso si traduce in prestazioni che superano quelle dei modelli proprietari per compiti specializzati.

Generazione di dati sintetici: La capacità di Llama 3.1 di generare dati sintetici si è rivelata preziosa per le aziende che desiderano aumentare i propri set di dati di formazione o simulare scenari complessi.

Scambi di efficienzaAlcune aziende hanno scoperto che, mentre i modelli proprietari possono avere un leggero vantaggio in termini di prestazioni, la capacità di creare modelli specializzati ed efficienti attraverso tecniche come la distillazione dei modelli con Llama 3.1 porta a risultati complessivi migliori negli ambienti di produzione.

Considerazioni sulla latenza: I modelli proprietari a cui si accede tramite API possono offrire una latenza inferiore per le singole query, che può essere fondamentale per le applicazioni in tempo reale. Tuttavia, le aziende che eseguono Llama 3.1 su hardware dedicato riportano prestazioni più costanti in presenza di carichi elevati.

Vale la pena notare che i confronti delle prestazioni dipendono fortemente da casi d'uso specifici e da dettagli di implementazione. Le aziende devono condurre test approfonditi nei loro ambienti specifici per effettuare valutazioni accurate delle prestazioni.

Considerazioni a lungo termine

Lo sviluppo futuro di LLM è un fattore critico nel processo decisionale. Llama 3.1 beneficia di una rapida iterazione guidata da una comunità di ricerca globale, che può portare a miglioramenti rivoluzionari. I modelli proprietari, sostenuti da aziende ben finanziate, offrono aggiornamenti costanti e la possibilità di integrare tecnologie proprietarie.

Il Mercato LLM è incline alla rottura. Poiché i modelli aperti come Llama 3.1 si avvicinano o superano le prestazioni delle alternative proprietarie, potremmo assistere a una tendenza alla mercificazione dei modelli di base e a una maggiore specializzazione. Anche le normative emergenti in materia di IA potrebbero avere un impatto sulla fattibilità dei diversi approcci LLM.

L'allineamento con le più ampie strategie aziendali di IA è fondamentale. L'adozione di Llama 3.1 può favorire lo sviluppo di competenze interne in materia di IA, mentre l'impegno nei confronti di modelli proprietari può portare a partnership strategiche con giganti tecnologici.

Quadro decisionale

Gli scenari che favoriscono Llama 3.1 includono:

Applicazioni industriali altamente specializzate che richiedono un'ampia personalizzazione

Imprese con forti team interni di AI in grado di gestire i modelli

Le aziende danno priorità alla sovranità dei dati e al controllo completo dei processi di IA

Gli scenari che favoriscono i modelli proprietari includono:

Necessità di un'implementazione immediata con una configurazione minima dell'infrastruttura

Necessità di un'ampia assistenza da parte del fornitore e di SLA garantiti

Integrazione con gli ecosistemi proprietari di IA esistenti

Il bilancio

La scelta tra Llama 3.1 e gli LLM proprietari rappresenta un punto critico per le aziende che si affacciano sul panorama dell'intelligenza artificiale. Se da un lato Llama 3.1 offre una flessibilità senza precedenti, un potenziale di personalizzazione e un risparmio sui costi di licenza, dall'altro richiede un investimento significativo in infrastrutture e competenze. I modelli proprietari offrono facilità d'uso, assistenza solida e aggiornamenti costanti, ma al costo di un controllo ridotto e di un potenziale vendor lock-in. In definitiva, la decisione dipende dalle esigenze specifiche, dalle risorse e dalla strategia di AI a lungo termine di un'azienda. Valutando con attenzione i fattori delineati in questa analisi, i responsabili delle decisioni possono tracciare un percorso che si allinei al meglio con gli obiettivi e le capacità della loro organizzazione.