Notre pile de 4 outils et notre stratégie pour créer des applications d'entreprise sur les LLM - AI&YOU#53

La statistique/le fait de la semaine : Le marché mondial du LLM devrait passer de 1T4T1,59 milliard en 2023 à 1T4T259,8 milliards en 2030, soit un TCAC de 79,81T3 au cours de la période 2023-2030 (Springs).

Les grands modèles de langage (LLM) sont apparus comme la clé de la construction d'applications d'entreprise intelligentes. Cependant, l'exploitation de la puissance de ces modèles de langage nécessite une pile d'applications LLM robuste et efficace.

Chez Skim AI, notre pile d'applications LLM nous permet de créer des applications puissantes dotées de capacités avancées d'interaction avec le langage naturel. Notre pile comprend des outils et des cadres soigneusement sélectionnés, comme les API LLM, LangChain et les bases de données vectorielles.

Dans l'édition de cette semaine d'AI&YOU, nous mettons en avant notre pile de 4 outils et notre stratégie pour construire des applications LLM d'entreprise à travers les blogs que nous avons publiés :

Comment construire votre pile d'applications LLM avec ces 4 outils et frameworks

Les 5 meilleures stratégies d'intégration de l'API LLM pour votre entreprise

- Nos 4 outils et notre stratégie pour créer des applications d'entreprise sur les LLM - AI&YOU #53

- Outil 1 : Une API LLM comme GPT, Claude, Llama ou Mistral

- Facteurs à prendre en considération lors du choix d'une API LLM

- Outil 2 : LangChain

- Les différents outils et le support de LangChain

- Outil 3 : Une base de données vectorielle comme Chroma

- Intégrer Chroma dans votre pile LLM d'entreprise

- Outil 4 : crewAI pour les systèmes multi-agents

- Tirer parti du pouvoir de la spécialisation

- Exploiter la puissance des LLM avec la bonne pile d'applications

- Les 5 meilleures stratégies d'intégration de l'API LLM pour votre entreprise

- Les 5 meilleurs LLM Open Source pour votre entreprise

Nos 4 outils et notre stratégie pour créer des applications d'entreprise sur les LLM - AI&YOU #53

Avec notre pile LLM d'entreprise, les développeurs peuvent en toute transparence intégrer données spécifiques à un domaine, affiner les modèles, créer des pipelines de données efficaces pour extraire des données contextuelles, etc.

Les entreprises peuvent ainsi créer des applications qui comprennent les requêtes des utilisateurs et y répondent avec une précision et une prise en compte du contexte sans précédent.

En même temps, l'une des principales techniques pour accompagner cette pile est d'utiliser les outils et les cadres existants fournis par les différents composants. Cela permet aux développeurs de se concentrer sur la création d'applications plutôt que de créer des outils à partir de zéro, ce qui leur permet de gagner un temps précieux et de réduire leurs efforts.

Outil 1 : Une API LLM comme GPT, Claude, Llama ou Mistral

Au cœur de votre pile d'applications LLM doit se trouver une API LLM. Les API LLM permettent d'intégrer de puissants modèles de langage dans vos applications sans avoir à former ou à héberger les modèles vous-même. Elles servent de passerelle entre votre logiciel et les algorithmes complexes qui alimentent les modèles de langage, ce qui vous permet d'ajouter des capacités avancées de traitement du langage naturel à vos applications avec un minimum d'effort.

L'un des principaux avantages de l'utilisation d'une API LLM est la possibilité d'exploiter des modèles linguistiques de pointe qui ont été formés sur de grandes quantités de données. Ces modèles, tels que GPT, Claude, Mistralet Lamassont capables de comprendre et de produire des textes de type humain avec une précision et une fluidité remarquables.

En faisant des appels d'API à ces modèles, vous pouvez rapidement ajouter à vos applications un large éventail de fonctionnalités, notamment la génération de texte, l'analyse des sentiments, la réponse aux questions, et bien plus encore.

Facteurs à prendre en considération lors du choix d'une API LLM

Lorsque vous choisissez une API LLM pour votre pile, vous devez tenir compte de plusieurs facteurs :

Performance et précision : Assurez-vous que l'API peut gérer votre charge de travail et fournir des résultats fiables.

Personnalisation et flexibilité : Déterminez si vous devez affiner le modèle pour votre cas d'utilisation spécifique ou l'intégrer à d'autres composants de votre pile.

Évolutivité : Si vous prévoyez d'importants volumes de demandes, assurez-vous que l'API peut évoluer en conséquence.

Soutien et communauté : Évaluez le niveau de soutien et la taille de la communauté autour de l'API, car cela peut avoir un impact sur la viabilité à long terme de votre application.

Au cœur de la plupart des API LLM se trouvent des réseaux neuronaux profonds, généralement basés sur des architectures de transformateurs, qui sont formés sur des quantités massives de données textuelles. Ces modèles sont accessibles via une interface API, qui gère des tâches telles que l'authentification, l'acheminement des demandes et le formatage des réponses. Les API LLM comprennent souvent des composants supplémentaires pour le traitement des données, tels que la symbolisation et la normalisation, ainsi que des outils pour le réglage fin et la personnalisation.

Outil 2 : LangChain

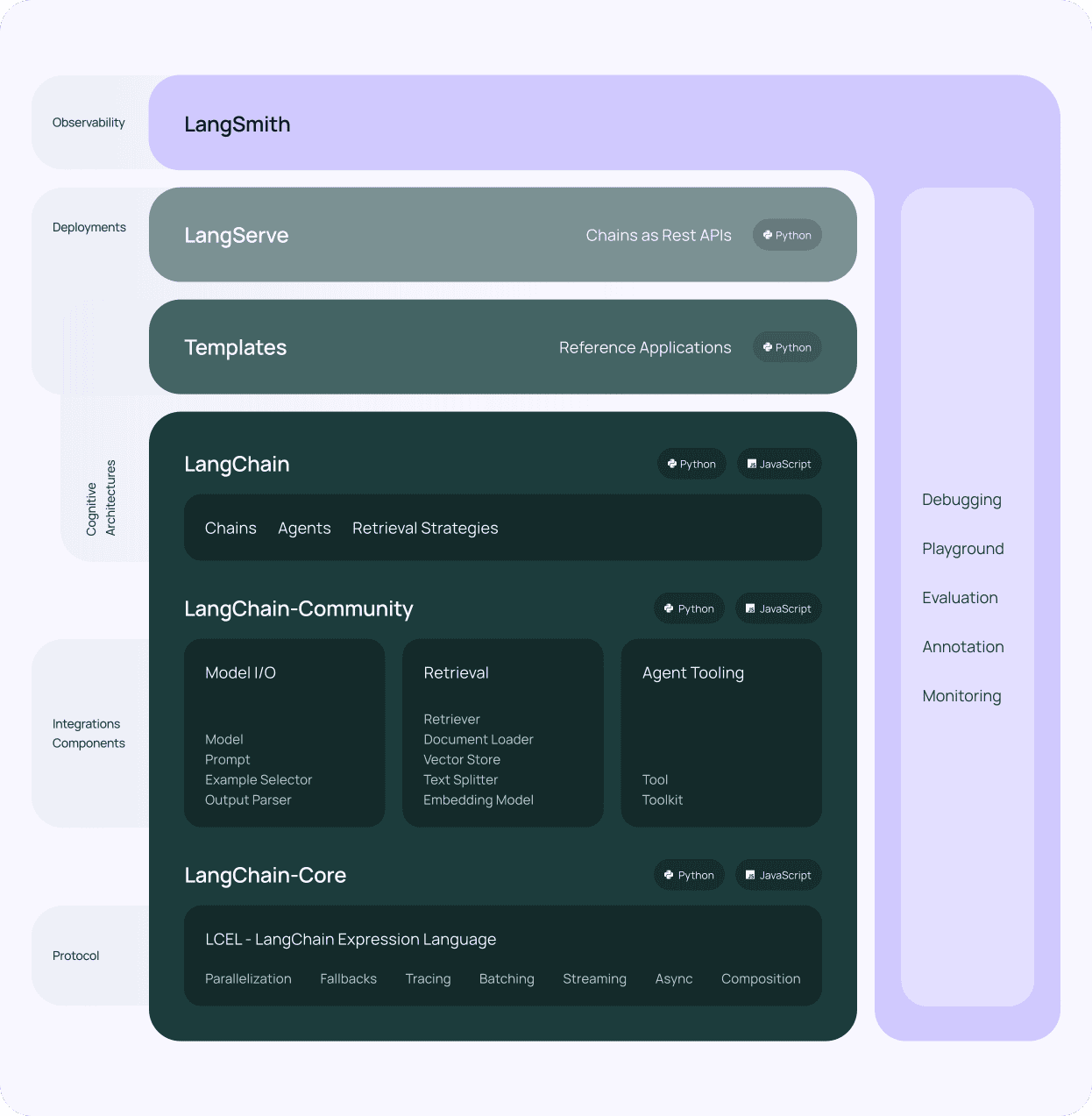

Après avoir sélectionné une API LLM pour votre pile d'applications LLM, le composant suivant à prendre en compte est le suivant LangChain. LangChain est un cadre puissant conçu pour simplifier le processus de création d'applications à partir de grands modèles de langage. Il fournit une interface standardisée pour interagir avec les différentes API LLM, ce qui facilite leur intégration dans votre pile technologique LLM.

L'un des principaux avantages de LangChain est son architecture modulaire. LangChain se compose de plusieurs éléments, tels que des invites, des chaînes, des agents et des mémoires, qui peuvent être combinés pour créer des flux de travail complexes. Cette modularité vous permet de créer des applications capables de gérer un large éventail de tâches, de la simple réponse à une question à des cas d'utilisation plus avancés tels que la génération de contenu et l'analyse de données, permettant une interaction en langage naturel avec vos données spécifiques à un domaine.

Les différents outils et le support de LangChain

LangChain fournit également une variété d'outils et d'utilitaires qui simplifient le travail avec les LLM. Par exemple, il offre des outils pour travailler avec les embeddings, qui sont des représentations numériques du texte utilisées pour des tâches telles que la recherche sémantique et le clustering. En outre, LangChain comprend des utilitaires pour gérer les invites, qui sont les chaînes d'entrée utilisées pour guider le comportement des modèles de langage.

Une autre caractéristique essentielle de LangChain est sa prise en charge des bases de données vectorielles. En intégrant des bases de données vectorielles comme Chroma (que nous utilisons), LangChain vous permet de créer des applications capables de stocker et d'extraire efficacement de grandes quantités de données. Cette intégration vous permet de créer des applications à forte intensité de connaissances qui peuvent s'appuyer sur un large éventail de sources d'information, améliorant ainsi la récupération de données contextuelles pour votre pile d'applications LLM.

LangChain est un élément essentiel de toute entreprise LLM et de la pile d'applications. Sa conception modulaire, ses outils puissants et sa communauté active en font un outil indispensable pour la création d'applications sophistiquées basées sur des langages.

Outil 3 : Une base de données vectorielle comme Chroma

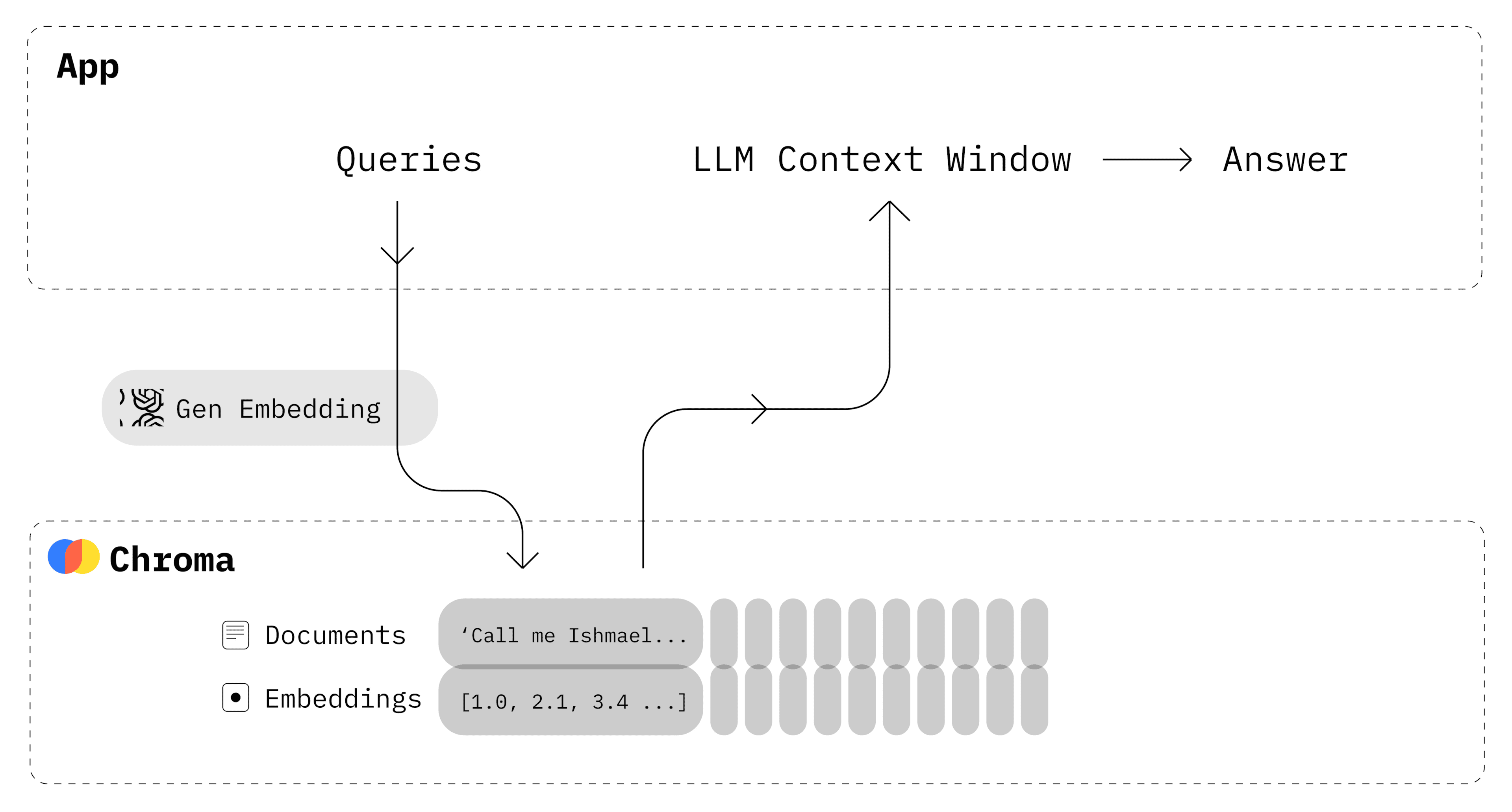

Outre l'API LLM et LangChain, un autre composant essentiel de votre pile d'applications LLM est une base de données vectorielle. Les bases de données vectorielles sont des magasins de données spécialisés optimisés pour le stockage et la recherche de vecteurs à haute dimension, tels que les embeddings générés par de grands modèles de langage. En intégrant une base de données vectorielle dans votre pile technologique LLM, vous pouvez permettre une récupération rapide et efficace des données pertinentes sur la base de la similarité sémantique.

Chroma est un choix open-source populaire pour une base de données vectorielle dans les piles d'applications LLM, et nous l'utilisons ici à Skim AI. Il est conçu pour fonctionner de manière transparente avec LangChain et d'autres composants de votre pile, fournissant une solution robuste et évolutive pour le stockage et la récupération des embeddings.

L'un des principaux avantages de l'utilisation de Chroma est sa capacité à traiter efficacement de grands volumes de données. Chroma utilise des techniques d'indexation avancées pour permettre une recherche rapide par similarité, même sur des ensembles de données massifs. Il s'agit donc d'un choix idéal pour les applications qui doivent stocker et rechercher de grandes quantités de données textuelles, telles que les référentiels de documents, les bases de connaissances et les systèmes de gestion de contenu.

Chroma offre également des fonctionnalités avancées telles que le filtrage et la prise en charge des métadonnées. Vous pouvez stocker des métadonnées supplémentaires à côté de vos incorporations, telles que des identifiants de documents, des horodatages ou des attributs personnalisés. Ces métadonnées peuvent être utilisées pour filtrer les résultats de la recherche, ce qui permet une récupération plus précise et plus ciblée des données contextuelles.

Intégrer Chroma dans votre pile LLM d'entreprise

L'intégration de Chroma dans votre pile d'applications LLM est simple, grâce à sa compatibilité avec LangChain et d'autres outils et cadres populaires. LangChain fournit un support intégré pour Chroma, facilitant le stockage et la récupération des embeddings générés par vos modèles de langage. Cette intégration vous permet de créer de puissants mécanismes d'extraction qui peuvent rapidement faire apparaître des informations pertinentes basées sur l'interaction avec le langage naturel.

L'utilisation d'une base de données vectorielles comme Chroma en conjonction avec les LLM ouvre de nouvelles possibilités pour la création d'applications intelligentes et sensibles au contexte. En exploitant la puissance des embeddings et de la recherche par similarité, vous pouvez créer des applications capables de comprendre les requêtes des utilisateurs et d'y répondre avec une précision et une pertinence sans précédent.

Associé à LangChain et à une API LLM, Chroma constitue une base puissante pour la création d'applications intelligentes, axées sur les données, qui peuvent transformer la manière dont nous interagissons avec les données d'entreprise et les informations spécifiques à un domaine.

Outil 4 : crewAI pour les systèmes multi-agents

Chez Skim AI, nous savons que l'avenir des flux de travail d'IA est agentique, c'est pourquoi un système multi-agents est important pour toute entreprise aujourd'hui.

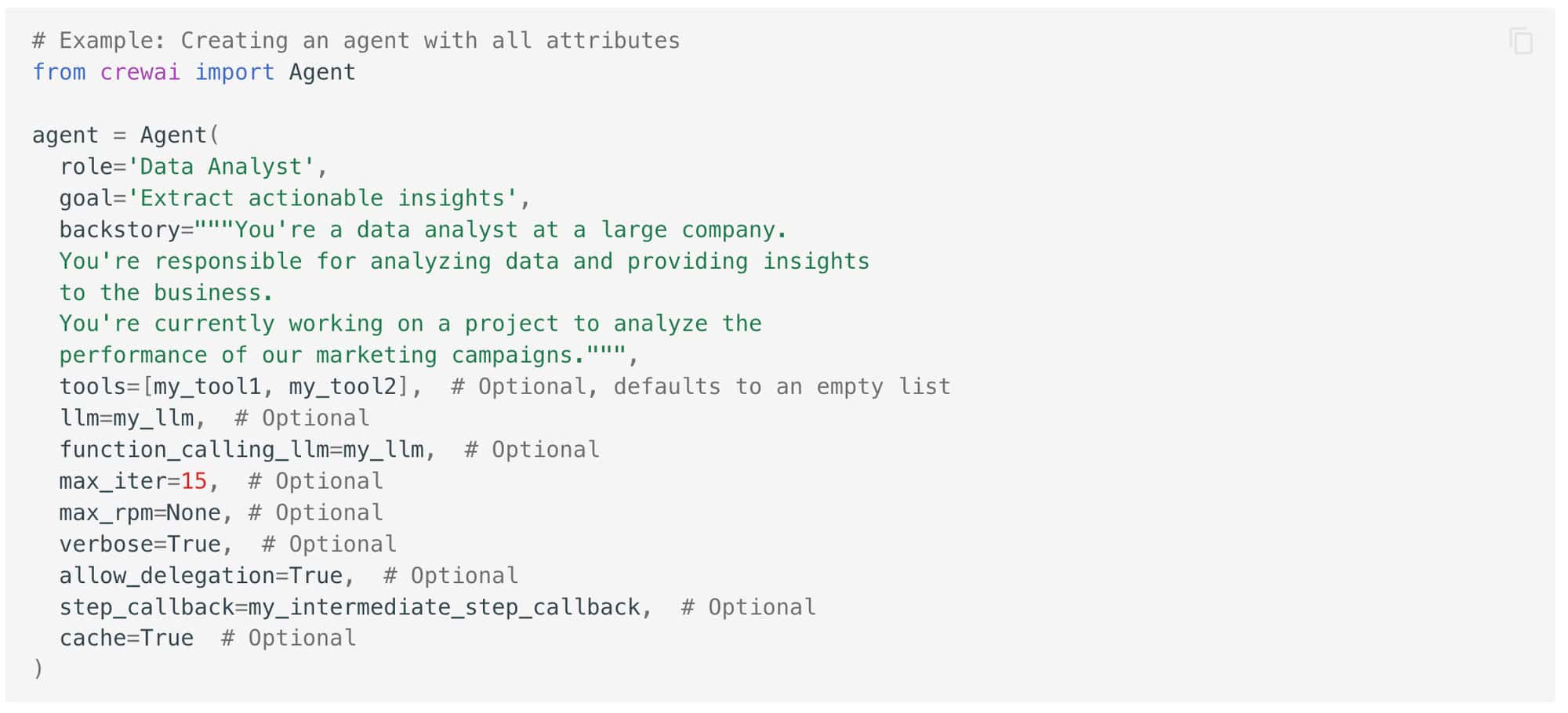

équipageAI est un autre outil puissant que vous pouvez ajouter à votre pile d'applications LLM pour améliorer les capacités de vos applications. crewAI est un cadre qui vous permet de créer des systèmes multi-agents, où plusieurs agents d'intelligence artificielle travaillent ensemble pour accomplir des tâches complexes.

À la base, crewAI est conçu pour faciliter la collaboration entre plusieurs agents d'intelligence artificielle, chacun ayant un rôle et une expertise spécifiques. Ces agents peuvent communiquer et se coordonner pour décomposer des problèmes complexes en sous-tâches plus petites et plus faciles à gérer.

Tirer parti du pouvoir de la spécialisation

L'un des principaux avantages de l'utilisation de crewAI dans votre pile technologique LLM est sa capacité à tirer parti de la puissance de la spécialisation. En assignant des rôles et des tâches spécifiques à différents agents, vous pouvez créer un système plus efficace qu'un modèle d'IA unique et monolithique. Chaque agent peut être formé et optimisé pour sa tâche particulière, ce qui lui permet d'atteindre un niveau de performance supérieur à celui d'un modèle polyvalent et d'extraire de manière plus ciblée des données contextuelles à partir de vos ensembles de données spécifiques à un domaine.

L'utilisation de crewAI en combinaison avec d'autres composants de votre pile technologique LLM peut vous aider à ouvrir de nouvelles possibilités pour construire des systèmes intelligents et multi-agents qui peuvent gérer des tâches complexes dans le monde réel. En exploitant la puissance de la spécialisation et de la collaboration, vous pouvez créer des applications plus efficaces et plus conviviales que les approches traditionnelles à modèle unique.

Exploiter la puissance des LLM avec la bonne pile d'applications

Cette pile vous permet d'intégrer de manière transparente des données spécifiques à un domaine, d'extraire efficacement des informations contextuelles et de créer des flux de travail sophistiqués capables de relever des défis complexes dans le monde réel. En exploitant la puissance de ces outils et cadres, vous pouvez repousser les limites de ce qui est possible avec les applications d'IA basées sur le langage et créer des systèmes véritablement intelligents qui peuvent transformer la façon dont votre entreprise interagit avec les données et la technologie.

Les 5 meilleures stratégies d'intégration de l'API LLM pour votre entreprise

Cette semaine, nous avons également exploré les 5 meilleures stratégies d'intégration de l'API LLM pour votre entreprise.

De l'intégration modulaire au contrôle et à l'optimisation continus, ces stratégies sont conçues pour garantir une mise en œuvre harmonieuse, des performances optimales et un succès à long terme.

Intégration modulaire consiste à décomposer le processus d'intégration de l'API LLM en modules plus petits et plus faciles à gérer, qui peuvent être mis en œuvre de manière incrémentielle. Cette approche permet une mise en œuvre progressive, un dépannage plus facile et des mises à jour et améliorations plus souples.

Un Passerelle API agit comme un point d'entrée unique pour toutes les demandes d'API, en gérant l'authentification, la limitation du débit et l'acheminement des demandes. Il fournit une authentification centralisée, une limitation du débit et des informations précieuses sur l'utilisation et les performances de l'API.

Architecture microservices consiste à décomposer une application monolithique en services plus petits, faiblement couplés, qui peuvent être développés, déployés et mis à l'échelle de manière indépendante. Cela permet un développement indépendant, une évolutivité granulaire, ainsi qu'une agilité et une flexibilité accrues.

Personnaliser et affiner les API LLM implique de les adapter pour mieux répondre aux exigences spécifiques de l'industrie, du domaine ou de l'application. Cela améliore la précision et la pertinence des résultats et permet de s'aligner sur la terminologie, les styles et les formats.

Contrôle et optimisation continus impliquent le suivi des mesures de performance, l'évaluation de la qualité/pertinence des résultats et la réalisation d'améliorations itératives. Cela permet d'identifier les problèmes de manière proactive, de s'adapter aux exigences changeantes et d'améliorer continuellement la valeur des intégrations API LLM.

Alors que le domaine de la technologie LLM continue d'évoluer à un rythme rapide, les entreprises qui investissent dans des stratégies d'intégration robustes, évolutives et adaptables seront bien placées pour libérer tout le potentiel de ces outils transformateurs.

Les 5 meilleurs LLM Open Source pour votre entreprise

Les modèles linguistiques à grande échelle (LLM) à source ouverte ont émergé en tant qu'outil d'aide à la décision. un outil puissant pour les entreprises en 2024.

L'un des principaux avantages de l'utilisation de LLM à code source ouvert est la flexibilité et la personnalisation qu'ils offrent. En outre, les LLM open-source constituent une alternative rentable au développement et à la maintenance de modèles propriétaires. En tirant parti des efforts collectifs de la communauté de l'IA, les entreprises peuvent accéder à des modèles linguistiques de pointe sans avoir à investir massivement dans la recherche et le développement.

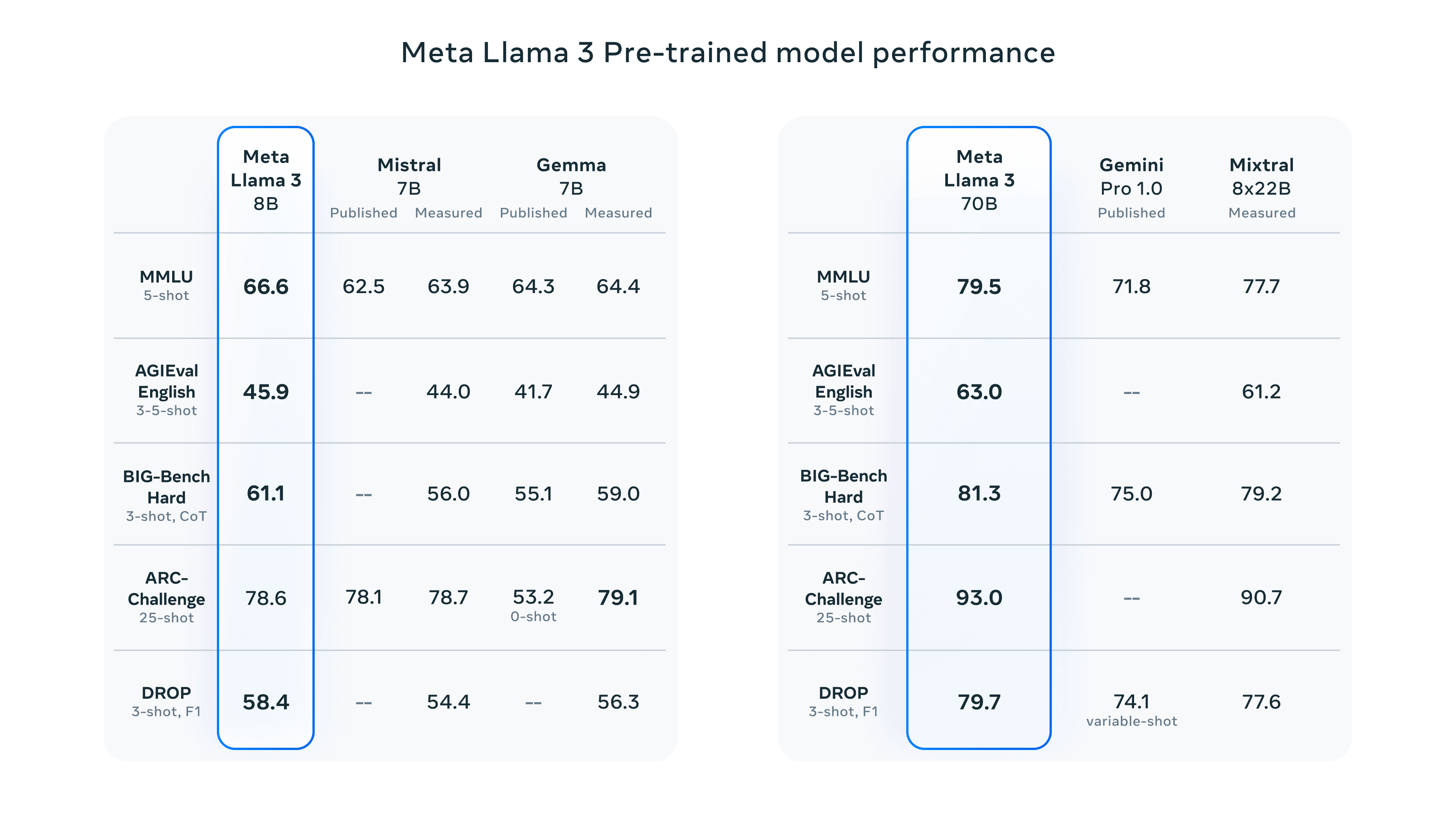

Llama 3 par Meta : Llama 3 est un grand modèle linguistique open-source de pointe, avec deux variantes de taille (paramètres 8B et 70B), chacune offrant des modèles Base et Instruct. Il excelle dans diverses tâches NLP, est facile à déployer et adhère à des pratiques d'IA responsables.

Claude 3 par Anthropic : Claude 3 se décline en trois variantes (Haiku, Sonnet, Opus) optimisées pour différents cas d'utilisation. Il démontre des performances impressionnantes dans des tâches cognitives telles que le raisonnement, la connaissance experte et la maîtrise de la langue, surpassant des modèles tels que GPT-4.

Grok par xAI : Grok, développé par xAI d'Elon Musk, est spécialisé dans le résumé et la compréhension de textes. Sa dernière itération, Grok-1.5, introduit la compréhension des contextes longs, le raisonnement avancé et de solides capacités de codage et de calcul.

BERT par Google : BERT a été le pionnier de la compréhension bidirectionnelle du langage et excelle dans des tâches telles que la classification des textes, l'analyse des sentiments et la réponse aux questions. Son pré-entraînement lui permet de générer des textes semblables à ceux d'un humain et de fournir des réponses pertinentes en fonction du contexte.

Mistral Large par Mistral AI : Mistral Large, avec ses paramètres 314B, se distingue dans les tâches de raisonnement complexes et les applications spécialisées. Il offre une assistance multilingue, un suivi des instructions et des capacités d'appel de fonctions, ce qui renforce sa polyvalence.

Alors que la communauté de l'IA en open source continue de repousser les limites de ce qui est possible avec les modèles de langage, les entreprises qui adoptent ces outils puissants seront bien placées pour rester à la pointe du progrès et obtenir un succès à long terme.

Pour obtenir encore plus de contenu sur l'IA d'entreprise, y compris des infographies, des statistiques, des guides pratiques, des articles et des vidéos, suivez Skim AI sur LinkedIn

Vous êtes un fondateur, un PDG, un investisseur en capital-risque ou un investisseur à la recherche de services de conseil ou de due diligence en matière d'IA ? Obtenez les conseils dont vous avez besoin pour prendre des décisions éclairées concernant la stratégie de votre entreprise en matière de produits d'IA ou d'opportunités d'investissement.

Nous construisons des solutions d'IA personnalisées pour les entreprises financées par le capital-risque et le capital-investissement dans les secteurs suivants : Technologie médicale, agrégation de nouvelles/contenu, production de films et de photos, technologie éducative, technologie juridique, Fintech & Cryptocurrency.