Nous devons repenser la chaîne de pensée (CoT) qui incite l'IA&YOU #68

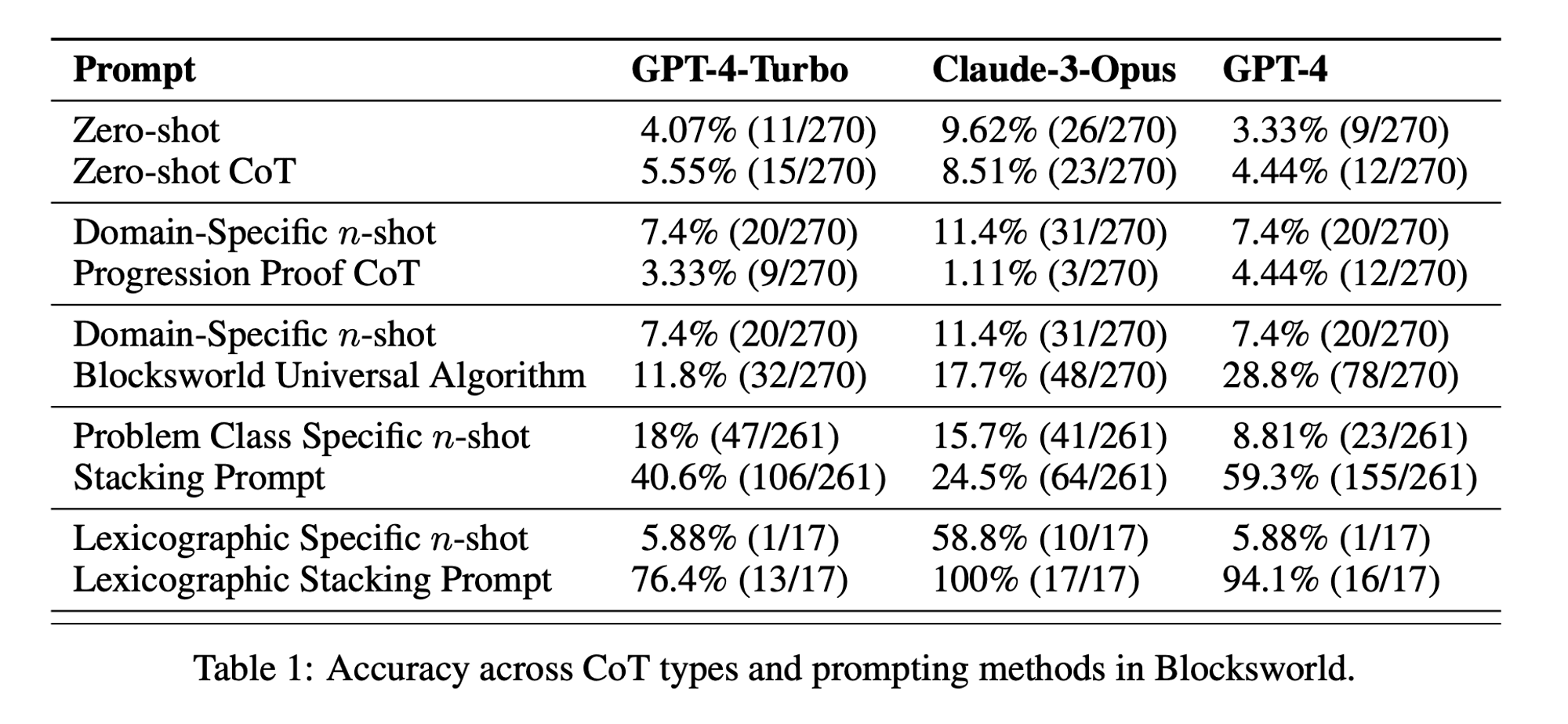

La statistique de la semaine : La performance CoT à zéro coup n'était que de 5,55% pour GPT-4-Turbo, 8,51% pour Claude-3-Opus, et 4,44% pour GPT-4. (Article "Chaîne de l'insouciance")

L'incitation à la chaîne de pensée (CoT) a été saluée comme une percée dans l'exploitation des capacités de raisonnement des grands modèles de langage (LLM). Toutefois, des recherches récentes ont remis en question ces affirmations et nous ont incités à réexaminer cette technique.

Dans l'édition de cette semaine de AI&YOU, nous explorons les perspectives de trois blogs que nous avons publiés sur le sujet :

La rupture d'un document de recherche sur l'IA : "La chaîne de l'irréflexion ?

10 meilleures techniques d'incitation pour les étudiants en master de droit

Nous devons repenser la chaîne de pensée (CoT) qui incite l'IA&YOU #68

Les LLMs démontrent des capacités remarquables dans le traitement et la génération du langage naturel (NLP). Cependant, lorsqu'ils sont confrontés à des tâches de raisonnement complexes, ces modèles peuvent avoir du mal à produire des résultats précis et fiables. C'est là qu'intervient l'incitation à la chaîne de pensée (CoT), une technique qui vise à améliorer les capacités de résolution de problèmes des LLM.

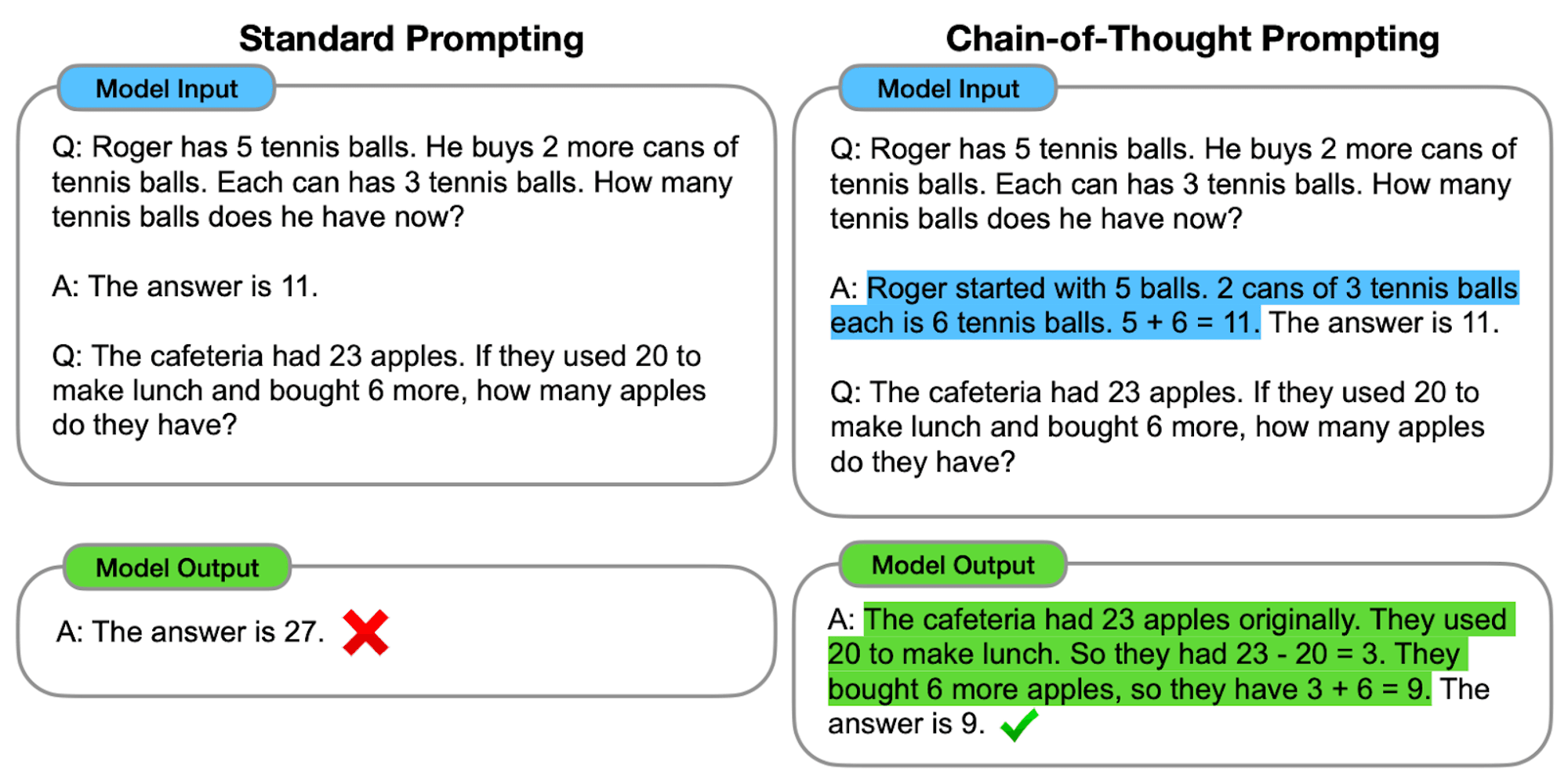

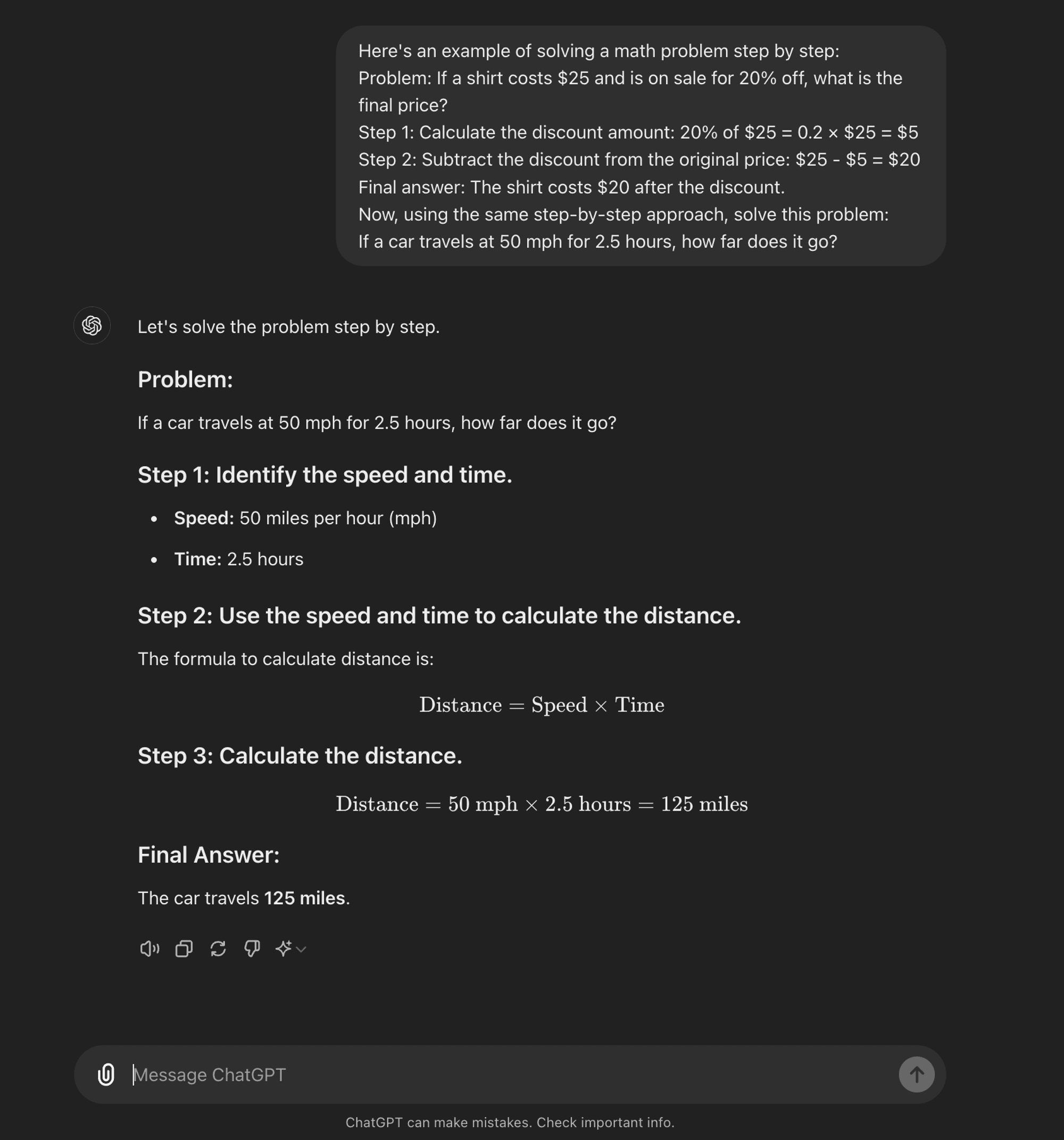

Un outil avancé ingénierie rapide La technique CoT est conçue pour guider les LLM à travers un processus de raisonnement étape par étape. Contrairement aux méthodes d'incitation standard qui visent à obtenir des réponses directes, l'incitation CoT encourage le modèle à générer des étapes de raisonnement intermédiaires avant d'arriver à une réponse finale.

À la base, l'incitation CoT implique la structuration d'invites d'entrée de manière à susciter une séquence logique de pensées de la part du modèle. En décomposant les problèmes complexes en étapes plus petites et plus faciles à gérer, le CoT tente de permettre aux LLM de naviguer plus efficacement à travers des chemins de raisonnement complexes.

Comment fonctionne le CdT

À la base, l'invite CoT guide les modèles linguistiques à travers une série d'étapes de raisonnement intermédiaires avant d'aboutir à une réponse finale. Ce processus implique généralement

Décomposition du problème : La tâche complexe est décomposée en étapes plus petites et plus faciles à gérer.

Raisonnement pas à pas : Le modèle est invité à réfléchir à chaque étape de manière explicite.

Progression logique : Chaque étape s'appuie sur la précédente, créant ainsi une chaîne de pensées.

Dessin de conclusion : La réponse finale est dérivée des étapes de raisonnement accumulées.

Types de messages-guides du CdT

L'incitation à la chaîne de pensée peut être mise en œuvre de différentes manières, deux types principaux se distinguant :

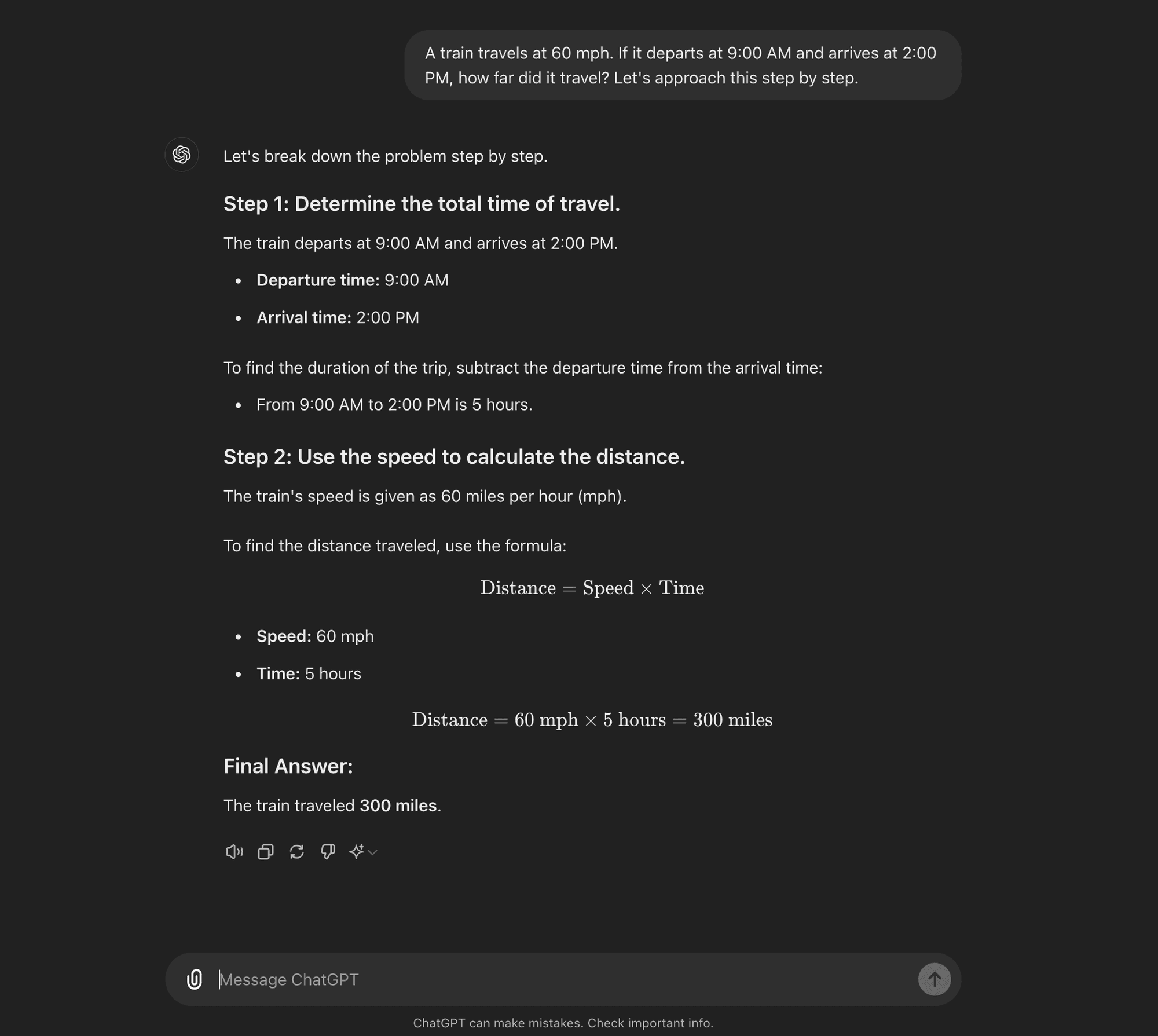

CoT à tir nul : Le CoT zéro n'exige pas d'exemples spécifiques à la tâche. Au lieu de cela, elle utilise une simple invite telle que "Abordons cette question étape par étape" pour encourager le modèle à décomposer son processus de raisonnement.****

CoT à quelques coups : Le CoT à quelques reprises consiste à fournir au modèle un petit nombre d'exemples qui illustrent le processus de raisonnement souhaité. Ces exemples servent de modèle au modèle lorsqu'il s'attaque à de nouveaux problèmes inédits.

CoT à tir nul

CoT à quelques coups

La rupture d'un document de recherche sur l'IA : "La chaîne de l'irréflexion ?

Maintenant que vous savez ce qu'est le CoT, nous allons nous pencher sur des recherches récentes qui remettent en question certains de ses avantages et qui permettent de mieux comprendre quand il est réellement utile.

Le document de recherche, intitulé "La chaîne de l'irréflexion ? Une analyse de l'approche par les coûts dans le domaine de la planification,L'étude "CoT prompting" fournit un examen critique de l'efficacité et de la généralisabilité de l'incitation CoT. En tant que praticiens de l'IA, il est essentiel de comprendre ces résultats et leurs implications pour le développement d'applications d'IA nécessitant des capacités de raisonnement sophistiquées.

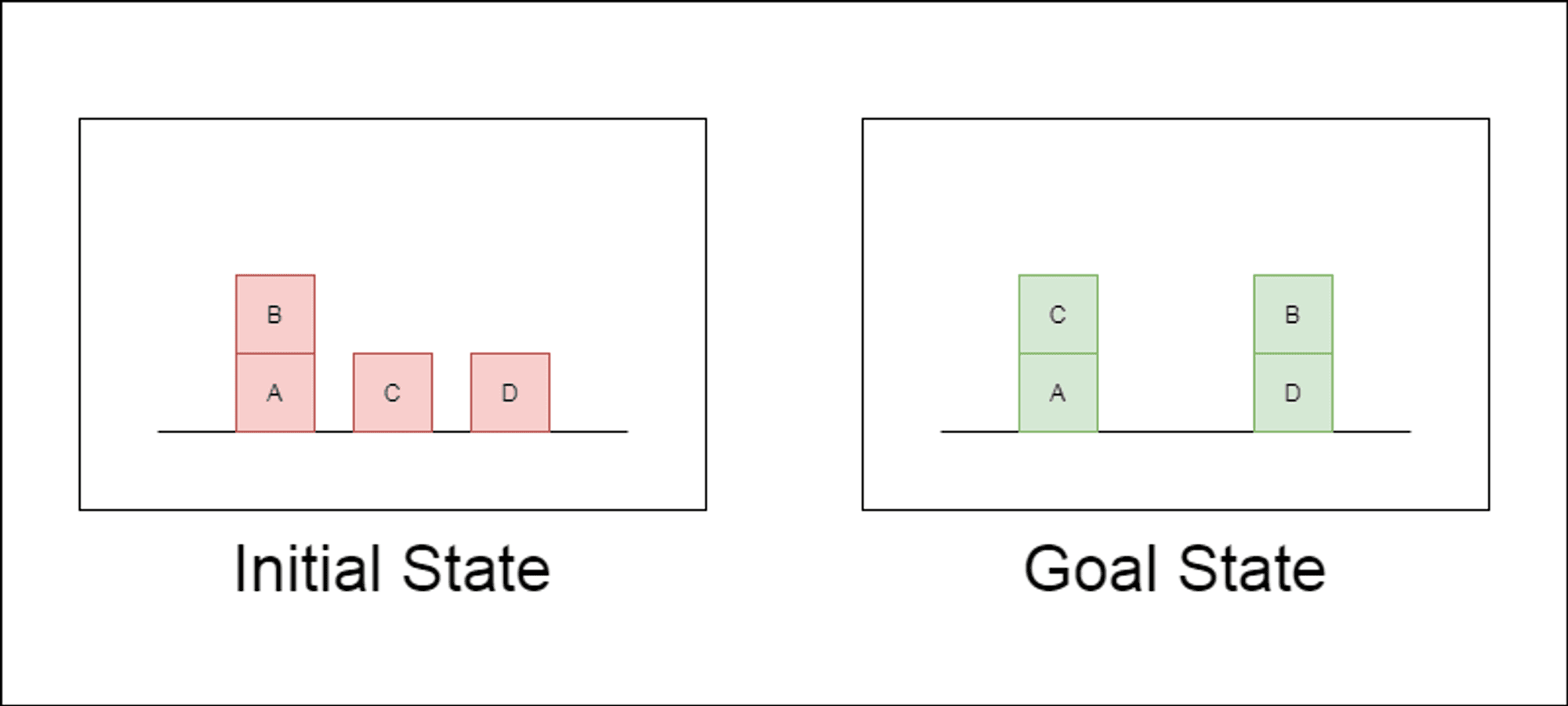

Les chercheurs ont choisi un domaine de planification classique appelé Blocksworld comme principal terrain d'essai. Dans Blocksworld, la tâche consiste à réorganiser un ensemble de blocs d'une configuration initiale à une configuration cible à l'aide d'une série d'actions de déplacement. Ce domaine est idéal pour tester les capacités de raisonnement et de planification pour les raisons suivantes :

Il permet de générer des problèmes de complexité variable

Il propose des solutions claires et vérifiables sur le plan algorithmique.

Il est peu probable qu'il soit fortement représenté dans les données de formation du LLM.

L'étude a examiné trois LLM de pointe : GPT-4, Claude-3-Opus et GPT-4-Turbo. Ces modèles ont été testés à l'aide d'invites de spécificité variable :

Chaîne de pensée à zéro coup (universelle) : Il suffit d'ajouter "réfléchissons étape par étape" à l'invite.

Preuve de progression (spécifique à la PDDL) : Fournir une explication générale de l'exactitude du plan avec des exemples.

Algorithme universel Blocksworld : Démonstration d'un algorithme général permettant de résoudre n'importe quel problème du monde des blocs.

Promesse d'empilage : Se concentrer sur une sous-classe spécifique des problèmes de Blocksworld (table à pile).

Empilement lexicographique : Réduction supplémentaire à une forme syntaxique particulière de l'état d'objectif.

En testant ces invites sur des problèmes de complexité croissante, les chercheurs ont voulu évaluer dans quelle mesure les LLM pouvaient généraliser le raisonnement démontré dans les exemples.

Les principaux résultats sont dévoilés

Les résultats de cette étude remettent en question de nombreuses idées reçues sur les messages de la CdT :

Efficacité limitée du CoT : Contrairement aux affirmations précédentes, l'invite CoT n'a montré une amélioration significative des performances que lorsque les exemples fournis étaient extrêmement similaires au problème de la requête. Dès que les problèmes s'écartent du format exact des exemples, les performances chutent brutalement.

Dégradation rapide des performances : Au fur et à mesure que la complexité des problèmes augmentait (mesurée par le nombre de blocs impliqués), la précision de tous les modèles diminuait considérablement, quelle que soit l'invite CoT utilisée. Cela suggère que les LLM ont du mal à étendre le raisonnement démontré dans des exemples simples à des scénarios plus complexes.

Inefficacité des messages d'incitation générale : Il est surprenant de constater que les messages plus généraux de la CoT sont souvent moins performants que les messages standard sans exemples de raisonnement. Cela contredit l'idée selon laquelle la CoT aide les LLM à apprendre des stratégies généralisables de résolution de problèmes.

Compromis de spécificité : L'étude a révélé que les messages guides très spécifiques pouvaient atteindre un niveau de précision élevé, mais seulement pour un sous-ensemble très étroit de problèmes. Cela met en évidence un compromis important entre les gains de performance et l'applicabilité de l'invite.

Absence de véritable apprentissage algorithmique : Les résultats suggèrent fortement que les LLM n'apprennent pas à appliquer des procédures algorithmiques générales à partir des exemples CoT. Au lieu de cela, ils semblent s'appuyer sur l'appariement de modèles, qui s'effondre rapidement lorsqu'ils sont confrontés à des problèmes nouveaux ou plus complexes.

Ces résultats ont des implications importantes pour les praticiens de l'IA et les entreprises qui cherchent à tirer parti de l'incitation CoT dans leurs applications. Ils suggèrent que si le CoT peut améliorer les performances dans certains scénarios étroits, il n'est peut-être pas la panacée pour les tâches de raisonnement complexes que beaucoup espéraient.

Implications pour le développement de l'IA

Les résultats de cette étude ont des implications importantes pour le développement de l'IA, en particulier pour les entreprises qui travaillent sur des applications nécessitant des capacités de raisonnement ou de planification complexes :

Réévaluation de l'efficacité de la formation continue : Les développeurs d'IA devraient être prudents et ne pas s'appuyer sur le CoT pour les tâches qui nécessitent une véritable réflexion algorithmique ou une généralisation à de nouveaux scénarios.

Limites des programmes d'éducation et de formation tout au long de la vie actuels : D'autres approches peuvent s'avérer nécessaires pour les applications nécessitant une planification solide ou la résolution de problèmes en plusieurs étapes.

Le coût de l'ingénierie rapide : Si les messages guides très spécifiques peuvent donner de bons résultats pour des ensembles de problèmes restreints, l'effort humain nécessaire pour élaborer ces messages guides peut l'emporter sur les avantages, surtout si l'on tient compte de leur faible capacité de généralisation.

Repenser les mesures d'évaluation : Le fait de s'appuyer uniquement sur des ensembles de tests statiques peut entraîner une surestimation des véritables capacités de raisonnement d'un modèle.

Le fossé entre la perception et la réalité : Il existe un écart important entre la perception des capacités de raisonnement des MFR (souvent anthropomorphisées dans le discours populaire) et leurs capacités réelles, comme le démontre cette étude.

Recommandations pour les praticiens de l'IA :

Évaluation : Mettre en œuvre divers cadres de test pour évaluer la généralisation réelle à travers la complexité des problèmes.

Utilisation du CoT : Appliquer judicieusement l'incitation à la chaîne de pensée, en reconnaissant ses limites en matière de généralisation.

Solutions hybrides: Envisager de combiner les LLM avec des algorithmes traditionnels pour les tâches de raisonnement complexes.

Transparence : Communiquer clairement les limites des systèmes d'IA, en particulier pour les tâches de raisonnement ou de planification.

L'accent sur la R&D : Investir dans la recherche pour améliorer les véritables capacités de raisonnement des systèmes d'intelligence artificielle.

Ajustement minutieux : Envisager un réglage fin spécifique au domaine, mais être conscient des limites potentielles de la généralisation.

Pour les praticiens et les entreprises de l'IA, ces résultats soulignent l'importance de combiner les forces du LLM avec des approches de raisonnement spécialisées, d'investir dans des solutions spécifiques au domaine si nécessaire, et de maintenir la transparence sur les limites des systèmes d'IA. À mesure que nous avançons, la communauté de l'IA doit se concentrer sur le développement de nouvelles architectures et méthodes de formation qui peuvent combler le fossé entre l'appariement de modèles et le véritable raisonnement algorithmique.

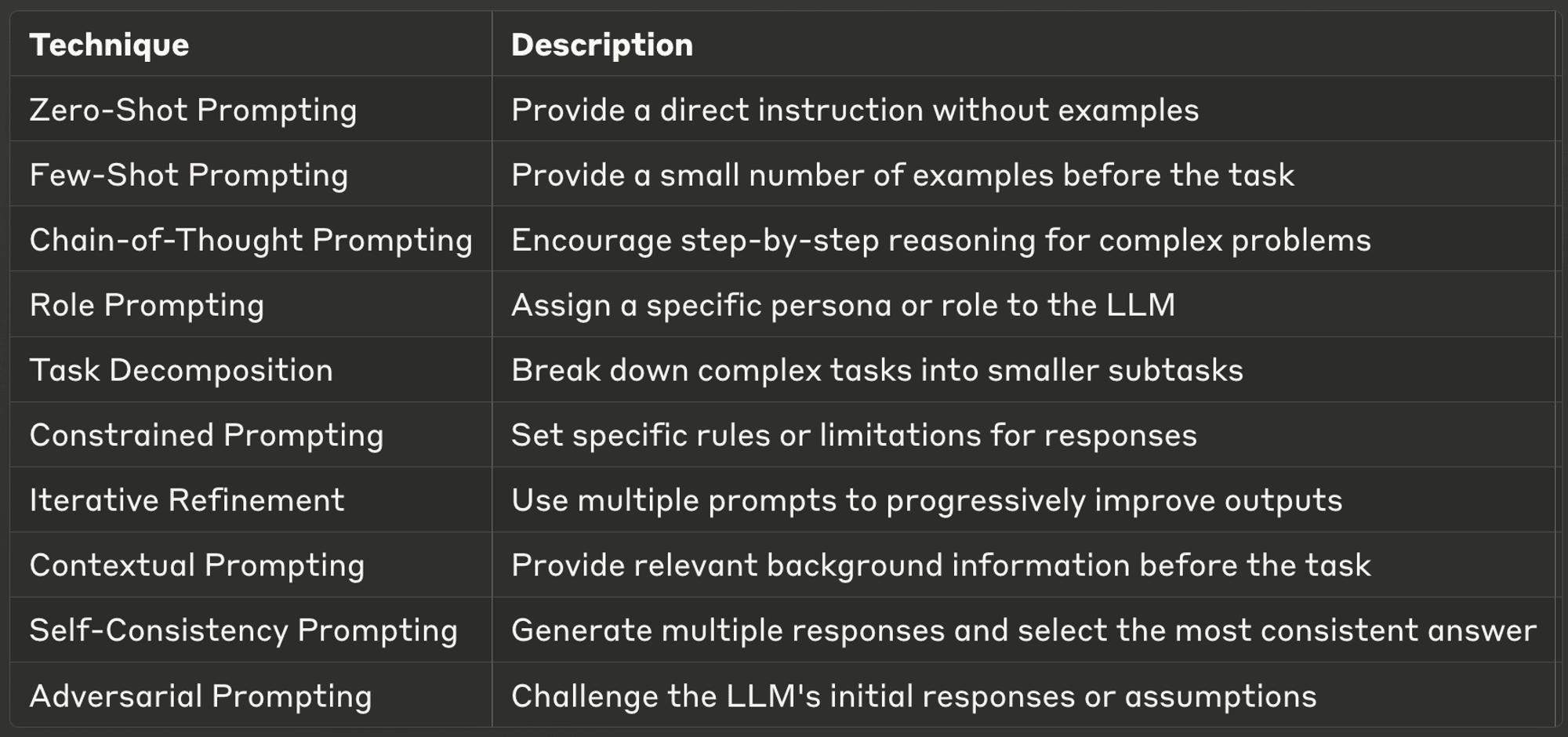

10 meilleures techniques d'incitation pour les étudiants en master de droit

Cette semaine, nous explorons également dix des techniques d'incitation les plus puissantes et les plus courantes, en donnant un aperçu de leurs applications et des meilleures pratiques.

Des messages-guides bien conçus peuvent améliorer considérablement les performances d'un LLM, en permettant d'obtenir des résultats plus précis, plus pertinents et plus créatifs. Que vous soyez un développeur d'IA chevronné ou que vous débutiez avec les LLM, ces techniques vous aideront à exploiter tout le potentiel des modèles d'IA.

Ne manquez pas de consulter l'intégralité du blog pour en savoir plus sur chacun d'entre eux.

Merci d'avoir pris le temps de lire AI & YOU !

Pour obtenir encore plus de contenu sur l'IA d'entreprise, y compris des infographies, des statistiques, des guides pratiques, des articles et des vidéos, suivez Skim AI sur LinkedIn

Vous êtes un fondateur, un PDG, un investisseur en capital-risque ou un investisseur à la recherche de services de conseil en IA, de développement d'IA fractionnée ou de due diligence ? Obtenez les conseils dont vous avez besoin pour prendre des décisions éclairées sur la stratégie des produits d'IA de votre entreprise et les opportunités d'investissement.

Nous construisons des solutions d'IA personnalisées pour les entreprises financées par le capital-risque et le capital-investissement dans les secteurs suivants : Technologie médicale, agrégation de nouvelles/contenu, production de films et de photos, technologie éducative, technologie juridique, Fintech & Cryptocurrency.