Les 10 meilleures techniques d'incitation du LLM pour maximiser les performances de l'IA

L'art d'élaborer des messages-guides efficaces pour les grands modèles de langage (LLM) est devenu une compétence cruciale pour les praticiens de l'IA. Des invites bien conçues peuvent améliorer de manière significative les performances d'un LLM, en permettant des résultats plus précis, plus pertinents et plus créatifs. Cet article de blog explore dix des techniques d'incitation les plus puissantes, offrant un aperçu de leurs applications et des meilleures pratiques. Que vous soyez un développeur d'IA chevronné ou que vous débutiez avec les LLM, ces techniques vous aideront à libérer tout le potentiel des modèles d'IA.

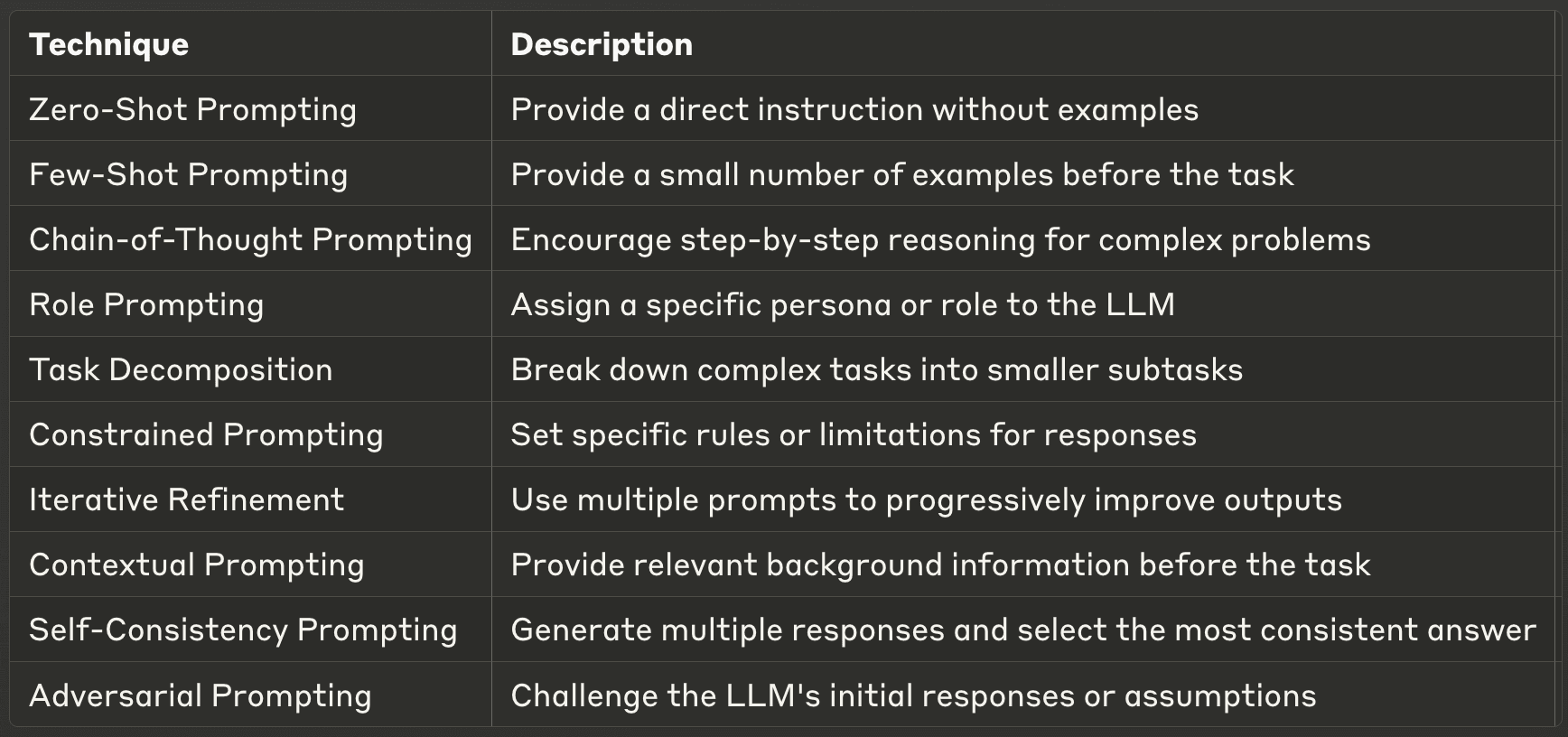

- 1. L'incitation à zéro

- 2. L'incitation à quelques coups de feu

- 3. Incitation à la chaîne de pensée (CoT)

- 4. Invitation à jouer un rôle

- 5. Décomposition des tâches

- 6. Invitation sous contrainte

- 7. Raffinement itératif

- 8. Invitation contextuelle

- 9. L'incitation à l'autoconsistance

- 10. L'incitation contradictoire

- Trouver les bonnes techniques d'ingénierie d'appel d'offres

1. L'incitation à zéro

L'invite zéro est la manière la plus directe d'interagir avec un LLM. Dans cette technique, vous fournissez une instruction ou une question directe sans aucun exemple, en vous appuyant sur les connaissances pré-entraînées du modèle pour générer une réponse. Cette méthode permet de tester la capacité du LLM à comprendre et à exécuter des tâches en se basant uniquement sur l'instruction donnée, sans contexte ni exemples supplémentaires.

L'interrogation à partir de zéro est particulièrement utile pour les tâches simples et directes ou les questions sur les connaissances générales. C'est un excellent moyen d'évaluer les capacités de base d'un LLM et il peut s'avérer étonnamment efficace pour un large éventail d'applications. Cependant, son efficacité peut varier en fonction de la complexité de la tâche et de son adéquation avec les données de formation du modèle. Lors de l'utilisation de l'invite zéro, il est essentiel d'être clair et précis dans vos instructions afin d'obtenir les meilleurs résultats.

Exemple : Lors de l'utilisation de l'incitation zéro, vous pouvez simplement demander au MLD : "Expliquez le concept de photosynthèse en termes simples". Le modèle génère alors une explication basée sur ses connaissances préexistantes, sans aucun contexte ou exemple supplémentaire.

2. L'incitation à quelques coups de feu

L'incitation à quelques coups de feu pousse l'interaction avec les MLD un peu plus loin en fournissant un petit nombre d'exemples avant de demander au modèle d'effectuer une tâche. Cette technique permet d'orienter le format et le style de sortie du modèle, en lui donnant essentiellement un modèle à suivre. En démontrant la relation entrée-sortie souhaitée, l'incitation par quelques exemples peut améliorer de manière significative les performances du modèle pour des tâches spécifiques.

Cette méthode est particulièrement efficace lorsque vous avez besoin de formats de sortie cohérents, lorsque vous traitez des tâches spécifiques à un domaine ou lorsque l'incitation à l'essai zéro produit des résultats incohérents. L'interrogation à quelques reprises vous permet d'affiner le comportement du modèle sans avoir besoin d'une formation ou d'une mise au point approfondie. C'est un moyen puissant d'adapter rapidement le LLM à votre cas d'utilisation spécifique. Cependant, il est important de choisir vos exemples avec soin, car ils influenceront fortement les résultats du modèle.

Exemple: Dans le cadre de l'incitation à la réflexion, vous pouvez fournir au MFR quelques exemples avant de poser votre question principale. Par exemple :

Q : Quelle est la capitale de la France ? R : La capitale de la France est Paris.

Q : Quelle est la capitale du Japon ? R : La capitale du Japon est Tokyo.

Q : Quelle est la capitale du Brésil ? A :

En fournissant ces exemples, vous aidez le LLM à comprendre le format et le type de réponse que vous attendez, ce qui augmente la probabilité de recevoir une réponse cohérente et précise.

3. Incitation à la chaîne de pensée (CoT)

L'incitation à la chaîne de pensée est une technique plus avancée qui encourage les MFR à décomposer les problèmes complexes en processus de raisonnement étape par étape. Cette méthode imite les approches humaines de résolution de problèmes, ce qui permet au modèle de s'attaquer à des tâches plus complexes nécessitant un raisonnement ou des calculs en plusieurs étapes. En incitant le LLM à montrer son travail, le CoT peut améliorer de manière significative les performances sur des tâches complexes et fournir une transparence sur le processus de prise de décision du modèle.

Les avantages de l'incitation CoT vont au-delà de l'amélioration de la précision. Ils améliorent également l'interprétabilité des résultats du modèle, ce qui permet aux humains de comprendre et de vérifier plus facilement le raisonnement qui sous-tend les réponses. Cela est particulièrement utile dans des domaines tels que l'éducation, où la compréhension du processus de résolution des problèmes est aussi importante que la réponse finale. Toutefois, il convient de noter que les messages-guides du CoT peuvent être plus gourmands en ressources informatiques et ne sont pas toujours nécessaires pour des tâches plus simples. Il est également important de noter que les messages-guides de CoT se sont avérés plus efficaces lorsqu'ils fournissent des exemples très pertinents et spécifiques.

Exemple : Lorsque vous utilisez la chaîne de pensée, vous pouvez poser une question comme celle-ci : "Si une chemise coûte $25 et qu'elle est en promotion à 20%, quel est le prix final ? Veuillez montrer votre raisonnement étape par étape." Le LLM peut alors répondre par un raisonnement détaillé :

"Abordons la question étape par étape :

Le prix original est $25.

Une remise de 20% signifie que nous devons calculer 20% de $25.

20% de $25 est $25 × 0,20 = $5.

Le montant de la remise est de $5.

Pour obtenir le prix final, nous soustrayons la remise du prix initial.

$25 - $5 = $20. Par conséquent, le prix final de la chemise est de $20".

Cette réponse ne fournit pas seulement la bonne réponse, mais démontre également le processus de raisonnement, ce qui facilite la vérification et la compréhension de la solution.

4. Invitation à jouer un rôle

L'incitation par le rôle est une technique créative et puissante qui consiste à attribuer un personnage ou un rôle spécifique au MLD. Cette méthode peut modifier considérablement le ton, le style et le contenu des réponses du modèle, ce qui vous permet d'adapter ses résultats à des besoins ou scénarios spécifiques. En demandant au LLM d'adopter un rôle particulier, vous pouvez accéder à différentes "personnalités" ou expertises dans la base de connaissances du modèle.

Cette technique est particulièrement utile lorsqu'il s'agit de générer du contenu dans une voix ou un style spécifique, de simuler les connaissances d'un expert dans un domaine ou de créer diverses perspectives sur un sujet. L'incitation par le rôle peut conduire à des réponses plus engageantes et adaptées au contexte, ce qui la rend précieuse pour l'écriture créative, la planification de scénarios ou les simulations éducatives. Cependant, il est important de se rappeler que même si le LLM peut simuler différents rôles de manière convaincante, ses réponses sont toujours basées sur ses données d'entraînement et ne doivent pas être considérées comme de véritables conseils d'experts sans vérification.

Exemple : En ce qui concerne l'incitation au rôle, vous pourriez donner les instructions suivantes au MFR : "En tant que climatologue expérimenté, expliquez les effets potentiels à long terme de l'élévation du niveau de la mer sur les villes côtières." Cette incitation encourage le MLD à adopter le personnage d'un climatologue, ce qui peut conduire à une réponse plus technique et plus autorisée sur le sujet.

5. Décomposition des tâches

La décomposition des tâches est une approche stratégique de l'incitation qui consiste à décomposer les tâches complexes en sous-tâches plus petites et plus faciles à gérer. Cette technique tire parti de la capacité du LLM à traiter des éléments d'information discrets et à les combiner en un tout cohérent. En décomposant une tâche importante, vous pouvez guider le modèle à travers une série d'étapes, en veillant à ce que chaque élément soit traité de manière complète et précise.

Cette méthode est particulièrement efficace pour aborder des problèmes complexes qui pourraient submerger le modèle s'ils étaient présentés en une seule fois. Elle réduit la charge cognitive du LLM, ce qui permet des réponses plus ciblées et plus précises à chaque sous-tâche. La décomposition des tâches permet également de mieux gérer les problèmes à plusieurs étapes et peut améliorer la qualité globale et l'exhaustivité du résultat final. En outre, cette approche peut faciliter l'identification et la correction des erreurs, étant donné que vous pouvez examiner chaque étape individuellement. Lors de la mise en œuvre de la décomposition des tâches, il est essentiel de maintenir un flux logique clair entre les sous-tâches afin de garantir un résultat final cohérent.

Exemple : Lorsque vous utilisez la décomposition des tâches pour une tâche complexe, vous pouvez demander au MLD de procéder comme suit : "Pour rédiger un document de recherche complet sur les énergies renouvelables, décomposons-le en plusieurs étapes. Veuillez énumérer les principales étapes à suivre, de la définition du champ d'application à la finalisation du document."

Le LLM pourrait alors répondre par une ventilation comme celle-ci :

"1) Définir le champ d'application du document (types d'énergie renouvelable à couvrir). 2. Décrivez les principales sections (introduction, état actuel, défis, perspectives d'avenir, conclusion). 3. Pour chaque section, dressez la liste des points clés à aborder. 4. Effectuer des recherches et rassembler des données pour chaque point. 5. Rédiger une introduction qui définit le contexte et énonce les objectifs du document. 6. Développer chaque section en incorporant les données et les analyses pertinentes. 7. Résumer les principaux résultats et les implications futures dans la conclusion. 8. Revoir et affiner l'ensemble du document pour en assurer la cohérence et la fluidité. 9. Créer une bibliographie des sources utilisées.

Commençons par l'étape 1..."

Cette répartition vous permet de vous attaquer à la tâche complexe de la rédaction d'un document de recherche en plusieurs parties gérables, ce qui améliore la qualité globale et l'exhaustivité du résultat final.

Certainement ! Poursuivons avec les sections restantes de l'article de blog "10 Best Prompting Techniques for LLMs". Voici les sections 7 à 10, suivies d'une conclusion et de conseils pratiques :

6. Invitation sous contrainte

L'incitation contrainte consiste à définir des règles ou des limites spécifiques que le LLM doit suivre dans ses réponses. Cette technique est particulièrement utile lorsque vous devez contrôler le format de sortie, la longueur ou le contenu des réponses du modèle. En énonçant explicitement les contraintes, vous pouvez guider le LLM pour qu'il génère des résultats plus ciblés et plus pertinents.

Les contraintes peuvent aller d'instructions simples, comme la limitation du nombre de mots, à des exigences plus complexes, comme le respect de styles d'écriture spécifiques ou l'évitement de certains sujets. Cette technique est particulièrement utile dans les milieux professionnels où la cohérence et le respect des directives sont cruciaux. Toutefois, il est important d'équilibrer les contraintes avec la flexibilité pour permettre au LLM d'exploiter toutes ses capacités.

Exemple : "Fournissez un résumé des derniers développements en matière d'énergie renouvelable en 100 mots exactement. Concentrez-vous uniquement sur l'énergie solaire et l'énergie éolienne et ne mentionnez pas de sociétés ou de marques spécifiques.

7. Raffinement itératif

L'affinage itératif est une technique qui implique l'utilisation de plusieurs invites afin d'améliorer et d'affiner progressivement les résultats du MFT. Cette approche reconnaît que les tâches complexes nécessitent souvent plusieurs séries de révisions et d'améliorations. En décomposant la tâche en plusieurs étapes et en fournissant un retour d'information à chaque étape, vous pouvez guider le MLD vers des résultats finaux plus précis et plus soignés.

Cette méthode est particulièrement efficace pour des tâches telles que l'écriture, la résolution de problèmes ou le travail créatif, où le premier jet est rarement parfait. L'amélioration itérative vous permet d'exploiter les points forts du LLM tout en gardant le contrôle de l'orientation et de la qualité du résultat. Il est important d'être clair et précis dans vos commentaires à chaque itération afin d'assurer une amélioration continue.

Exemple: Étape 1 : "Rédigez le plan d'un article sur l'impact de l'intelligence artificielle sur les soins de santé". Étape 2 : "Sur la base de ce plan, développez la section consacrée à l'intelligence artificielle dans le diagnostic médical." Étape 3 : "Maintenant, ajoutez à cette section des exemples spécifiques d'applications de l'IA en radiologie."

8. Invitation contextuelle

L'incitation contextuelle consiste à fournir des informations contextuelles pertinentes au LLM avant de lui demander d'effectuer une tâche. Cette technique aide le modèle à comprendre la situation dans son ensemble et à générer des réponses plus précises et plus pertinentes. En préparant le terrain avec un contexte approprié, vous pouvez améliorer de manière significative la qualité et la spécificité des résultats du LLM.

Cette méthode est particulièrement utile lorsqu'il s'agit de sujets spécialisés, de scénarios uniques ou lorsque vous avez besoin que le LLM prenne en compte des informations spécifiques qui ne font pas partie de ses connaissances générales. L'incitation contextuelle peut aider à combler le fossé entre les connaissances générales du LLM et les exigences spécifiques de votre tâche.

Exemple: "Contexte : La ville d'Amsterdam a mis en œuvre diverses initiatives écologiques pour devenir plus durable. Sur la base de ces informations, proposez trois idées innovantes en matière d'urbanisme qui pourraient renforcer les efforts d'Amsterdam en matière de développement durable."

9. L'incitation à l'autoconsistance

L'incitation à l'autoconsistance est une technique avancée qui consiste à générer plusieurs réponses à la même incitation, puis à sélectionner la réponse la plus cohérente ou la plus fiable. Cette méthode tire parti de la nature probabiliste des LLM pour améliorer la précision, en particulier pour les tâches qui nécessitent un raisonnement ou une résolution de problème.

En comparant plusieurs résultats, l'incitation à l'autoconsistance permet d'identifier et de filtrer les incohérences ou les erreurs susceptibles de se produire dans les réponses individuelles. Cette technique est particulièrement précieuse pour les applications critiques où la précision est primordiale. Toutefois, elle nécessite davantage de ressources informatiques et de temps que les méthodes à réponse unique.

Exemple: "Résolvez le problème mathématique suivant : si un train roule à 100 km/h pendant 2,5 heures, quelle distance parcourt-il ? Produisez cinq solutions indépendantes, puis choisissez la réponse la plus cohérente."

10. L'incitation contradictoire

L'incitation contradictoire est une technique qui consiste à remettre en question les réponses ou les hypothèses initiales du LLM afin d'améliorer la qualité, la précision et la robustesse de ses résultats. Cette méthode simule un débat ou un processus de réflexion critique, poussant le modèle à prendre en compte d'autres points de vue, des failles potentielles dans son raisonnement ou des facteurs négligés.

L'approche contradictoire consiste à demander au LLM de fournir une première réponse ou solution, puis à l'inciter à critiquer ou à remettre en question sa propre réponse. Ce processus peut être répété plusieurs fois, chaque itération affinant et renforçant le résultat final. L'incitation contradictoire est particulièrement utile pour la résolution de problèmes complexes, les scénarios de prise de décision ou le traitement de sujets controversés ou à multiples facettes.

Cette technique permet d'atténuer les biais potentiels dans les réponses du modèle et encourage des résultats plus complets et plus équilibrés. Toutefois, elle nécessite une formulation minutieuse des questions contradictoires afin de garantir une critique productive plutôt qu'une simple contradiction.

Exemple: Étape 1 : "Proposez une solution pour réduire la congestion du trafic urbain." Étape 2 : "Maintenant, identifiez trois inconvénients ou défis potentiels à la solution que vous venez de proposer." Étape 3 : "En tenant compte de ces difficultés, affinez votre solution initiale ou proposez une autre approche." Étape 4 : "Enfin, comparez les forces et les faiblesses de votre solution initiale et de votre solution affinée, et recommandez le meilleur plan d'action."

Trouver les bonnes techniques d'ingénierie d'appel d'offres

La maîtrise de ces techniques d'incitation peut considérablement améliorer votre capacité à travailler efficacement avec les MFR. Chaque méthode offre des avantages uniques et est adaptée à différents types de tâches et de scénarios. En comprenant et en appliquant ces techniques, les praticiens de l'IA peuvent libérer tout le potentiel des LLM, ce qui permet d'obtenir des résultats plus précis, plus créatifs et plus utiles.

Le domaine de l'IA continue d'évoluer, tout comme les stratégies d'incitation. Rester informé des nouveaux développements et expérimenter en permanence différentes techniques sera crucial pour toute personne travaillant avec des MLD. N'oubliez pas que l'art de l'incitation consiste autant à comprendre les capacités et les limites du modèle qu'à concevoir l'entrée parfaite.