Les 10 meilleurs moyens d'éliminer les hallucinations du LLM

Alors que les grands modèles de langage (LLM) continuent de perturber presque tous les domaines et toutes les industries, ils apportent avec eux un défi unique : les hallucinations. Ces inexactitudes générées par l'IA représentent un risque important pour la fiabilité et la confiance dans les résultats des LLM.

Qu'est-ce que les hallucinations LLM ?

Les hallucinations du LLM se produisent lorsque ces puissants modèles de langage génèrent un texte factuellement incorrect, absurde ou sans rapport avec les données d'entrée. Même s'il semble cohérent et sûr de lui, le contenu halluciné peut conduire à des informations erronées, à des prises de décision erronées et à une perte de confiance dans les applications alimentées par l'IA.

Les systèmes d'IA étant de plus en plus intégrer dans divers aspects de notre vie, des chatbots du service client aux chatbots de la société civile. outils de création de contenuLa nécessité d'atténuer les hallucinations devient donc primordiale. Des hallucinations non contrôlées peuvent entraîner des atteintes à la réputation, des problèmes juridiques et un préjudice potentiel pour les utilisateurs qui se fient aux informations générées par l'IA.

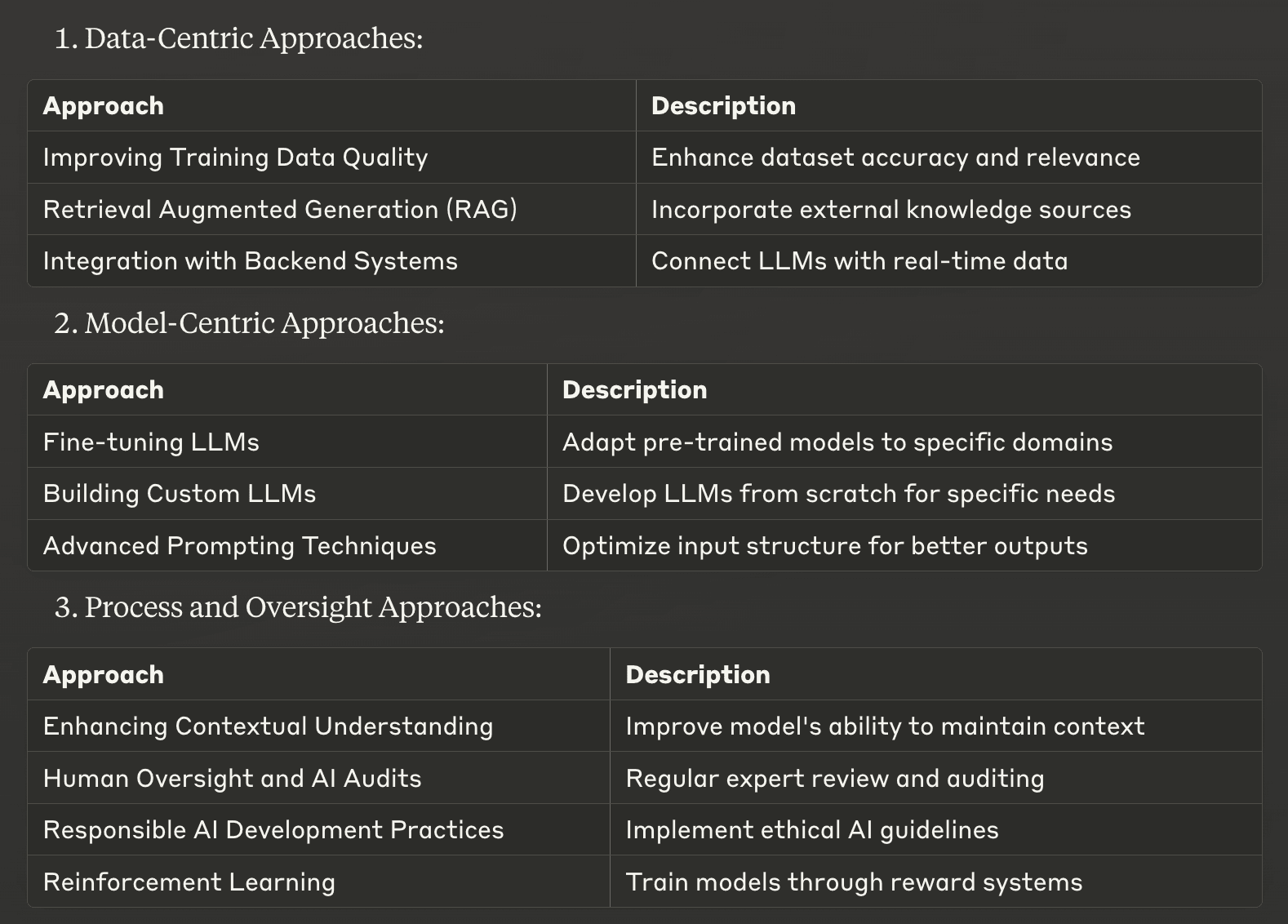

Nous avons compilé une liste des 10 meilleures stratégies pour atténuer les hallucinations LLM, allant des approches centrées sur les données aux techniques centrées sur les modèles, en passant par les méthodes orientées vers les processus. Ces stratégies sont conçues pour aider les entreprises et les développeurs à améliorer la précision factuelle et la fiabilité de leurs systèmes d'IA.

Approches centrées sur les données

1. Améliorer la qualité des données de formation

L'un des moyens les plus fondamentaux d'atténuer les hallucinations consiste à améliorer la qualité des données d'entraînement utilisées pour développer de grands modèles de langage. Des ensembles de données de haute qualité, diversifiés et bien classés peuvent réduire de manière significative la probabilité que les MLA apprennent et reproduisent des informations inexactes.

Pour mettre en œuvre cette stratégie, il convient de se concentrer sur les points suivants

Contrôle minutieux de l'exactitude et de la pertinence des sources de données

Assurer une représentation équilibrée des sujets et des perspectives

Mise à jour régulière des ensembles de données afin d'y inclure les informations les plus récentes

Suppression des points de données en double ou contradictoires

En investissant dans des données de formation de qualité supérieure, vous posez des bases solides pour des résultats LLM plus fiables et plus précis.

2. Génération augmentée par récupération (RAG)

Génération Augmentée de Récupération (RAG) est une technique puissante qui combine les forces des approches basées sur la recherche et sur la génération. Cette méthode permet aux LLM d'accéder à des informations pertinentes provenant de sources de connaissances externes et de les intégrer au cours du processus de génération de texte.

RAG travaille par :

Extraction d'informations pertinentes à partir d'une base de connaissances curatée

Incorporer ces informations dans le contexte fourni au mécanisme d'apprentissage tout au long de la vie

Générer des réponses fondées sur des informations factuelles et actualisées

En mettant en œuvre RAG, les entreprises peuvent réduire considérablement les hallucinations en ancrant les réponses LLM à des sources d'information fiables et externes. Cette approche est particulièrement efficace pour les applications spécifiques à un domaine où la précision est cruciale, comme dans les systèmes d'IA juridiques ou médicaux.

3. Intégration avec les systèmes dorsaux

L'intégration des LLM aux systèmes dorsaux existants d'une entreprise peut améliorer considérablement la précision et la pertinence du contenu généré par l'IA. Cette approche permet au LLM d'accéder en temps réel à des données contextuelles spécifiques directement à partir des bases de données ou des API de l'entreprise.

Les principaux avantages de l'intégration du backend sont les suivants

Veiller à ce que les réponses soient fondées sur les informations les plus récentes

Fournir des résultats personnalisés et adaptés au contexte

Réduire la dépendance à l'égard de données de formation potentiellement obsolètes

Par exemple, un chatbot de commerce électronique intégré au système d'inventaire de l'entreprise peut fournir des informations précises et en temps réel sur la disponibilité des produits, réduisant ainsi le risque de réponses hallucinées sur les niveaux de stock ou les prix.

En mettant en œuvre ces approches centrées sur les données, les entreprises peuvent améliorer de manière significative la fiabilité de leurs résultats LLM, en réduisant le risque d'hallucinations et en améliorant les performances globales du système d'IA.

Approches centrées sur le modèle

4. Réglage fin des LLM

Le réglage fin est une technique puissante qui permet d'adapter les grands modèles de langage pré-entraînés à des domaines ou des tâches spécifiques. Ce processus implique un entraînement supplémentaire du LLM sur un ensemble de données plus petit, soigneusement sélectionné et pertinent pour l'application cible. Le réglage fin peut réduire considérablement les hallucinations en alignant les résultats du modèle sur les connaissances et la terminologie spécifiques au domaine.

Les principaux avantages de la mise au point sont les suivants

Amélioration de la précision dans les domaines spécialisés

Meilleure compréhension du jargon propre à l'industrie

Réduction de la probabilité de générer des informations non pertinentes ou incorrectes

Par exemple, un assistant d'IA juridique affiné sur un corpus de documents juridiques et de jurisprudence sera moins susceptible d'avoir des hallucinations lorsqu'il répondra à des questions juridiques, ce qui améliorera sa fiabilité et son utilité dans le domaine juridique.

5. Construction de LLM personnalisés

Pour les organisations disposant de ressources importantes et de besoins spécifiques, la création de modèles linguistiques personnalisés à partir de zéro peut être un moyen efficace d'atténuer les hallucinations. Cette approche permet de contrôler entièrement les données d'entraînement, l'architecture du modèle et le processus d'apprentissage.

Avantages de la LLM sur mesure inclure :

Base de connaissances sur mesure alignée sur les besoins de l'entreprise

Réduction du risque d'intégrer des informations non pertinentes ou inexactes

Un meilleur contrôle sur le comportement et les résultats du modèle

Bien que cette approche nécessite des ressources informatiques et une expertise considérables, elle peut aboutir à des systèmes d'IA très précis et fiables dans leur domaine d'activité prévu.

6. Techniques avancées d'incitation

Des techniques sophistiquées d'incitation peuvent guider les modèles de langage pour générer des textes plus précis et plus cohérents, réduisant ainsi les hallucinations. Ces méthodes permettent de structurer les données d'entrée de manière à obtenir des résultats plus fiables de la part du système d'IA.

Voici quelques techniques d'incitation efficaces :

Incitation à la réflexion en chaîne : Encourage le raisonnement étape par étape

Apprentissage à quelques coups : Fournit des exemples pour guider les réponses du modèle

En élaborant soigneusement les messages-guides, les développeurs peuvent améliorer de manière significative l'exactitude factuelle et la pertinence du contenu généré par le LLM, en minimisant l'apparition d'hallucinations.

Approches en matière de processus et de surveillance

7. Améliorer la compréhension du contexte

L'amélioration de la capacité d'un LLM à maintenir le contexte tout au long d'une interaction peut réduire considérablement les hallucinations. Il s'agit de mettre en œuvre des techniques qui aident le modèle à suivre et à utiliser les informations pertinentes au cours de conversations prolongées ou de tâches complexes.

Les stratégies clés sont les suivantes :

Résolution de la coréférence : Aider le modèle à identifier et à relier les entités apparentées

Suivi de l'historique des conversations : Assurer la prise en compte des échanges antérieurs

Modélisation contextuelle avancée : Permettre au modèle de se concentrer sur les informations pertinentes

Ces techniques aident les LLM à maintenir la cohérence et l'homogénéité, réduisant ainsi la probabilité de générer des informations contradictoires ou non pertinentes.

8. Supervision humaine et audits de l'IA

La mise en œuvre d'une supervision humaine et la réalisation d'audits réguliers de l'IA sont essentielles pour identifier et traiter les hallucinations dans les résultats du programme d'éducation et de formation tout au long de la vie. Cette approche combine l'expertise humaine et les capacités de l'IA afin de garantir le plus haut niveau de précision et de fiabilité.

Les pratiques de contrôle efficaces sont notamment les suivantes

Révision régulière du contenu généré par l'IA par des experts du domaine

Mise en œuvre de boucles de rétroaction pour améliorer la performance des modèles

Réalisation d'audits approfondis afin d'identifier les schémas d'hallucination

En maintenant l'implication humaine dans le processus d'IA, les organisations peuvent détecter et corriger les hallucinations qui pourraient autrement passer inaperçues, améliorant ainsi la fiabilité globale de leurs systèmes d'IA.

9. Pratiques responsables de développement de l'IA

L'adoption de pratiques responsables en matière de développement de l'IA est essentielle pour créer des LLM moins sujets aux hallucinations. Cette approche met l'accent sur les considérations éthiques, la transparence et la responsabilité tout au long du cycle de développement de l'IA.

Les principaux aspects d'un développement responsable de l'IA sont les suivants

Priorité à l'équité et à l'impartialité des données de formation

Mise en œuvre de processus d'essai et de validation robustes

Garantir la transparence des processus décisionnels en matière d'IA

En adhérant à ces principes, les organisations peuvent développer des systèmes d'IA plus fiables, plus dignes de confiance et moins susceptibles de produire des résultats nuisibles ou trompeurs.

10. Apprentissage par renforcement

L'apprentissage par renforcement offre une approche prometteuse pour atténuer les hallucinations dans les MFR. Cette technique consiste à former des modèles par le biais d'un système de récompenses et de pénalités, en encourageant les comportements souhaités et en décourageant les comportements indésirables.

Avantages de l'apprentissage par renforcement dans l'atténuation des hallucinations :

Alignement des résultats du modèle sur des objectifs de précision spécifiques

Améliorer la capacité d'autocorrection du modèle

Améliorer la qualité et la fiabilité globales du texte généré

En mettant en œuvre des techniques d'apprentissage par renforcement, les développeurs peuvent créer des LLM plus aptes à éviter les hallucinations et à produire un contenu factuellement exact.

Ces approches centrées sur le modèle et orientées vers le processus fournissent des outils puissants pour atténuer les hallucinations dans les grands modèles de langage. En combinant ces stratégies avec les approches centrées sur les données évoquées précédemment, les organisations peuvent améliorer de manière significative la fiabilité et la précision de leurs systèmes d'IA, ouvrant ainsi la voie à des applications d'IA plus fiables et plus efficaces.

Mise en œuvre de stratégies efficaces d'atténuation des hallucinations

Après avoir exploré les 10 meilleures façons d'atténuer les hallucinations dans les grands modèles de langage, il est clair qu'il est essentiel de relever ce défi pour développer des systèmes d'IA fiables. La clé du succès réside dans la mise en œuvre réfléchie de ces stratégies, adaptées à vos besoins et ressources spécifiques. Lorsque vous choisissez la bonne approche, tenez compte de vos exigences particulières et des types d'hallucinations que vous rencontrez. Certaines stratégies, comme l'amélioration de la qualité des données d'entraînement, peuvent être simples à adopter, tandis que d'autres, comme la création de LLM personnalisés, peuvent nécessiter des investissements importants.

Il est essentiel de trouver un équilibre entre l'efficacité et les besoins en ressources. Souvent, une combinaison de stratégies fournit la solution optimale, vous permettant de tirer parti de plusieurs approches tout en gérant les contraintes. Par exemple, la combinaison de RAG et de techniques d'incitation avancées peut apporter des améliorations significatives sans qu'il soit nécessaire de procéder à un réapprentissage approfondi du modèle.

L'intelligence artificielle continue d'évoluer, tout comme les méthodes d'atténuation des hallucinations. En restant informé des derniers développements et en affinant continuellement votre approche, vous pouvez vous assurer que vos systèmes d'IA restent à la pointe de la précision et de la fiabilité. N'oubliez pas que l'objectif n'est pas seulement de générer du texte, mais de créer des résultats LLM auxquels les utilisateurs peuvent se fier, ouvrant ainsi la voie à des applications d'IA plus efficaces et plus responsables dans divers secteurs d'activité.

Si vous avez besoin d'aide pour atténuer les hallucinations du LLM, n'hésitez pas à nous contacter à Skim AI.