Quelques encouragements, apprentissage et mise au point pour les LLM - AI&YOU #67 Quelques encouragements, apprentissage et mise au point pour les LLM - AI&YOU #67

- Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

- Le défi de la rareté des données dans l'IA

- Apprentissage par petites touches vs. apprentissage supervisé traditionnel

- Le spectre de l'apprentissage par échantillonnage

- Few Shot Prompting vs Fine Tuning LLM

- Promesse de quelques coups de feu : Libérer le potentiel du LLM

- Ajustement fin des LLM : Adapter les modèles avec des données limitées

- L'incitation à quelques coups de feu ou la mise au point : Choisir la bonne approche

- Top 5 Research Papers for Few-Shot Learning

- Le bilan

- Merci d'avoir pris le temps de lire AI & YOU !

Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67 Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

La statistique de la semaine : Research by MobiDev on few-shot learning for coin image classification found that using just 4 image examples per coin denomination, they could achieve ~70% accuracy.

In AI, the ability to learn efficiently from limited data has become crucial. That’s why it’s important for enterprises to understand few-shot learning, few-shot prompting, and fine-tuning LLMs.

Dans l'édition de cette semaine d'AI&YOU, nous explorons les perspectives de trois blogs que nous avons publiés sur ces sujets :

Few-Shot Prompting, Learning, and Fine-Tuning for LLMs – AI&YOU #67

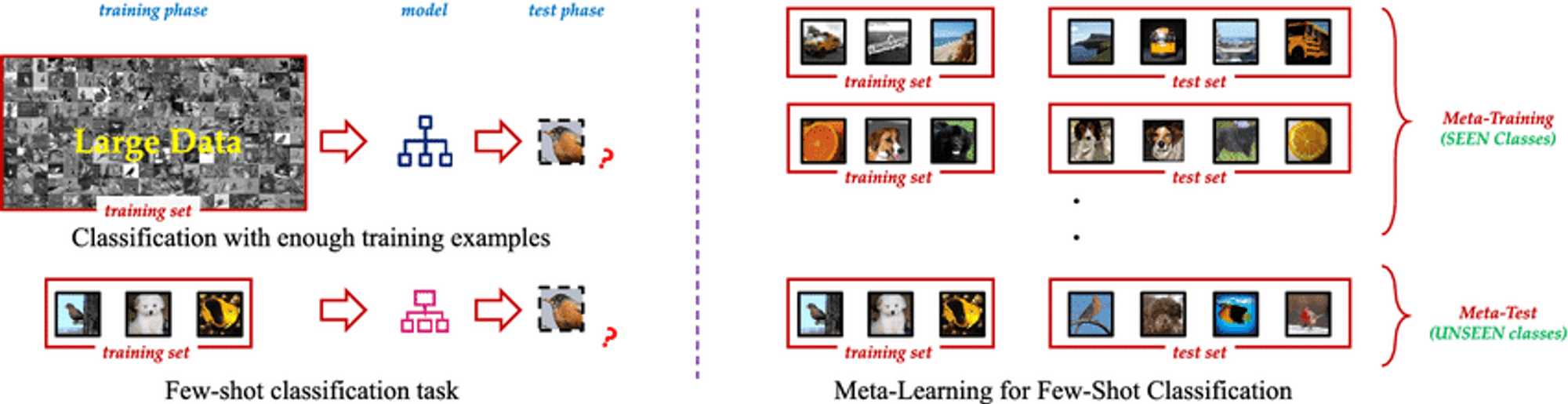

Few Shot Learning is an innovative machine learning paradigm that enables AI models to learn new concepts or tasks from only a few examples. Unlike traditional supervised learning methods that require vast amounts of labeled training data, Few Shot Learning techniques allow models to generalize effectively using just a small number of samples. This approach mimics the human ability to quickly grasp new ideas without the need for extensive repetition.

L'essence même de l'apprentissage à petite échelle réside dans sa capacité à exploiter les connaissances antérieures et à s'adapter rapidement à de nouveaux scénarios. En utilisant des techniques telles que le méta-apprentissage, où le modèle "apprend à apprendre", les algorithmes de Few Shot Learning peuvent s'attaquer à un large éventail de tâches avec un minimum de formation supplémentaire. Cette flexibilité en fait un outil inestimable dans les scénarios où les données sont rares, coûteuses à obtenir ou en constante évolution.

Le défi de la rareté des données dans l'IA

Toutes les données ne sont pas égales et les données étiquetées de haute qualité peuvent être une denrée rare et précieuse. Cette rareté constitue un défi de taille pour les approches traditionnelles d'apprentissage supervisé, qui nécessitent généralement des milliers, voire des millions d'exemples étiquetés pour obtenir des performances satisfaisantes.

Le problème de la rareté des données est particulièrement aigu dans les domaines spécialisés tels que les soins de santé, où les maladies rares peuvent avoir un nombre limité de cas documentés, ou dans les environnements en évolution rapide où de nouvelles catégories de données apparaissent fréquemment. Dans ces scénarios, le temps et les ressources nécessaires à la collecte et à l'étiquetage de grands ensembles de données peuvent être prohibitifs, ce qui crée un goulet d'étranglement dans le développement et le déploiement de l'IA.

Apprentissage par petites touches vs. apprentissage supervisé traditionnel

Understanding the distinction between Few Shot Learning and traditional supervised learning is crucial to grasp its real-world impact.

Traditionnel apprentissage supervisé, while powerful, has drawbacks:

Dépendance des données : Struggles with limited training data.

L'inflexibilité : Performs well only on specific trained tasks.

Intensité des ressources : Requires large, expensive datasets.

Mise à jour continue : Needs frequent retraining in dynamic environments.

Few Shot Learning offers a paradigm shift:

Efficacité de l'échantillon : Generalizes from few examples using meta-learning.

Adaptation rapide : Quickly adapts to new tasks with minimal examples.

Optimisation des ressources : Reduces data collection and labeling needs.

Apprentissage continu : Suitable for incorporating new knowledge without forgetting.

Polyvalence : Applicable across various domains, from computer vision to NLP.

By tackling these challenges, Few Shot Learning enables more adaptable and efficient AI models, opening new possibilities in AI development.

Le spectre de l'apprentissage par échantillonnage

A fascinating spectrum of approaches aims to minimize required training data, including Zero Shot, One Shot, and Few Shot Learning.

Apprentissage à partir de zéro : Apprentissage sans exemples

Recognizes unseen classes using auxiliary information like textual descriptions

Valuable when labeled examples for all classes are impractical or impossible

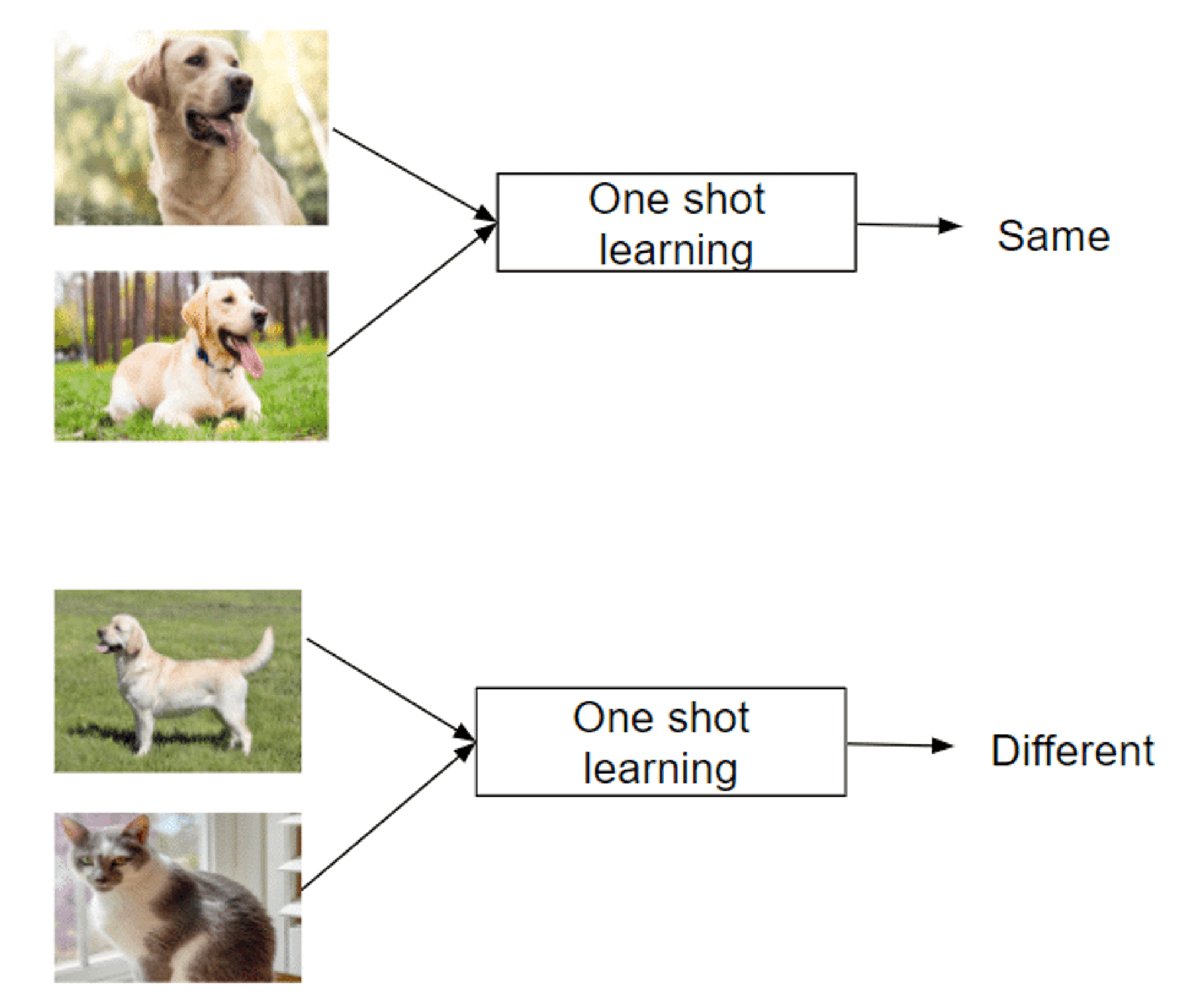

Apprentissage à partir d'une seule instance : Apprentissage à partir d'une seule instance

Recognizes new classes from just one example

Mimics human ability to grasp concepts quickly

Successful in areas like facial recognition

Apprentissage en quelques coups : Maîtriser des tâches avec un minimum de données

Uses 2-5 labeled examples per new class

Balances extreme data efficiency and traditional methods

Enables rapid adaptation to new tasks or classes

Leverages meta-learning strategies to learn how to learn

This spectrum of approaches offers unique capabilities in tackling the challenge of learning from limited examples, making them invaluable in data-scarce domains.

Few Shot Prompting vs Fine Tuning LLM

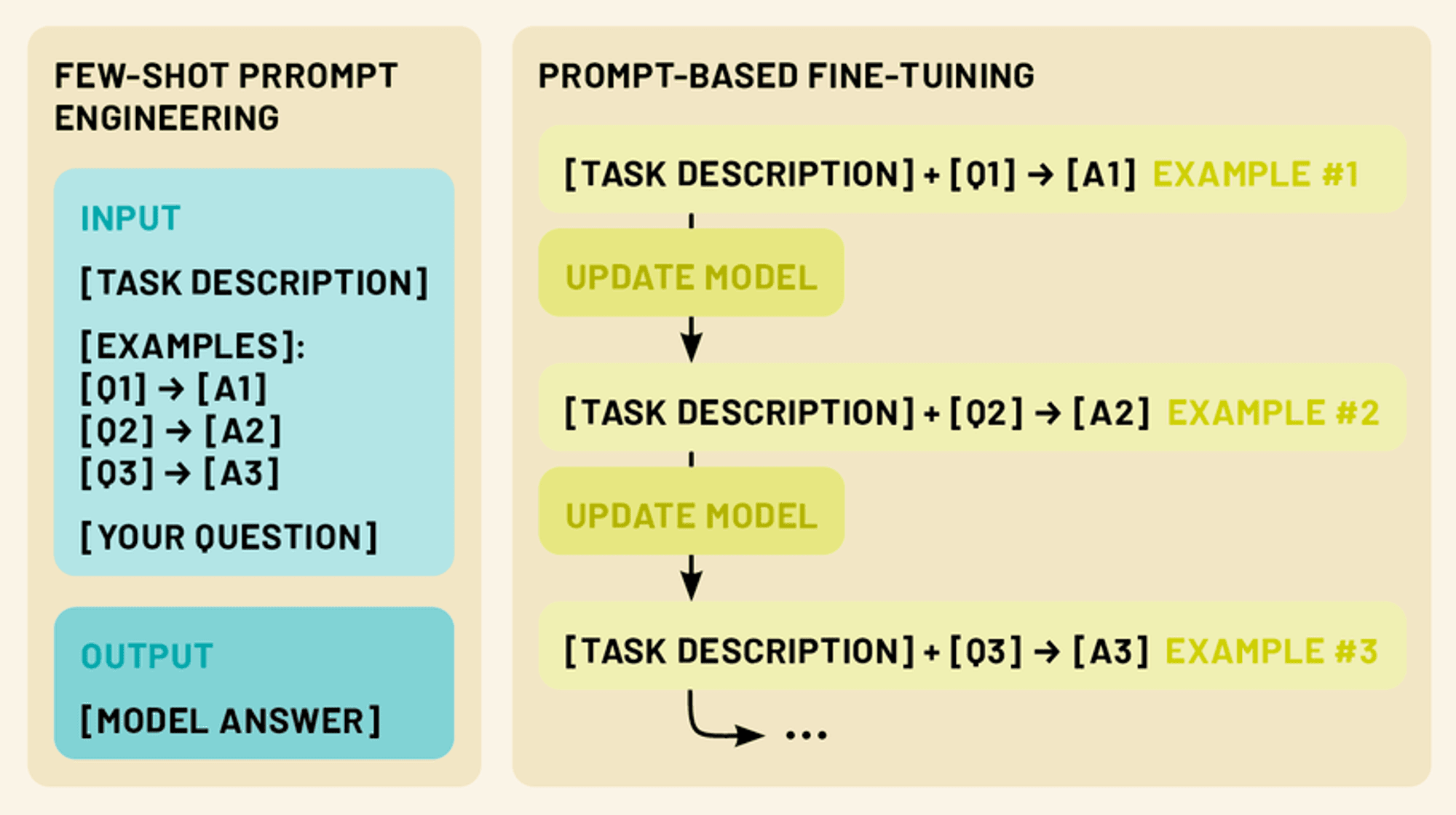

Two more powerful techniques exist in this realm: few-shot prompting and fine-tuning. Few-shot prompting involves crafting clever input prompts that include a small number of examples, guiding the model to perform a specific task without any additional training. Fine-tuning, on the other hand, involves updating the model’s parameters using a limited amount of task-specific data, allowing it to adapt its vast knowledge to a particular domain or application.

Both approaches fall under the umbrella of few-shot learning. By leveraging these techniques, we can dramatically enhance the performance and versatility of LLMs, making them more practical and effective tools for a wide range of applications in natural language processing and beyond.

Promesse de quelques coups de feu : Libérer le potentiel du LLM

Few-shot prompting capitalizes on the model’s ability to understand instructions, effectively “programming” the LLM through crafted prompts.

Few-shot prompting provides 1-5 examples demonstrating the desired task, leveraging the model’s pattern recognition and adaptability. This enables performance of tasks not explicitly trained for, tapping into the LLM’s capacity for in-context learning.

By presenting clear input-output patterns, few-shot prompting guides the LLM to apply similar reasoning to new inputs, allowing quick adaptation to new tasks without parameter updates.

Types de messages-guides à court terme (zéro, un, quelques)

Few-shot prompting encompasses a spectrum of approaches, each defined by the number of examples provided. (Just like few-shot learning):

Invitation sans coup férir : Dans ce scénario, aucun exemple n'est fourni. Au lieu de cela, le modèle reçoit une instruction ou une description claire de la tâche. Par exemple, "Traduisez le texte anglais suivant en français : [texte d'entrée]".

Incitation en une seule fois : Ici, un seul exemple est fourni avant l'entrée réelle. Cela donne au modèle un exemple concret de la relation entrée-sortie attendue. Voici un exemple : "Classer le sentiment de l'avis suivant comme positif ou négatif. Exemple : "Ce film était fantastique" - Entrée positive : "Je n'ai pas supporté l'intrigue". - [le modèle génère la réponse]".

Incitation à quelques coups de feu : Cette approche fournit plusieurs exemples (généralement 2 à 5) avant l'entrée réelle. Cela permet au modèle de reconnaître des modèles plus complexes et des nuances dans la tâche. Par exemple : "Classez les phrases suivantes comme des questions ou des affirmations : 'Le ciel est bleu'. - Énoncé "Quelle heure est-il ?" - Question "J'aime les glaces". - Entrée d'énoncé : "Où puis-je trouver le restaurant le plus proche ?" - [le modèle génère la réponse]".

Concevoir des messages-guides efficaces

Concevoir des messages-guides efficaces est à la fois un art et une science. Voici quelques principes clés à prendre en compte :

Clarté et cohérence : Veillez à ce que vos exemples et vos instructions soient clairs et suivent un format cohérent. Cela permet au modèle de reconnaître plus facilement le modèle.

La diversité : Lorsque vous utilisez plusieurs exemples, essayez de couvrir un éventail d'entrées et de sorties possibles afin de donner au modèle une compréhension plus large de la tâche.

Pertinence : Choisissez des exemples étroitement liés à la tâche ou au domaine spécifique que vous visez. Cela permet au modèle de se concentrer sur les aspects les plus pertinents de ses connaissances.

Concision : S'il est important de fournir suffisamment de contexte, il faut éviter les questions trop longues ou trop complexes qui risquent d'embrouiller le modèle ou de diluer les informations essentielles.

Expérimentation : Don’t be afraid to iterate and experiment with different prompt structures and examples to find what works best for your specific use case.

En maîtrisant l'art des messages courts, nous pouvons libérer tout le potentiel des LLM, en leur permettant de s'attaquer à un large éventail de tâches avec un minimum d'informations ou de formation supplémentaires.

Ajustement fin des LLM : Adapter les modèles avec des données limitées

Alors que l'incitation à quelques essais est une technique puissante pour adapter les LLM à de nouvelles tâches sans modifier le modèle lui-même, le réglage fin offre un moyen de mettre à jour les paramètres du modèle pour une performance encore meilleure sur des tâches ou des domaines spécifiques. Le réglage fin nous permet d'exploiter les vastes connaissances encodées dans les LLM pré-entraînés tout en les adaptant à nos besoins spécifiques en n'utilisant qu'une petite quantité de données spécifiques à la tâche.

Comprendre le réglage fin dans le contexte des LLM

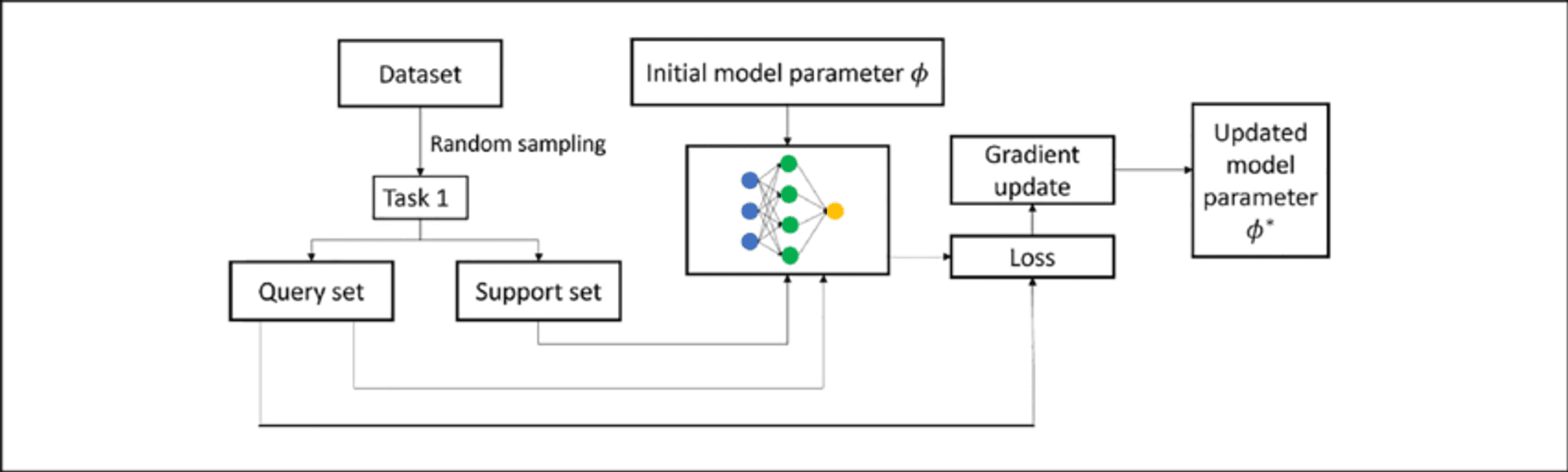

Fine-tuning an LLM involves further training a pre-trained model on a smaller, task-specific dataset. This process adapts the model to the target task while building upon existing knowledge, requiring less data and resources than training from scratch.

In LLMs, fine-tuning typically adjusts weights in upper layers for task-specific features, while lower layers remain largely unchanged. This “transfer learning” approach retains broad language understanding while developing specialized capabilities.

Techniques d'ajustement de quelques tirs

Few-shot fine-tuning adapts the model using only 10 to 100 samples per class or task, valuable when labeled data is scarce. Key techniques include:

Mise au point basée sur des invites : Combines few-shot prompting with parameter updates.

Approches de méta-apprentissage : Methods like MAML aim to find good initialization points for quick adaptation.

Adapter-based fine-tuning: Introduces small “adapter” modules between pre-trained model layers, reducing trainable parameters.

Apprentissage en contexte : Fine-tunes LLMs to better perform adaptation through prompts alone.

These techniques enable LLMs to adapt to new tasks with minimal data, enhancing their versatility and efficiency.

L'incitation à quelques coups de feu ou la mise au point : Choisir la bonne approche

Lorsqu'il s'agit d'adapter les LLM à des tâches spécifiques, l'incitation à quelques coups et le réglage fin offrent tous deux des solutions puissantes. Cependant, chaque méthode a ses propres forces et limites, et le choix de la bonne approche dépend de plusieurs facteurs.

Few-Shot Prompting Strengths:

Ne nécessite aucune mise à jour des paramètres du modèle, ce qui permet de conserver le modèle original.

Très flexible et adaptable à la volée

Pas de temps de formation ou de ressources informatiques supplémentaires nécessaires

Utile pour le prototypage et l'expérimentation rapides

Limites:

Les performances peuvent être moins régulières, en particulier pour les tâches complexes.

Limité par les capacités et les connaissances initiales du modèle

Peut éprouver des difficultés dans des domaines ou des tâches hautement spécialisés

Fine-Tuning Strengths:

Obtient souvent de meilleurs résultats dans des tâches spécifiques

Peut adapter le modèle à de nouveaux domaines et à un vocabulaire spécialisé

Des résultats plus cohérents pour des données similaires

Potentiel d'apprentissage et d'amélioration continus

Limites:

Nécessite un temps de formation et des ressources informatiques supplémentaires

Risque d'oubli catastrophique s'il n'est pas géré avec soin

Risque de surajustement sur les petits ensembles de données

Moins flexible ; nécessite une nouvelle formation en cas de modification importante des tâches

Top 5 Research Papers for Few-Shot Learning

This week, we also explore the following five papers that have significantly advanced this field, introducing innovative approaches that are reshaping AI capabilities.

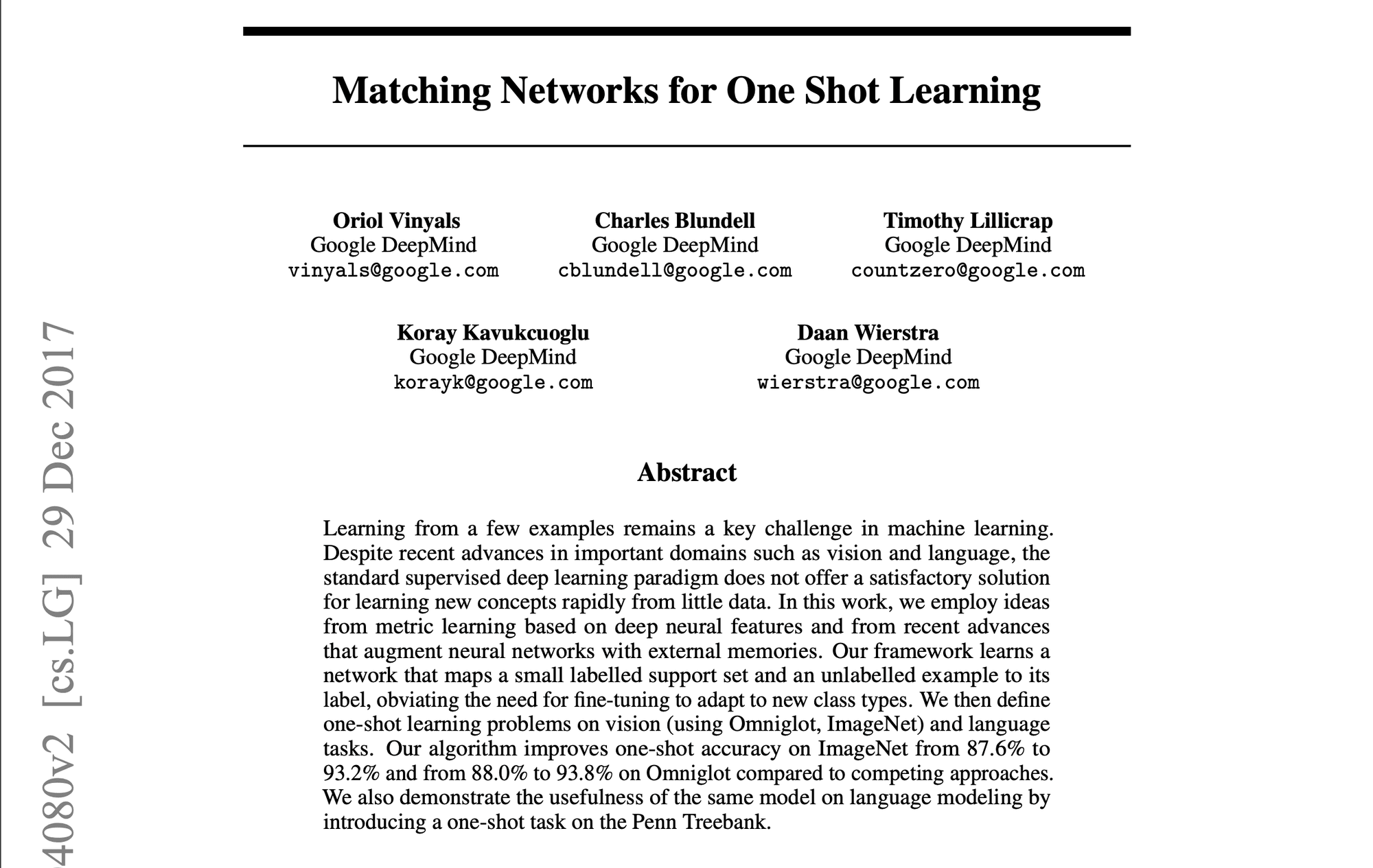

1️⃣ Matching Networks for One Shot Learning” (Vinyals et al., 2016)

Introduced a groundbreaking approach using memory and attention mechanisms. The matching function compares query examples to labeled support examples, setting a new standard for few-shot learning methods.

2️⃣ Prototypical Networks for Few-shot Learning” (Snell et al., 2017)

Presented a simpler yet effective approach, learning a metric space where classes are represented by a single prototype. Its simplicity and effectiveness made it a popular baseline for subsequent research.

3️⃣ Learning to Compare: Relation Network for Few-Shot Learning” (Sung et al., 2018)

Introduced a learnable relation module, allowing the model to learn a comparison metric tailored to specific tasks and data distributions. Demonstrated strong performance across various benchmarks.

4️⃣ A Closer Look at Few-shot Classification” (Chen et al., 2019)

Provided a comprehensive analysis of existing methods, challenging common assumptions. Proposed simple baseline models that matched or exceeded more complex approaches, emphasizing the importance of feature backbones and training strategies.

5️⃣ Meta-Baseline: Exploring Simple Meta-Learning for Few-Shot Learning” (Chen et al., 2021)

Combined standard pre-training with a meta-learning stage, achieving state-of-the-art performance. Highlighted the trade-offs between standard training and meta-learning objectives.

These papers have not only advanced academic research but also paved the way for practical applications in enterprise AI. They represent a progression towards more efficient, adaptable AI systems capable of learning from limited data – a crucial capability in many business contexts.

Le bilan

Few-shot learning, prompting, and fine-tuning represent groundbreaking approaches, enabling LLMs to adapt swiftly to specialized tasks with minimal data. As we’ve explored, these techniques offer unprecedented flexibility and efficiency in tailoring LLMs to diverse applications across industries, from enhancing natural language processing tasks to enabling domain-specific adaptations in fields like healthcare, law, and technology.

Merci d'avoir pris le temps de lire AI & YOU !

Pour obtenir encore plus de contenu sur l'IA d'entreprise, y compris des infographies, des statistiques, des guides pratiques, des articles et des vidéos, suivez Skim AI sur LinkedIn

Vous êtes un fondateur, un PDG, un investisseur en capital-risque ou un investisseur à la recherche de services de conseil en IA, de développement d'IA fractionnée ou de due diligence ? Obtenez les conseils dont vous avez besoin pour prendre des décisions éclairées sur la stratégie des produits d'IA de votre entreprise et les opportunités d'investissement.

Nous construisons des solutions d'IA personnalisées pour les entreprises financées par le capital-risque et le capital-investissement dans les secteurs suivants : Technologie médicale, agrégation de nouvelles/contenu, production de films et de photos, technologie éducative, technologie juridique, Fintech & Cryptocurrency.