Le lama de Meta 3.1 : Repousser les limites de l'IA Open-Source

Meta a récemment annoncé Llama 3.1La Commission européenne a publié le premier modèle de langage de grande taille (LLM) à code source ouvert, le plus avancé à ce jour. Cette version marque une étape importante dans la démocratisation de la technologie de l'IA, en comblant potentiellement le fossé entre les modèles open-source et les modèles propriétaires.

Llama 3.1 est un grand pas en avant dans les capacités d'IA open-source. Avec son modèle phare de 405 milliards de paramètres, Meta remet en question l'idée selon laquelle l'IA de pointe doit être fermée et propriétaire. Cette version marque le début d'une nouvelle ère où les capacités d'IA de pointe sont accessibles aux chercheurs, aux développeurs et aux entreprises de toutes tailles.

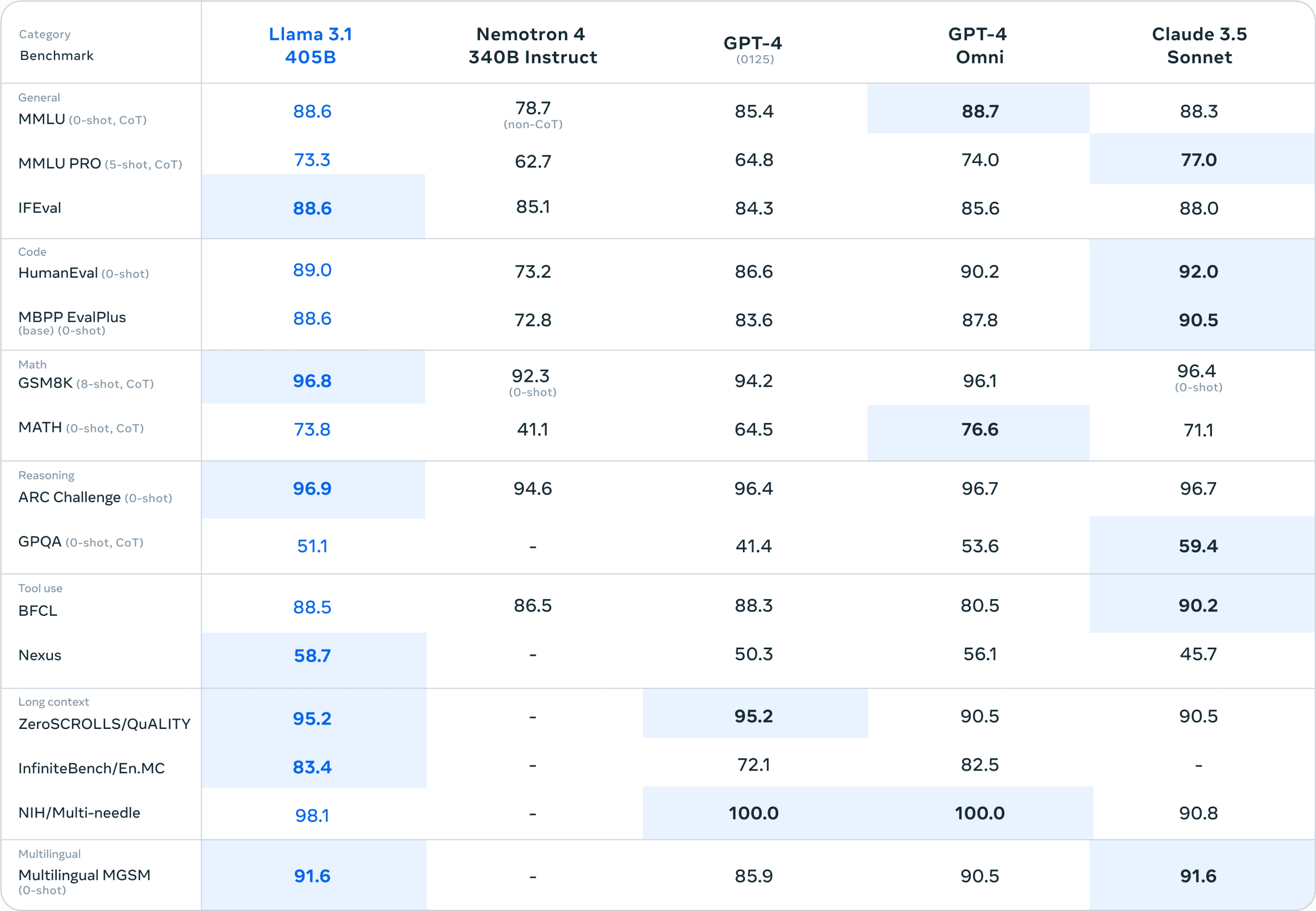

Les principales améliorations de Llama 3.1 comprennent une longueur de contexte étendue à 128 000 tokens, la prise en charge de huit langues et des performances inégalées dans des domaines tels que le raisonnement, les mathématiques et la génération de code. Ces avancées font de Llama 3.1 un outil polyvalent capable de s'attaquer à des tâches complexes et réelles dans divers domaines au sein de l'entreprise.

L'évolution du lama : de 2 à 3.1

Pour apprécier l'importance de Llama 3.1, il convient de revenir sur ses prédécesseurs. Llama 2, publié en 2023, représentait déjà une avancée majeure dans le domaine de l'IA open-source. Il proposait des modèles allant de 7B à 70B paramètres et démontrait des performances compétitives dans divers benchmarks.

Llama 3.1 s'appuie sur cette base et propose plusieurs avancées majeures :

Augmentation de la taille du modèle : L'introduction du modèle de paramètres 405B repousse les limites de ce qui est possible en matière d'IA open-source.

Extension de la durée du contexte : De 4K tokens dans Llama 2 à 128K dans Llama 3.1, permettant une compréhension plus complexe et plus nuancée des textes plus longs.

Capacités multilingues : La prise en charge élargie des langues permet des applications plus diversifiées dans différentes régions et différents cas d'utilisation.

Amélioration du raisonnement et des tâches spécialisées : Amélioration des performances dans des domaines tels que le raisonnement mathématique et la génération de code.

Comparée à des modèles à code source fermé tels que GPT-4 et Claude 3.5 Sonnet, la Llama 3.1 405B tient son rang dans divers benchmarks. Ce niveau de performance dans un modèle à code source ouvert est sans précédent.

Spécifications techniques de Llama 3.1

En ce qui concerne les détails techniques, Llama 3.1 offre une gamme de tailles de modèles pour répondre à différents besoins et ressources informatiques :

Modèle de paramètres 8B : Convient aux applications légères et aux appareils périphériques.

Modèle de paramètres 70B : Un équilibre entre les exigences en matière de performances et de ressources.

405B modèle de paramètres : Le modèle phare, qui repousse les limites des capacités d'IA en source ouverte.

La méthodologie de formation pour Llama 3.1 a impliqué un ensemble massif de données de plus de 15 trillions de jetons, beaucoup plus important que ses prédécesseurs. Ces données d'entraînement étendues, combinées à des techniques raffinées de curation et de prétraitement des données, contribuent à l'amélioration des performances et de la polyvalence du modèle.

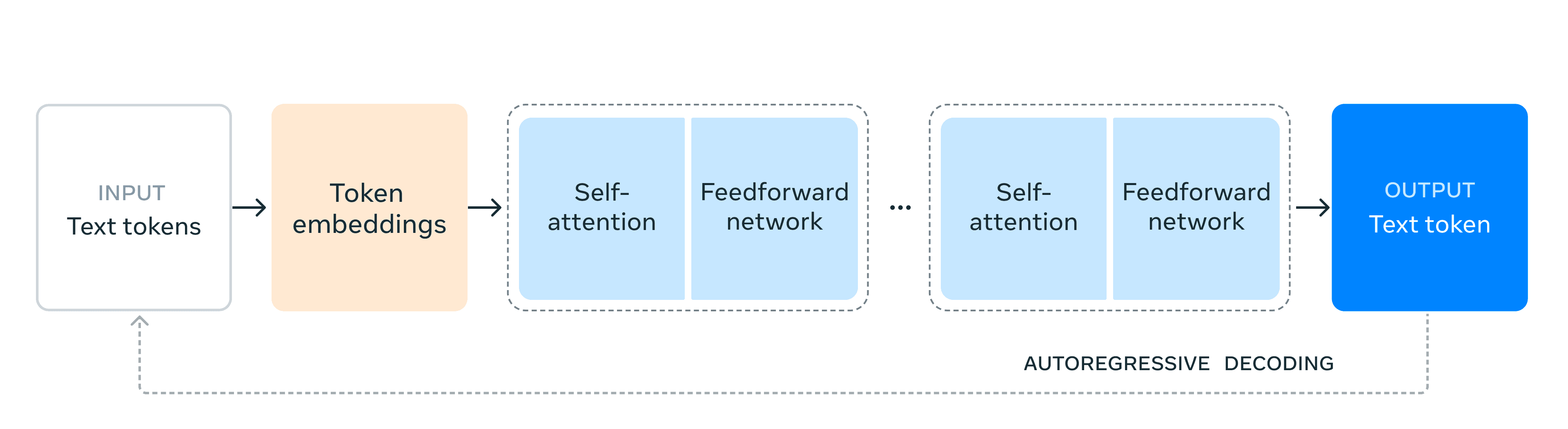

Sur le plan architectural, Llama 3.1 conserve un modèle de transformateur de décodeur uniquement, privilégiant la stabilité de l'apprentissage à des approches plus expérimentales telles que le mélange d'experts. Cependant, Meta a mis en œuvre plusieurs optimisations pour permettre une formation et une inférence efficaces à cette échelle sans précédent :

Infrastructure de formation évolutive : Utilisation de plus de 16 000 GPU H100 pour entraîner le modèle 405B.

Procédure itérative de post-entraînement : L'utilisation de la mise au point supervisée et de l'optimisation des préférences directes pour améliorer les capacités spécifiques.

Techniques de quantification : Réduction du modèle de 16 bits à 8 bits pour une inférence plus efficace, permettant un déploiement sur un seul nœud de serveur.

Ces choix techniques reflètent un équilibre entre la nécessité de repousser les limites de la taille des modèles et celle d'assurer une utilisation pratique dans toute une série de scénarios de déploiement.

En mettant ces modèles avancés à la disposition de tous, Meta ne se contente pas de partager un produit, mais fournit une plateforme d'innovation. Les spécifications techniques du Llama 3.1 offrent aux chercheurs et aux développeurs de nouvelles possibilités d'explorer des applications d'IA de pointe, accélérant ainsi le rythme des progrès de l'IA dans l'ensemble du secteur.

Capacités de rupture

Llama 3.1 présente plusieurs fonctionnalités révolutionnaires qui le distinguent dans le paysage de l'IA :

Longueur du contexte élargi

Le passage à une fenêtre contextuelle de 128 Ko change la donne. Cette capacité élargie permet au Llama 3.1 de traiter et de comprendre des morceaux de texte beaucoup plus longs :

Analyse complète des documents

Génération de contenu long format

Traitement plus nuancé des conversations

Cette caractéristique ouvre de nouvelles possibilités d'applications dans des domaines tels que le traitement des documents juridiques, l'analyse de la littérature et la résolution de problèmes complexes nécessitant de retenir et de synthétiser de grandes quantités d'informations.

Support multilingue

La prise en charge de huit langues par Llama 3.1 élargit considérablement ses possibilités d'application à l'échelle mondiale. Cette capacité multilingue :

Améliore la communication interculturelle

Des applications d'IA plus inclusives

Soutenir les opérations commerciales mondiales

En éliminant les barrières linguistiques, Llama 3.1 ouvre la voie à des solutions d'IA plus diversifiées et orientées vers le monde.

Raisonnement avancé et utilisation d'outils

Le modèle démontre des capacités de raisonnement sophistiquées et l'aptitude à utiliser efficacement des outils externes. Ces progrès se manifestent par :

Amélioration de la déduction logique et de la résolution de problèmes

Capacité accrue à suivre des instructions complexes

Utilisation efficace des bases de connaissances externes et des API

Ces capacités font de Llama 3.1 un outil puissant pour les tâches nécessitant des compétences cognitives de haut niveau, de la planification stratégique à l'analyse de données complexes.

Génération de code et prouesses mathématiques

Llama 3.1 fait preuve de capacités remarquables dans les domaines techniques :

Générer un code fonctionnel de haute qualité dans plusieurs langages de programmation

Résoudre des problèmes mathématiques complexes avec précision

Aide à la conception et à l'optimisation des algorithmes

Ces caractéristiques font de Llama 3.1 un atout précieux pour le développement de logiciels, le calcul scientifique et les applications d'ingénierie.

L'avantage du logiciel libre

La nature open-source de Llama 3.1 apporte plusieurs avantages significatifs.

En mettant gratuitement à disposition des capacités d'IA d'avant-garde, Meta est :

Abaisser les barrières à l'entrée pour la recherche et le développement de l'IA

Permettre aux petites organisations et aux développeurs individuels d'exploiter l'IA avancée

Favoriser un écosystème de l'IA plus diversifié et plus innovant

Cette démocratisation pourrait conduire à une prolifération des applications de l'IA dans divers secteurs, ce qui pourrait accélérer le progrès technologique.

La possibilité d'accéder aux poids des modèles de Llama 3.1 et de les modifier ouvre des perspectives de personnalisation sans précédent :

Adaptation spécifique à un domaine pour les industries spécialisées

Ajustement pour des cas d'utilisation et des ensembles de données uniques

Expérimentation de nouvelles techniques et architectures de formation

Cette flexibilité permet aux organisations d'adapter le modèle à leurs besoins spécifiques, ce qui peut déboucher sur des solutions d'IA plus efficaces et plus efficientes.

Ecosystème et déploiement

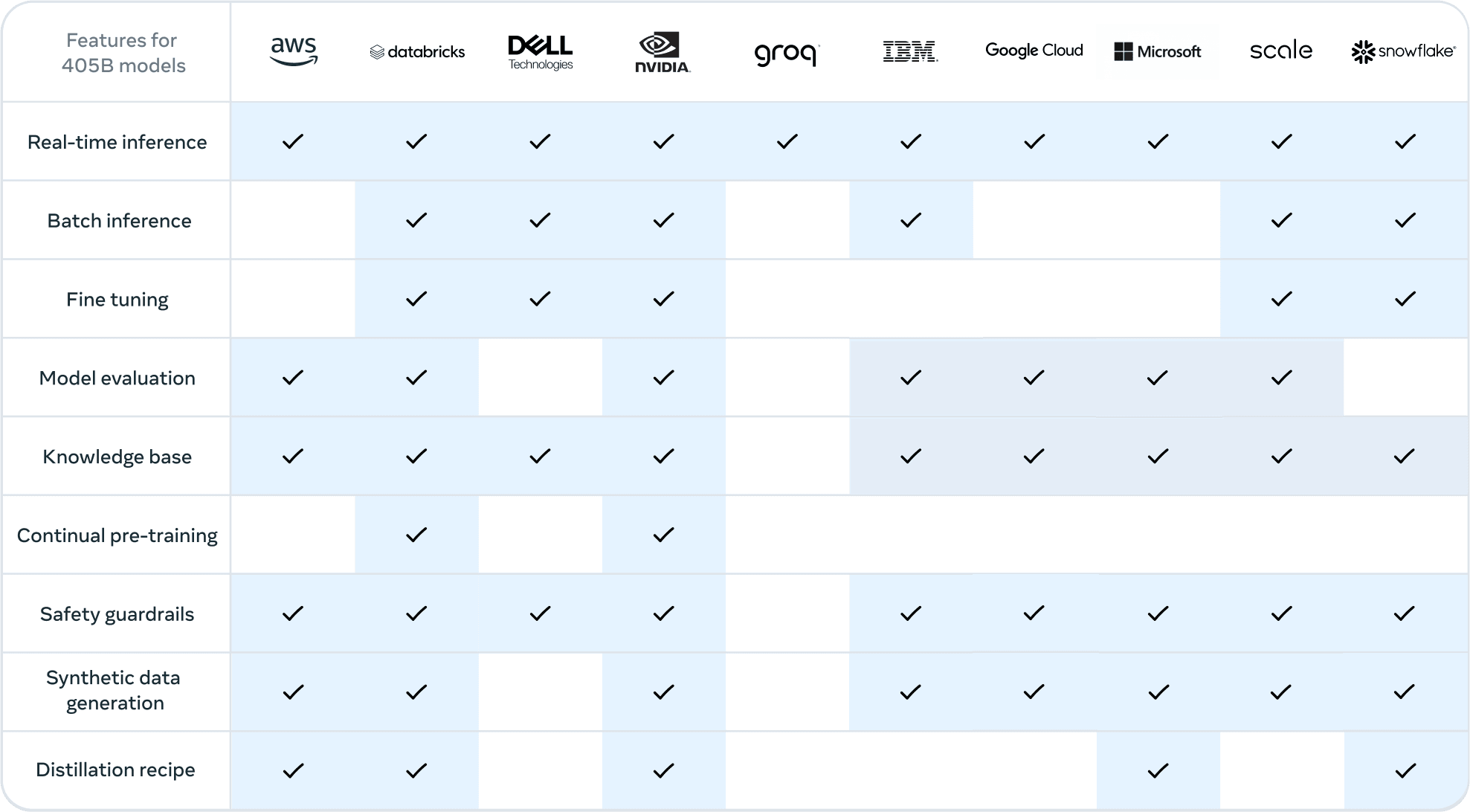

La sortie de Llama 3.1 s'accompagne d'un écosystème solide pour soutenir son déploiement et son utilisation :

Intégrations de partenaires

Meta a collaboré avec les leaders de l'industrie afin d'assurer un support étendu pour Llama 3.1 :

Les fournisseurs de services en nuage tels que AWS, Google Cloud et Azure offrent des options de déploiement transparentes.

Les fabricants de matériel tels que NVIDIA et Dell fournissent une infrastructure optimisée.

Les plateformes de données telles que Databricks et Snowflake permettent un traitement efficace des données et l'intégration des modèles.

Ces partenariats permettent aux organisations de tirer parti de Llama 3.1 dans le cadre de leurs technologies existantes.

Optimisation de l'inférence et évolutivité

Afin de rendre Llama 3.1 pratique pour les applications du monde réel, plusieurs optimisations ont été mises en œuvre :

Les techniques de quantification réduisent les besoins de calcul du modèle.

Des moteurs d'inférence optimisés tels que vLLM et TensorRT améliorent les performances.

Les options de déploiement évolutives répondent à différents cas d'utilisation, des appareils périphériques aux centres de données.

Ces optimisations permettent de déployer même le modèle de paramètres 405B dans des environnements de production.

La pile de lamas et les efforts de normalisation

Meta milite pour une normalisation de l'écosystème de l'IA :

Le projet Llama Stack vise à créer une interface commune pour les composants d'IA.

Des API normalisées pourraient faciliter l'intégration et l'interopérabilité entre les différents outils et plateformes d'IA.

Cette initiative pourrait déboucher sur un écosystème de développement de l'IA plus cohérent et plus efficace.

Les promesses et le potentiel de Llama 3.1

La sortie de Llama 3.1 de Meta marque un tournant dans le paysage de l'IA, en démocratisant l'accès à des capacités d'IA d'avant-garde. En proposant un modèle à 405 paramètres avec des performances de pointe, un support multilingue et une longueur de contexte étendue, le tout dans un cadre open-source, Meta a établi un nouveau standard pour une IA accessible et puissante. Cette initiative remet non seulement en question la domination des modèles à source fermée, mais ouvre également la voie à une innovation et à une collaboration sans précédent dans la communauté de l'IA.

À la croisée des chemins du développement de l'intelligence artificielle, Llama 3.1 représente plus qu'une simple avancée technologique ; il incarne la vision d'un avenir plus ouvert, plus inclusif et plus dynamique pour l'intelligence artificielle. L'impact réel de cette version se révélera lorsque les développeurs, les chercheurs et les entreprises du monde entier exploiteront son potentiel, remodelant les industries et repoussant les limites de ce qui est possible avec les LLM.