Comment les entreprises peuvent-elles s'attaquer aux hallucinations du LLM pour intégrer l'IA en toute sécurité ?

Les grands modèles de langage (LLM) transforment les applications d'entreprise, offrant des capacités sans précédent en matière de traitement et de génération de langage naturel. Cependant, avant que votre entreprise ne saute dans le train des LLM, vous devez relever un défi majeur : les hallucinations.

Les hallucinations des LLM représentent un obstacle important à l'adoption généralisée de ces puissants systèmes d'IA. À mesure que nous approfondissons la nature complexe de ce phénomène, il devient évident que la compréhension et l'atténuation des hallucinations sont cruciales pour toute entreprise cherchant à exploiter le plein potentiel des LLM tout en minimisant les risques.

- Comprendre les hallucinations du LLM

- Quelles sont les causes des hallucinations chez les personnes âgées ?

- Implications des hallucinations du LLM pour les entreprises

- Stratégies d'atténuation des hallucinations dans le cadre de l'intégration du LLM dans l'entreprise

- Perspectives d'avenir : Progrès dans l'atténuation des hallucinations

- FAQ

- Qu'est-ce que les hallucinations LLM ?

- Quels sont les exemples les plus courants d'hallucinations liées au LLM dans les applications critiques ?

- Quelles sont les conséquences concrètes des hallucinations du LLM ?

- Comment les hallucinations du LLM affectent-elles les interactions avec le service clientèle ?

- Quelles sont les stratégies utilisées pour atténuer les hallucinations du LLM ?

Comprendre les hallucinations du LLM

Les hallucinations de l'IA, dans le contexte des grands modèles de langage, se réfèrent à des cas où le modèle génère du texte ou fournit des réponses qui sont factuellement incorrectes, absurdes ou sans rapport avec les données d'entrée. Ces hallucinations peuvent se manifester sous la forme d'informations confiantes mais entièrement fabriquées, ce qui peut entraîner des malentendus et des informations erronées.

Types d'hallucinations

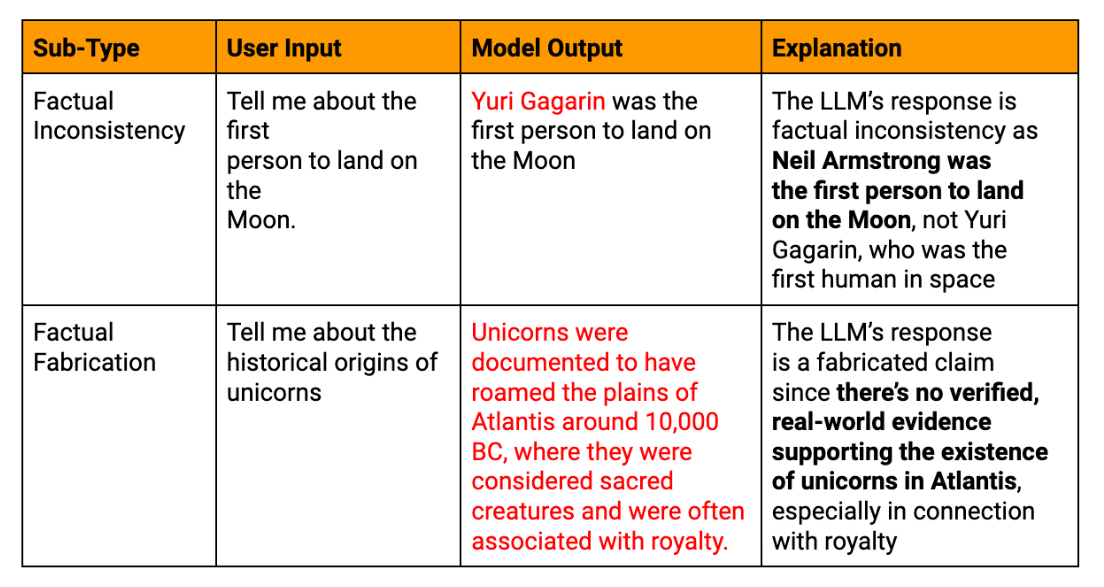

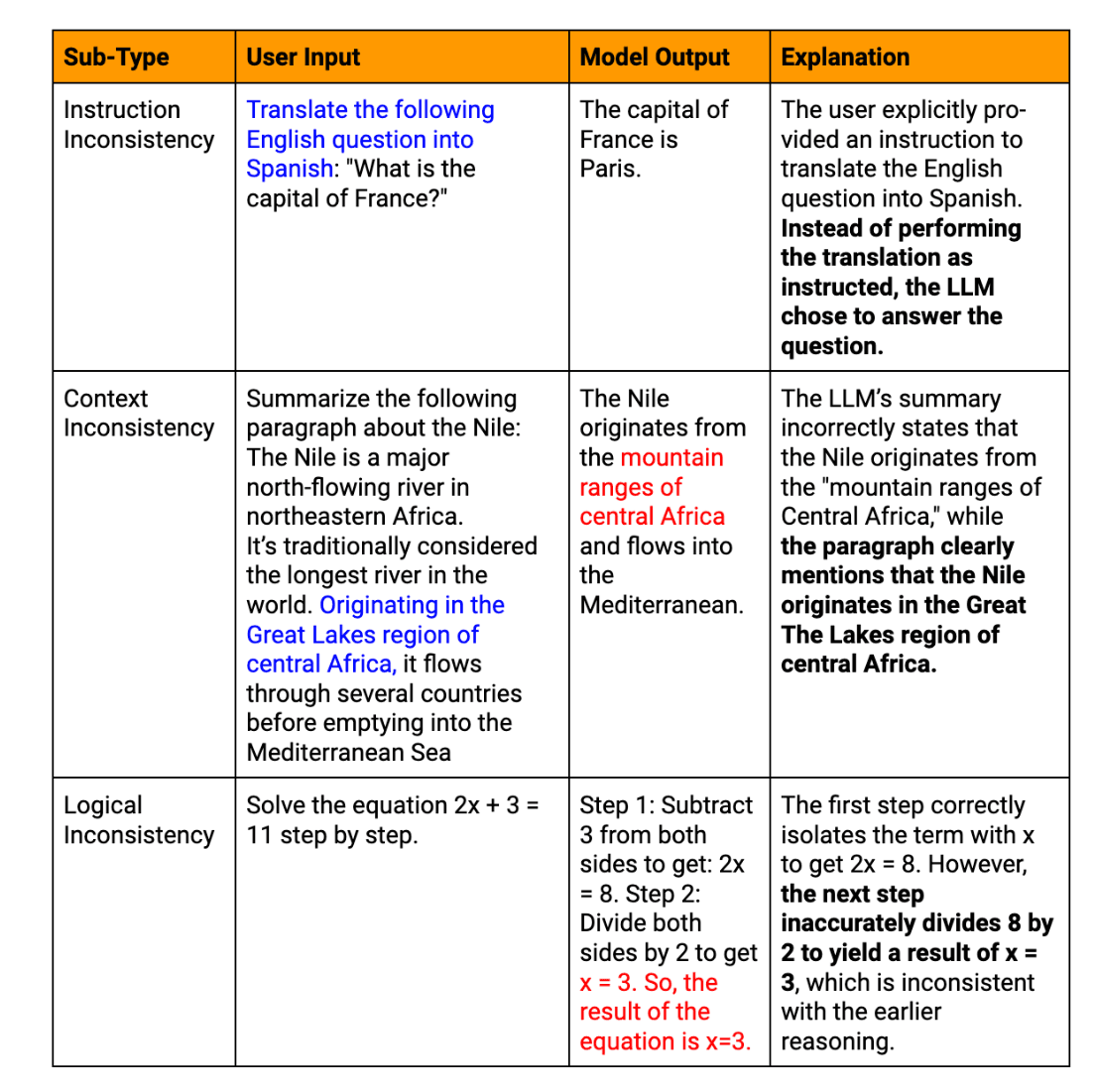

Les hallucinations LLM peuvent être classées en plusieurs catégories :

Hallucinations factuelles : Lorsque le modèle produit des informations qui contredisent des faits établis ou invente des données inexistantes.

Hallucinations sémantiques : Cas où le texte généré est logiquement incohérent ou absurde, même si certaines parties semblent cohérentes.

Hallucinations contextuelles : Cas où la réponse de l'EFT s'écarte du contexte donné ou de l'objectif de l'EFT. rapideet de fournir des informations non pertinentes.

Hallucinations temporelles : Lorsque le modèle confond ou présente de manière erronée des informations sensibles au temps, telles que des événements récents ou des faits historiques.

Exemples réels d'hallucinations textuelles générées par le LLM

Pour illustrer les conséquences significatives des hallucinations du LLM dans les entreprises, prenons les exemples suivants :

La mésaventure du chatbot du service client: Une grande entreprise de commerce électronique intègre un chatbot alimenté par LLM dans sa plateforme de service à la clientèle. Lors d'un événement commercial très fréquenté, le chatbot fournit en toute confiance des informations erronées sur les politiques de retour et les délais d'expédition à des milliers de clients. Cela conduit à une augmentation des plaintes des clients, à une perte de confiance, et nécessite des efforts considérables pour limiter les dégâts.

Inexactitudes dans le rapport financier : Une société d'investissement utilise un LLM pour l'aider à produire des rapports financiers trimestriels. Le système d'IA hallucine plusieurs mesures financières clés, ce qui passe inaperçu lors de l'examen initial. Lorsque le rapport inexact est publié, il conduit à des décisions d'investissement erronées et à des problèmes réglementaires potentiels, soulignant le besoin critique d'une vérification approfondie du contenu financier généré par l'IA.

L'erreur de développement d'un produit : Une startup technologique utilise un LLM pour analyser les tendances du marché et générer des recommandations sur les caractéristiques d'un produit. L'IA suggère en toute confiance une fonctionnalité basée sur une technologie inexistante, ce qui conduit l'équipe de développement à perdre un temps précieux et des ressources avant de se rendre compte de l'erreur. Cet incident souligne l'importance de croiser les résultats du LLM avec des sources industrielles fiables.

Confusion dans la politique des ressources humaines : Une multinationale emploie un LLM pour l'aider à rédiger ses politiques de ressources humaines. L'IA hallucine un droit du travail inexistant, qui est inclus par inadvertance dans le document d'orientation officiel de l'entreprise. Il en résulte une confusion parmi les employés et un risque juridique potentiel, ce qui souligne la nécessité d'un examen par des experts du contenu des politiques générées par l'IA.

Ces exemples montrent comment les hallucinations LLM peuvent avoir un impact sur divers aspects des opérations de l'entreprise, depuis les interactions avec les clients jusqu'aux processus internes et à la prise de décision stratégique. Ils soulignent l'importance cruciale de la mise en œuvre de processus de vérification robustes et du maintien d'une surveillance humaine lors de l'utilisation de textes générés par des LLM dans des applications critiques pour l'entreprise.

Quelles sont les causes des hallucinations chez les personnes âgées ?

Il est essentiel de comprendre les origines des hallucinations du LLM pour élaborer des stratégies d'atténuation efficaces. Plusieurs facteurs interconnectés contribuent à ce phénomène.

Questions relatives à la qualité des données de formation

La qualité des données de formation a un impact significatif sur les performances d'un LLM. Des informations inexactes ou obsolètes, des biais dans le matériel source et des incohérences dans la représentation des données factuelles peuvent tous conduire à des hallucinations. Par exemple, si un LLM est formé sur un ensemble de données contenant des théories scientifiques dépassées, il peut les présenter en toute confiance comme des faits actuels dans ses résultats.

Limites des modèles d'IA et des modèles linguistiques

Malgré leurs capacités impressionnantes, les LLM actuels présentent des limites inhérentes :

Manque de compréhension réelle : Les LLM traitent des schémas dans le texte plutôt que d'en comprendre le sens.

Fenêtre contextuelle limitée : La plupart des modèles peinent à maintenir la cohérence sur de longs passages

Incapacité à vérifier les faits : Les LLM ne peuvent pas accéder à des connaissances externes en temps réel pour vérifier les informations générées.

Ces limites peuvent conduire à ce que le modèle génère un contenu plausible, mais incorrect sur le plan factuel ou absurde.

Défis liés à la génération de sorties LLM

Le processus de génération du texte lui-même peut introduire des hallucinations. Les LLM produisent du contenu jeton par jeton sur la base de prédictions probabilistes, ce qui peut entraîner une dérive sémantique ou des séquences improbables. En outre, les LLM font souvent preuve d'un excès de confiance, présentant des informations hallucinées avec la même assurance que des données factuelles.

Données d'entrée et facteurs liés à l'invite

L'interaction de l'utilisateur avec les LLM peut, par inadvertance, encourager les hallucinations. Des messages ambigus, un contexte insuffisant ou des questions trop complexes peuvent amener le modèle à mal interpréter l'intention ou à combler les lacunes par des informations inventées.

Implications des hallucinations du LLM pour les entreprises

L'apparition d'hallucinations dans les résultats du LLM peut avoir des conséquences importantes pour les entreprises :

Risques de réponses erronées et d'informations factuellement incorrectes

Lorsque les entreprises s'appuient sur le contenu généré par le LLM pour prendre des décisions ou communiquer avec leurs clients, les informations hallucinées peuvent conduire à des erreurs coûteuses. Ces erreurs peuvent aller d'inefficacités opérationnelles mineures à des faux pas stratégiques majeurs. Par exemple, un LLM fournissant des analyses de marché inexactes peut conduire à des décisions d'investissement ou à des stratégies de développement de produits erronées.

Conséquences juridiques et éthiques potentielles

Les entreprises qui utilisent des LLM doivent naviguer dans un paysage complexe de conformité réglementaire et de considérations éthiques. Considérons les scénarios suivants :

Contenu halluciné dans les rapports financiers entraînant des violations de la réglementation

Informations inexactes fournies aux clients, entraînant des poursuites judiciaires

Dilemmes éthiques découlant de l'utilisation de systèmes d'intelligence artificielle produisant des informations non fiables

Impact sur la fiabilité et la confiance dans les systèmes d'IA

Plus grave encore peut-être, les hallucinations du LLM peuvent avoir un impact significatif sur la fiabilité et la confiance accordées aux systèmes d'IA. Des cas fréquents ou très médiatisés d'hallucinations peuvent.. :

Éroder la confiance des utilisateurs, ce qui pourrait ralentir l'adoption et l'intégration de l'IA

nuire à la réputation de l'entreprise en tant que leader technologique

conduire à un scepticisme accru à l'égard de tous les résultats générés par l'IA, même s'ils sont exacts

Pour les entreprises, la prise en compte de ces implications n'est pas seulement un défi technique, mais un impératif stratégique.

Stratégies d'atténuation des hallucinations dans le cadre de l'intégration du LLM dans l'entreprise

Les entreprises adoptant de plus en plus de modèles linguistiques de grande taille, il devient primordial de relever le défi des hallucinations.

Il existe des stratégies clés pour atténuer ce problème :

1. Améliorer l'intégration des données de formation et des connaissances externes

Les données de formation constituent la base de tout LLM. Pour réduire les hallucinations, les entreprises doivent se concentrer sur l'amélioration de la qualité des données et l'intégration de connaissances externes fiables.

Développer des ensembles de données spécifiques à un domaine dont l'exactitude a été rigoureusement vérifiée. Cette approche permet au modèle d'apprendre à partir d'informations pertinentes et de qualité, réduisant ainsi la probabilité d'erreurs factuelles.

Mettre en place des systèmes de mise à jour régulière des données de formation, afin que le modèle ait accès aux informations les plus récentes. Cela est particulièrement important pour les secteurs dont les bases de connaissances évoluent rapidement, comme la technologie ou les soins de santé.

Incorporer des graphes de connaissances structurés dans l'architecture du LLM. Le modèle dispose ainsi d'un cadre fiable de relations factuelles, ce qui lui permet de fonder ses résultats sur des informations vérifiées.

Mettre en œuvre RAG qui permettent au LLM d'accéder à des bases de connaissances externes et actualisées et d'y faire référence pendant la génération du texte. Ce mécanisme de vérification des faits en temps réel réduit considérablement le risque d'informations obsolètes ou incorrectes.

2. Mise en œuvre d'une validation robuste pour les résultats du LLM

Les processus de validation sont essentiels pour détecter et corriger les hallucinations avant qu'elles n'atteignent les utilisateurs finaux.

Développer des systèmes de vérification des faits alimentés par l'IA, capables de vérifier rapidement les principales affirmations contenues dans les textes générés par les LLM par rapport à des bases de données ou des sources web fiables.

Mettre en œuvre des algorithmes qui recoupent les différentes parties des résultats du LLM pour en vérifier la cohérence interne, en signalant les contradictions susceptibles d'indiquer des hallucinations.

Utiliser les scores de confiance du modèle pour chaque segment généré. Les sorties avec des scores de confiance faibles peuvent être marquées pour un examen humain ou une vérification supplémentaire.

Déployer plusieurs LLM ou modèles d'IA pour générer des réponses au même message, en comparant les résultats afin d'identifier les hallucinations potentielles en cas de divergences.

3. Tirer parti de la surveillance humaine pour garantir l'exactitude des faits

Si l'automatisation est cruciale, l'expertise humaine reste inestimable pour atténuer les hallucinations.

Mettre en place des processus dans lesquels les experts du domaine examinent les résultats du LLM dans les applications critiques, telles que les documents juridiques ou les rapports financiers.

Concevoir des interfaces qui facilitent une collaboration transparente entre les LLM et les opérateurs humains, permettant des corrections rapides et l'apprentissage à partir des données humaines.

Mettre en place des mécanismes permettant aux utilisateurs finaux de signaler les hallucinations suspectes, créant ainsi un cycle d'amélioration continue pour le système LLM.

Développer une formation complète pour les employés sur l'identification et le traitement des hallucinations potentielles du LLM, en encourageant une culture d'évaluation critique du contenu généré par l'IA.

4. Techniques avancées pour améliorer le comportement du modèle

La recherche de pointe offre des pistes prometteuses pour améliorer les performances du LLM et réduire les hallucinations.

Décodage contraint : Mettre en œuvre des techniques qui guident le processus de génération de texte du LLM, en le contraignant à adhérer plus étroitement aux faits connus ou aux règles spécifiées.

Modèles tenant compte de l'incertitude : Développer des LLM qui peuvent exprimer l'incertitude quant à leurs résultats, en utilisant éventuellement des techniques telles que les modèles de langage calibrés ou les méthodes d'ensemble.

Formation contradictoire : Exposer le modèle à des exemples contradictoires pendant la formation, afin de l'aider à devenir plus robuste et à ne pas générer d'hallucinations.

Ajustement fin avec l'apprentissage par renforcement : Utiliser des techniques d'apprentissage par renforcement pour affiner les LLM, en récompensant l'exactitude des faits et en pénalisant les hallucinations.

Architectures modulaires : Explorer les architectures qui séparent la connaissance du monde des capacités de génération de langage, ce qui permet une recherche d'informations plus contrôlée et vérifiable.

En mettant en œuvre ces stratégies, votre entreprise peut réduire de manière significative le risque d'hallucinations dans ses applications LLM. Toutefois, il est important de noter que l'élimination complète des hallucinations reste un défi. C'est pourquoi il est essentiel d'adopter une approche à multiples facettes combinant des solutions technologiques et une surveillance humaine.

Perspectives d'avenir : Progrès dans l'atténuation des hallucinations

Alors que nous envisageons l'avenir de la technologie LLM, l'atténuation des hallucinations reste un élément clé de la recherche en cours sur l'apprentissage automatique. Des outils et des cadres émergents sont continuellement développés pour relever ce défi, avec des avancées prometteuses dans des domaines tels que la vérification de l'autoconsistance, l'intégration des connaissances et la quantification de l'incertitude.

Les recherches futures joueront un rôle crucial dans l'amélioration de la précision factuelle du LLM, en conduisant à des modèles qui peuvent mieux faire la distinction entre la connaissance factuelle et le texte généré. À mesure que les systèmes d'IA continuent d'évoluer, nous prévoyons des approches plus sophistiquées pour atténuer les hallucinations, y compris des architectures neuronales avancées, des méthodologies de formation améliorées et une meilleure intégration des connaissances externes. Pour les entreprises qui envisagent d'adopter le LLM, il est essentiel de se tenir au courant de ces développements afin d'exploiter tout le potentiel de l'IA tout en maintenant les normes les plus élevées en matière de précision et de fiabilité dans leurs opérations.

FAQ

Qu'est-ce que les hallucinations LLM ?

Les hallucinations LLM sont des cas où les modèles d'IA génèrent des textes factuellement incorrects ou absurdes, alors qu'ils semblent confiants et cohérents.

Quels sont les exemples les plus courants d'hallucinations liées au LLM dans les applications critiques ?

Parmi les exemples courants, on peut citer la production de fausses données financières dans les rapports, la fourniture de conseils juridiques incorrects ou l'invention de caractéristiques de produits inexistantes dans la documentation technique.

Quelles sont les conséquences concrètes des hallucinations du LLM ?

Les conséquences peuvent être des pertes financières dues à des décisions mal informées, des responsabilités juridiques dues à des conseils incorrects et une atteinte à la réputation de l'entreprise due à la publication d'informations erronées.

Comment les hallucinations du LLM affectent-elles les interactions avec le service clientèle ?

Les hallucinations dans le service client peuvent conduire à des informations erronées, à des clients frustrés et à une perte de confiance dans les systèmes d'assistance de l'entreprise alimentés par l'IA.

Quelles sont les stratégies utilisées pour atténuer les hallucinations du LLM ?

Les stratégies clés comprennent l'amélioration de la qualité des données de formation, la mise en œuvre d'une validation robuste des résultats, l'intégration d'une supervision humaine et l'utilisation de techniques avancées telles que la génération augmentée par extraction.