Comment AgentOps aide à gérer les coûts de l'apprentissage tout au long de la vie

En tant que Agents d'intelligence artificielle Alors que les agents d'intelligence artificielle sont de plus en plus présents dans les solutions d'entreprise, la gestion des coûts des grands modèles de langage (LLM) est devenue une préoccupation majeure pour les développeurs et les entreprises. Les LLM, bien que puissants, peuvent être coûteux à exploiter, en particulier à grande échelle. L'importance croissante de la gestion des coûts des LLM dans le développement des agents d'IA ne peut être surestimée, car elle a un impact direct sur la faisabilité et...

Suivi et optimisation Utilisation du LLM présente plusieurs défis. Les développeurs doivent naviguer dans le paysage complexe de la consommation de jetons, en équilibrant le besoin de capacités d'IA sophistiquées avec les contraintes budgétaires. En outre, la nature dynamique des interactions entre les agents d'IA rend difficile la prévision et le contrôle efficace des coûts. Ces défis soulignent la nécessité de disposer d'outils et de stratégies robustes pour gérer les dépenses de LLM tout en maintenant des agents d'IA performants.

- Fonctionnalités complètes de gestion des coûts du LLM proposées par AgentOps

- Analyse détaillée des coûts et optimisation

- Intégration avec les cadres d'agents d'IA

- Équilibrer les performances et les coûts dans le développement d'agents d'intelligence artificielle

- Sécurité et conformité dans la gestion des coûts du LLM

- Permettre le développement rentable d'agents d'IA

Fonctionnalités complètes de gestion des coûts du LLM proposées par AgentOps

AgentOps offre une série de fonctions puissantes conçues pour répondre aux complexités de la gestion des coûts de la LLM. Au cœur de ces fonctionnalités se trouve le suivi en temps réel de l'utilisation et de la dépense des jetons. Cette fonction permet aux développeurs de surveiller les coûts au fur et à mesure qu'ils se produisent, offrant une visibilité immédiate sur la façon dont les agents d'intelligence artificielle consomment les ressources LLM. En offrant ce niveau de granularité, AgentOps permet aux développeurs de prendre des décisions éclairées sur l'allocation et l'optimisation des ressources en temps réel.

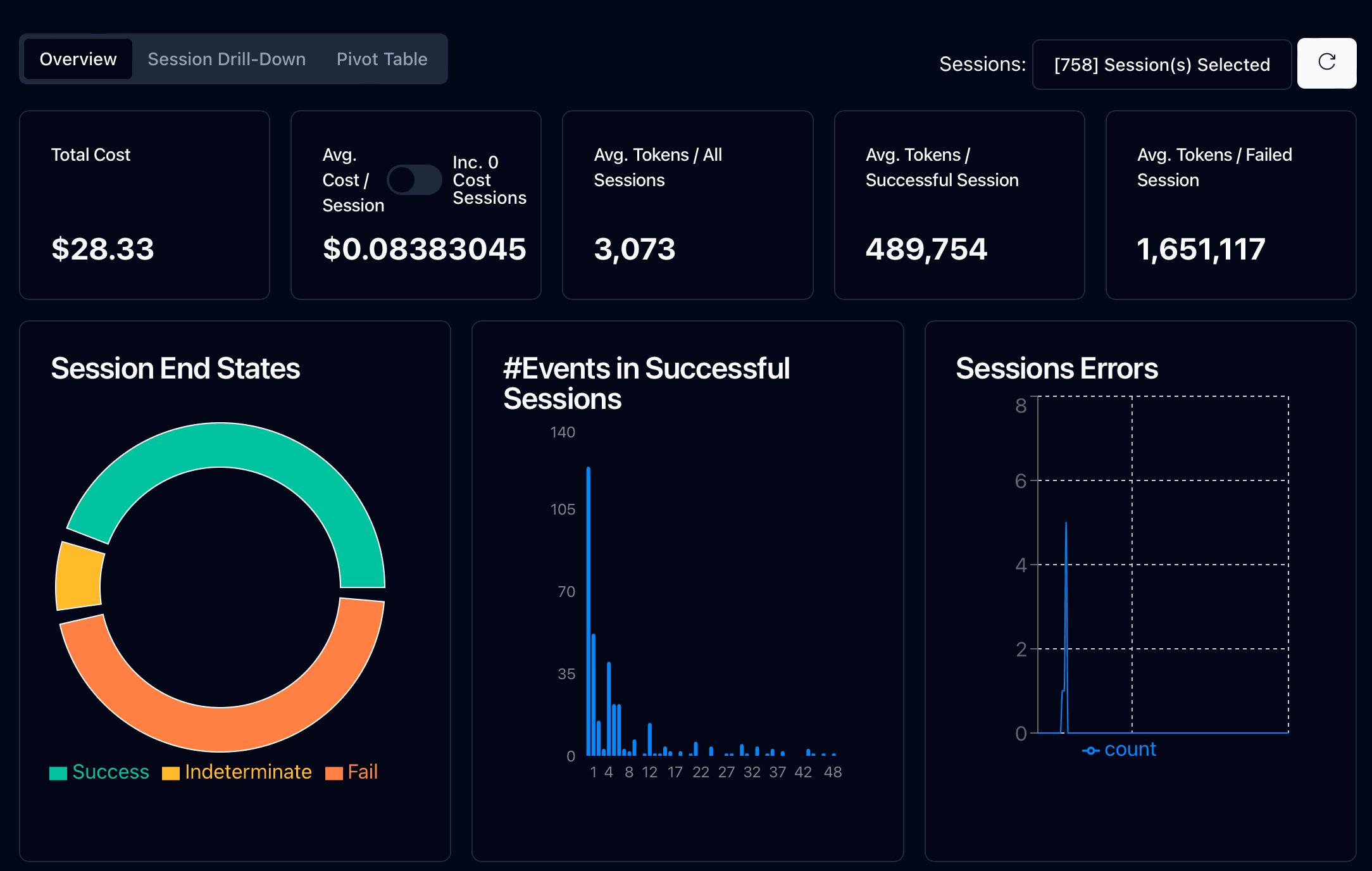

Le tableau de bord analytique pour le suivi des coûts est un autre élément clé de la boîte à outils de gestion des coûts LLM d'AgentOps. Cette interface intuitive présente des statistiques et des mesures de haut niveau sur les agents dans les environnements de développement et de production. Les développeurs peuvent facilement suivre les coûts, le nombre de jetons, la latence et les taux de réussite/d'échec, obtenant ainsi une vue d'ensemble des performances et de l'impact économique de leurs agents d'intelligence artificielle.

L'une des caractéristiques les plus précieuses d'AgentOps est son instrumentation automatique des fournisseurs LLM les plus populaires. Après un simple processus d'initialisation, AgentOps s'intègre de manière transparente avec des fournisseurs comme OpenAI, Cohere et LiteLLM. Cette automatisation réduit considérablement la charge des développeurs, leur permettant de capturer des données détaillées sur les coûts et l'utilisation des appels LLM sans effort supplémentaire. Il en résulte un processus de développement plus rationalisé et un suivi des coûts plus précis.

Analyse détaillée des coûts et optimisation

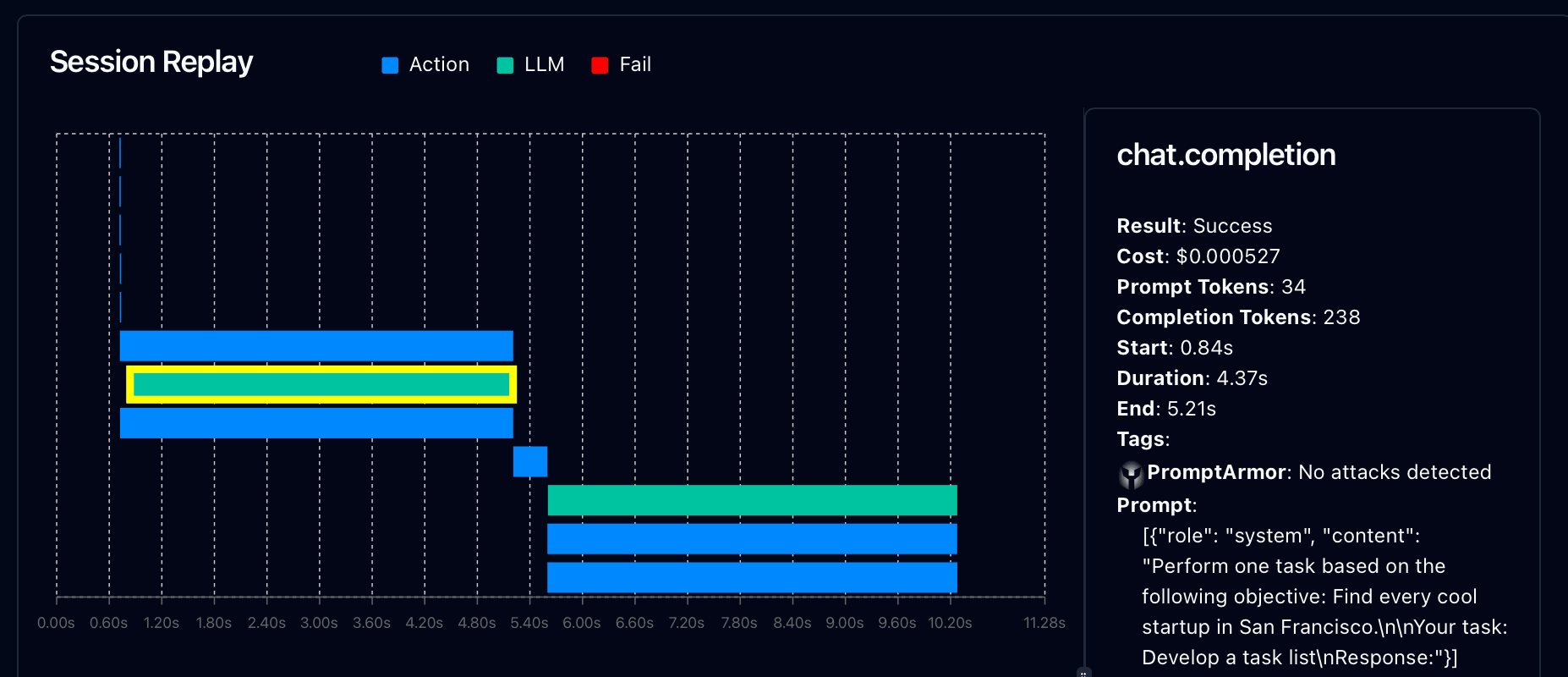

AgentOps va au-delà du suivi des coûts de base en offrant des outils d'analyse approfondie pour l'optimisation. La plateforme fournit des analyses approfondies des sessions et des rediffusions, offrant des informations granulaires sur les coûts de chaque interaction avec un agent d'intelligence artificielle. Les développeurs peuvent examiner étape par étape les détails de l'exécution de l'agent, y compris les invites LLM spécifiques, les achèvements, l'utilisation des jetons et les coûts associés. Ce niveau de détail est inestimable pour identifier les zones d'inefficacité et les opportunités de réduction des coûts.

L'identification des appels LLM inefficaces et des modèles d'utilisation est cruciale pour optimiser les coûts. Les outils d'analyse d'AgentOps aident les développeurs à repérer les cas où les agents d'intelligence artificielle surutilisent les ressources LLM ou effectuent des appels inutiles. En mettant en évidence ces inefficacités, AgentOps permet aux développeurs d'affiner la conception de leurs agents et de leurs messages-guides pour un fonctionnement plus rentable.

AgentOps fournit également des stratégies pour réduire la consommation de jetons, un facteur clé dans la gestion des coûts LLM. La plateforme propose des recommandations basées sur des modèles d'utilisation, suggérant des moyens d'affiner les messages-guides et d'optimiser les interactions avec les agents. Ces stratégies peuvent inclure des techniques pour une ingénierie rapideLa mise en œuvre de ces optimisations permet aux développeurs de réduire considérablement leurs coûts de LLM sans compromettre les performances de l'agent. En mettant en œuvre ces optimisations, les développeurs peuvent réduire de manière significative leurs coûts LLM sans compromettre les performances de l'agent.

Intégration avec les cadres d'agents d'IA

La puissance d'AgentOps dans la gestion des coûts LLM est amplifiée par son intégration transparente avec les cadres d'agents d'IA les plus répandus. Cette intégration permet aux développeurs de surveiller et d'optimiser les coûts dans diverses architectures d'agents sans perturber leurs flux de travail existants.

AgentOps offre des capacités intégrées de contrôle des coûts pour plusieurs cadres clés :

CrewAI : Idéal pour les systèmes multi-agents où l'utilisation de LLM peut rapidement s'accumuler

AutoGen: Permet le suivi des coûts pour les interactions automatisées avec les agents d'IA

LangChain: Offre des informations sur les coûts pour les chaînes et les applications de modèles de langue

Les principaux avantages de l'intégration du cadre d'AgentOps sont les suivants :

Configuration minimale requise pour une visibilité instantanée des coûts du LLM

Suivi des coûts pour tous les agents d'un système ou d'une équipe

Identification d'agents ou d'interactions à forte intensité de ressources

Visibilité inter-cadres pour une meilleure allocation des ressources

Prise de décision éclairée sur le choix du cadre pour des tâches spécifiques

En simplifiant la gestion des coûts entre les différentes architectures d'agents, AgentOps permet aux développeurs de choisir les solutions les plus rentables pour leurs applications d'agents d'IA. Cette intégration est cruciale pour les organisations qui cherchent à optimiser leurs investissements dans l'IA sur différentes plateformes et dans différents cas d'utilisation.

Équilibrer les performances et les coûts dans le développement d'agents d'intelligence artificielle

L'un des aspects les plus difficiles du développement d'agents d'intelligence artificielle est de trouver le bon équilibre entre performance et coût. AgentOps fournit des outils pour aider les développeurs à naviguer dans ce compromis complexe.

AgentOps fournit des informations sur la corrélation entre l'utilisation des jetons et les performances des agents. En analysant cette relation, les développeurs peuvent identifier le point idéal où l'augmentation de l'utilisation des jetons ne produit plus d'améliorations significatives des performances. Cette compréhension est cruciale pour optimiser les agents d'IA afin de fournir une valeur maximale à un coût minimal.

Les tests A/B pour l'optimisation des coûts et des performances sont une autre caractéristique puissante d'AgentOps. Les développeurs peuvent effectuer des tests parallèles avec différentes configurations d'agents, stratégies d'incitation ou choix de modèles afin de déterminer l'approche qui offre le meilleur rapport performance-coût. Cette méthode fondée sur les données élimine l'incertitude de l'optimisation et permet de prendre des décisions fondées sur des preuves dans le cadre du développement d'agents.

La définition et la gestion des seuils budgétaires est un aspect critique de la gestion des coûts LLM qu'AgentOps simplifie. Les développeurs peuvent établir des limites de coûts pour des agents individuels, des projets ou des systèmes d'IA entiers. AgentOps fournit des alertes en temps réel lorsque ces seuils sont approchés ou dépassés, ce qui permet un contrôle proactif des coûts. Cette fonction est particulièrement utile pour les entreprises qui travaillent avec des budgets d'IA fixes ou qui cherchent à étendre progressivement leurs opérations d'IA.

Sécurité et conformité dans la gestion des coûts du LLM

Alors que les agents d'IA traitent des tâches et des données de plus en plus sensibles, la sécurité et la conformité de la gestion des coûts deviennent primordiales. AgentOps répond à ces préoccupations de front, en veillant à ce que le suivi des coûts ne compromette pas la confidentialité des données ou la conformité réglementaire.

Assurer la confidentialité des données dans le suivi des coûts est un principe fondamental d'AgentOps. La plateforme est conçue pour capturer les mesures liées aux coûts sans exposer les informations sensibles contenues dans les invites ou les réponses. Cette séparation permet une gestion complète des coûts sans risque de violation des données ou des politiques de confidentialité.

Pour les entreprises opérant dans des secteurs réglementés, la conformité avec les réglementations financières est cruciale. AgentOps aide à naviguer dans ces exigences complexes en fournissant des pistes d'audit détaillées de l'utilisation du LLM et des coûts associés. Ces enregistrements peuvent s'avérer inestimables pour démontrer que les dépenses d'IA sont responsables et pour adhérer aux normes de reporting financier.

En outre, les fonctionnalités de conformité d'AgentOps s'étendent aux réglementations sur la protection des données telles que GDPR et HIPAA. La plateforme garantit que les processus de suivi et d'optimisation des coûts s'alignent sur ces exigences strictes en matière de traitement des données, ce qui donne aux entreprises la confiance nécessaire pour déployer des agents IA dans des environnements sensibles sans compromettre les capacités de gestion des coûts.

Permettre le développement rentable d'agents d'IA

AgentOps est un outil essentiel dans le paysage évolutif du développement d'agents d'IA, offrant une solution complète pour la gestion des coûts LLM sans compromettre la performance ou la sécurité. En fournissant un suivi des coûts en temps réel, des analyses détaillées et une intégration transparente avec des frameworks populaires tels que CrewAI et AutoGen, AgentOps permet aux développeurs de prendre des décisions éclairées sur l'allocation et l'optimisation des ressources.

La capacité de la plateforme à équilibrer performance et rentabilité, associée à de solides fonctions de sécurité et de conformité, en fait un atout précieux pour les entreprises qui cherchent à exploiter durablement les agents d'IA. Alors que l'IA continue de transformer les industries, AgentOps garantit que les organisations peuvent exploiter le plein potentiel des LLM tout en gardant le contrôle de leurs budgets, ouvrant ainsi la voie à un déploiement d'agents d'IA plus efficace, plus rentable et plus responsable.