10 stratégies éprouvées pour réduire les coûts de votre LLM

Alors que les entreprises s'appuient de plus en plus sur de grands modèles de langage (LLM) pour diverses applications, des chatbots de service client à la génération de contenu, le défi de la gestion des coûts des LLM est devenu primordial. Les coûts opérationnels associés au déploiement et à la maintenance des LLM peuvent rapidement devenir incontrôlables en l'absence d'une surveillance et de stratégies d'optimisation appropriées. Des pics de coûts inattendus peuvent faire dérailler les budgets et entraver l'adoption généralisée de ces outils puissants.

Cet article de blog explore dix stratégies éprouvées pour aider votre entreprise à gérer efficacement les coûts des LLM, vous permettant ainsi d'exploiter tout le potentiel de ces modèles tout en maintenant la rentabilité et le contrôle des dépenses.

- Stratégie 1 : Sélection intelligente du modèle

- Stratégie 2 : mettre en œuvre un suivi rigoureux de l'utilisation

- Stratégie 3 : Optimiser l'ingénierie des messages

- Stratégie 4 : Tirer parti du réglage fin pour la spécialisation

- Stratégie 5 : Explorer les options gratuites et peu coûteuses

- Stratégie 6 : Optimiser la gestion des fenêtres contextuelles

- Stratégie 7 : Mettre en œuvre des systèmes multi-agents

- Stratégie 8 : Utiliser les outils de formatage des sorties

- Stratégie 9 : Intégrer des outils non-LLM

- Stratégie 10 : Audits réguliers et optimisation

- Le bilan

Stratégie 1 : Sélection intelligente du modèle

L'une des stratégies les plus efficaces pour la gestion des coûts du LLM consiste à sélectionner le bon modèle pour chaque tâche. Toutes les applications ne nécessitent pas les modèles les plus avancés et les plus grands disponibles. En adaptant la complexité du modèle aux exigences de la tâche, vous pouvez réduire considérablement les coûts sans sacrifier les performances.

Lors de la mise en œuvre d'applications LLM, il est essentiel d'évaluer la complexité de chaque tâche et de choisir un modèle qui réponde à ces besoins spécifiques. Par exemple, des tâches de classification simples ou des réponses à des questions élémentaires peuvent ne pas nécessiter toutes les capacités de GPT-4o ou d'autres modèles volumineux et gourmands en ressources.

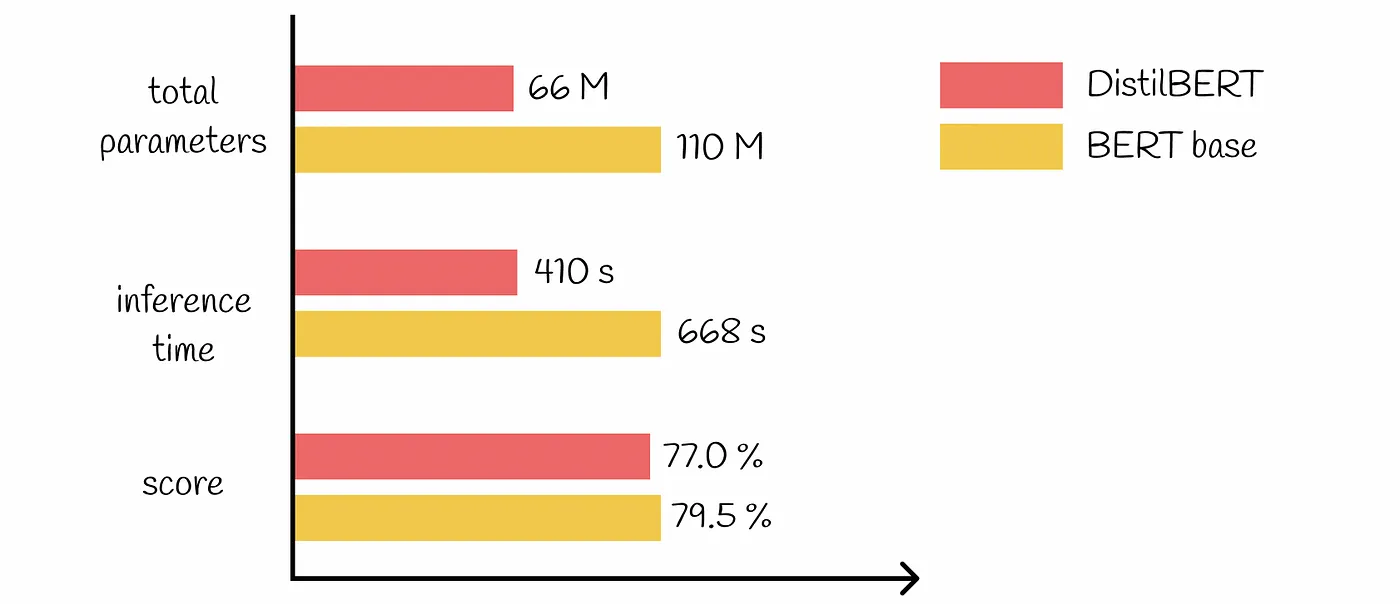

De nombreux modèles pré-entraînés sont disponibles en différentes tailles et complexités. Opter pour des modèles plus petits et plus efficaces pour les tâches simples peut permettre de réaliser des économies substantielles. Par exemple, vous pouvez utiliser un modèle léger tel que DistilBERT pour l'analyse des sentiments au lieu d'un modèle plus complexe tel que BERT-Large.

Stratégie 2 : mettre en œuvre un suivi rigoureux de l'utilisation

Une gestion efficace des coûts du LLM commence par une compréhension claire de la manière dont ces modèles sont utilisés dans votre organisation. La mise en œuvre de mécanismes robustes de suivi de l'utilisation est essentielle pour identifier les domaines d'inefficacité et les possibilités d'optimisation.

Pour obtenir une vue d'ensemble de votre Utilisation du LLMIl est donc essentiel de suivre les indicateurs à plusieurs niveaux :

Niveau de conversation : Surveillez l'utilisation des jetons, les temps de réponse et les appels de modèle pour les interactions individuelles.

Niveau utilisateur : Analyser les schémas d'utilisation des modèles par les différents utilisateurs ou services.

Niveau de l'entreprise : Agréger les données pour comprendre la consommation globale de LLM et les tendances.

Plusieurs outils et plateformes sont disponibles pour aider à suivre efficacement l'utilisation du MLD. Il peut s'agir de

Tableaux de bord analytiques intégrés fournis par les prestataires de services LLM

Outils de surveillance tiers conçus spécifiquement pour les applications d'IA et de ML.

Solutions de suivi sur mesure intégrées à votre infrastructure existante

En analysant les données d'utilisation, vous pouvez découvrir des informations précieuses qui vous permettront de mettre en place des stratégies de réduction des coûts. Par exemple, vous pourriez découvrir que certains départements utilisent de manière excessive des modèles plus coûteux pour des tâches qui pourraient être gérées par des alternatives moins coûteuses. Vous pouvez également identifier des modèles de requêtes redondantes qui pourraient être traités par la mise en cache ou d'autres techniques d'optimisation.

Stratégie 3 : Optimiser l'ingénierie des messages

Ingénierie rapide est un aspect critique du travail avec les LLM et peut avoir un impact significatif sur les performances et les coûts. En optimisant vos invites, vous pouvez réduire l'utilisation de jetons et améliorer l'efficacité de vos applications LLM.

Pour minimiser le nombre d'appels à l'API et réduire les coûts associés :

Utilisez des instructions claires et spécifiques dans vos messages-guides

Mise en œuvre d'une gestion des erreurs pour résoudre les problèmes courants sans nécessiter de requêtes supplémentaires dans le cadre du programme LLM

Utiliser des modèles de messages qui se sont avérés efficaces pour des tâches spécifiques

La façon dont vous structurez vos invites peut affecter de manière significative le nombre de jetons traités par le modèle. Voici quelques bonnes pratiques :

Être concis et éviter les contextes inutiles

Utiliser des techniques de mise en forme comme les puces ou les listes numérotées pour organiser l'information de manière efficace.

Exploiter les fonctions intégrées ou les paramètres fournis par le service LLM pour contrôler la longueur et le format de la sortie

En mettant en œuvre ces techniques d'optimisation rapide, vous pouvez réduire considérablement l'utilisation des jetons et, par conséquent, les coûts associés à vos applications LLM.

Stratégie 4 : Tirer parti du réglage fin pour la spécialisation

Le réglage fin des modèles pré-entraînés pour des tâches spécifiques est une technique puissante de gestion des coûts du LLM. En adaptant les modèles à vos besoins spécifiques, vous pouvez obtenir de meilleures performances avec des modèles plus petits et plus efficaces, ce qui permet de réaliser des économies significatives.

Au lieu de s'appuyer uniquement sur de grands LLM polyvalents, envisagez d'affiner des modèles plus petits pour des tâches spécialisées. Cette approche vous permet d'exploiter les connaissances des modèles pré-entraînés tout en optimisant votre cas d'utilisation spécifique.

Bien que le réglage fin nécessite un investissement initial, il peut conduire à des économies substantielles à long terme. Les modèles affinés nécessitent souvent moins de jetons pour obtenir des résultats identiques ou meilleurs, ce qui réduit les coûts d'inférence. Ils peuvent également nécessiter moins de tentatives ou de corrections en raison de l'amélioration de la précision, ce qui réduit encore les coûts. En outre, les modèles spécialisés sont souvent plus petits, ce qui réduit la charge de calcul et les dépenses associées.

Pour maximiser les avantages de la mise au point, commencez par un petit modèle pré-entraîné comme base. Utilisez des données de haute qualité et spécifiques au domaine pour le réglage fin et évaluez régulièrement les performances et la rentabilité du modèle. Ce processus d'optimisation continue garantit que vos modèles affinés continuent à apporter de la valeur tout en maîtrisant les coûts.

Stratégie 5 : Explorer les options gratuites et peu coûteuses

Pour de nombreuses entreprises, en particulier pendant les phases de développement et d'essai, l'exploitation de la options de LLM gratuites ou à faible coût peuvent réduire considérablement les dépenses sans compromettre la qualité. Ces options sont particulièrement utiles pour le prototypage de nouvelles applications LLM, la formation des développeurs à la mise en œuvre du LLM et l'exécution de services non critiques ou orientés vers l'intérieur.

Toutefois, si les options gratuites permettent de réduire considérablement les coûts, il est essentiel de prendre en compte les compromis. Les implications en matière de confidentialité et de sécurité des données doivent être soigneusement évaluées, en particulier lorsqu'il s'agit d'informations sensibles. En outre, il faut être conscient des limites potentielles des capacités des modèles ou des options de personnalisation. Envisagez l'évolutivité à long terme et les voies de migration pour vous assurer que vos mesures de réduction des coûts ne deviennent pas des obstacles à la croissance future.

Stratégie 6 : Optimiser la gestion des fenêtres contextuelles

La taille de la fenêtre contextuelle dans les LLM peut avoir un impact significatif sur les performances et les coûts. Une gestion efficace des fenêtres contextuelles est essentielle pour contrôler les dépenses tout en maintenant la qualité des résultats. Des fenêtres contextuelles plus grandes permettent une compréhension plus complète, mais ont un coût plus élevé en raison de l'utilisation accrue de jetons par requête et de besoins de calcul plus importants.

Pour optimiser l'utilisation des fenêtres contextuelles, envisagez de mettre en œuvre un dimensionnement dynamique du contexte en fonction de la complexité de la tâche. Utilisez des techniques de résumé pour condenser les informations pertinentes et utilisez des approches de fenêtre coulissante pour les longs documents ou les conversations. Ces méthodes peuvent vous aider à trouver le juste milieu entre compréhension et rentabilité.

Analysez régulièrement la relation entre la taille du contexte et la qualité du résultat afin d'affiner votre approche. Ajustez les fenêtres de contexte en fonction des exigences spécifiques de la tâche et envisagez de mettre en œuvre une approche à plusieurs niveaux, en utilisant des contextes plus importants uniquement lorsque cela est nécessaire. En gérant soigneusement vos fenêtres de contexte, vous pouvez réduire considérablement l'utilisation de jetons et les coûts associés sans sacrifier la qualité de vos résultats LLM.

Stratégie 7 : Mettre en œuvre des systèmes multi-agents

Les systèmes multi-agents offrent une approche puissante pour améliorer l'efficacité et la rentabilité des applications LLM. En répartissant les tâches entre des agents spécialisés, les entreprises peuvent optimiser l'allocation des ressources et réduire les coûts globaux du LLM.

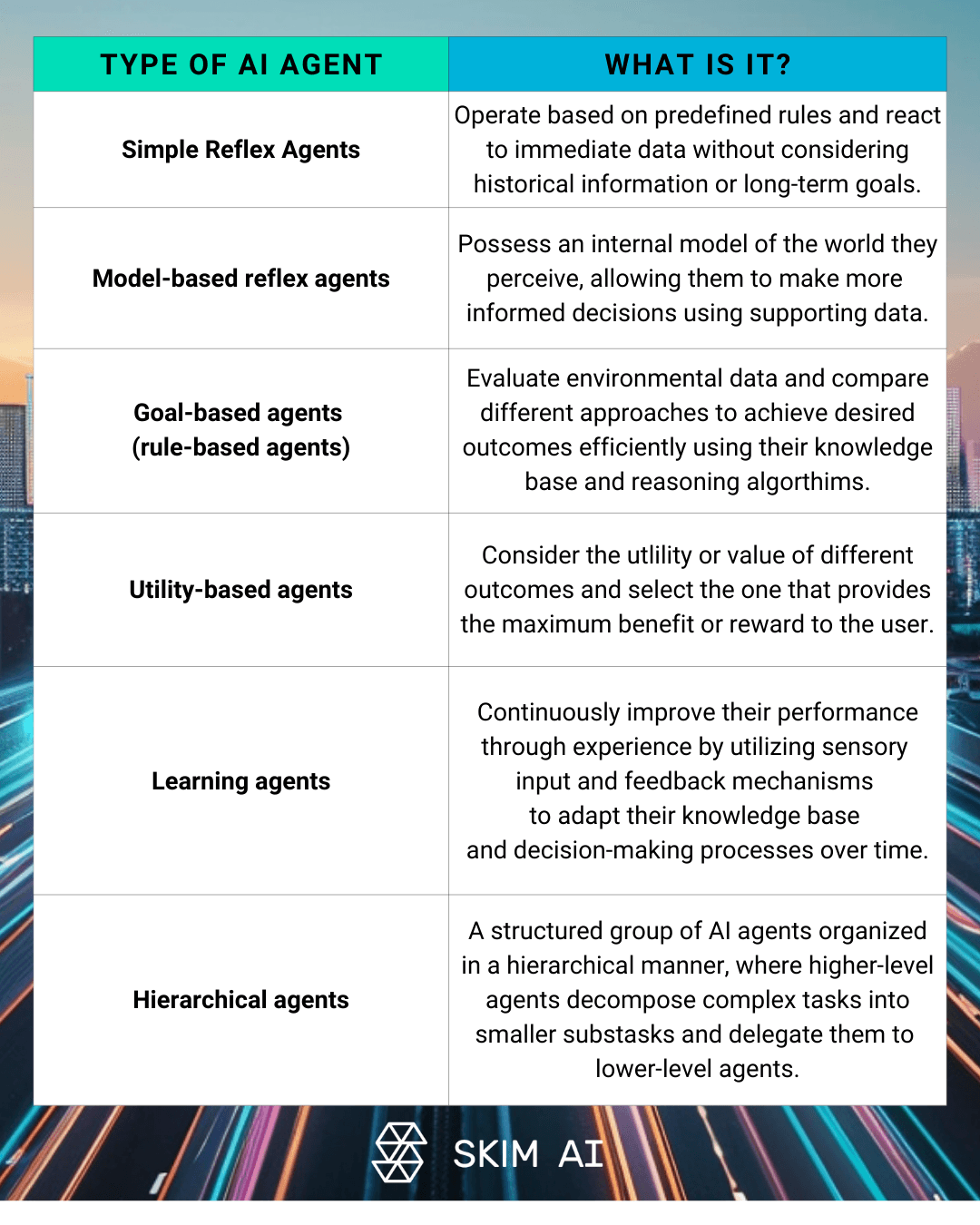

Les architectures LLM multi-agents impliquent plusieurs Agents d'intelligence artificielle travailler en collaboration pour résoudre des problèmes complexes. Cette approche peut inclure des agents spécialisés pour différents aspects d'une tâche, des structures hiérarchiques avec des agents de supervision et des agents travailleurs, ou la résolution collaborative de problèmes entre plusieurs LLM. En mettant en œuvre de tels systèmes, les organisations peuvent réduire leur dépendance à l'égard de modèles coûteux et à grande échelle pour chaque tâche.

Les avantages en termes de coûts de la gestion distribuée des tâches sont considérables. Les systèmes multi-agents permettent :

Optimisation de l'allocation des ressources en fonction de la complexité des tâches

Amélioration de l'efficacité globale du système et des temps de réponse

Réduction de l'utilisation des jetons grâce au déploiement de modèles ciblés

Toutefois, pour maintenir la rentabilité des systèmes multi-agents, il est essentiel de mettre en œuvre des mécanismes de débogage robustes. Il s'agit notamment d'enregistrer et de surveiller les communications entre agents, d'analyser les schémas d'utilisation des jetons afin d'identifier les échanges redondants et d'optimiser la répartition du travail entre les agents afin de minimiser la consommation inutile de jetons.

Stratégie 8 : Utiliser les outils de formatage des sorties

Le formatage correct des sorties est un facteur clé de la gestion des coûts du LLM. En garantissant une utilisation efficace des jetons et en minimisant la nécessité d'un traitement supplémentaire, les entreprises peuvent réduire de manière significative leurs coûts opérationnels.

Ces outils offrent des capacités puissantes pour les sorties de fonctions forcées, permettant aux développeurs de spécifier des formats exacts pour les réponses LLM. Cette approche réduit la variabilité des sorties et minimise le gaspillage de jetons en s'assurant que le modèle ne génère que les informations nécessaires.

La réduction de la variabilité des résultats du LLM a un impact direct sur les coûts associés. Des réponses cohérentes et bien structurées réduisent la probabilité de résultats malformés ou inutilisables, ce qui, à son tour, réduit la nécessité d'appels supplémentaires à l'API pour clarifier ou reformater les informations.

La mise en œuvre de sorties JSON peut s'avérer particulièrement efficace. JSON offre une représentation compacte des données structurées, une analyse et une intégration faciles avec différents systèmes, et une utilisation réduite des jetons par rapport aux réponses en langage naturel. En tirant parti de ces outils de formatage de sortie, les entreprises peuvent rationaliser leurs flux de travail LLM et optimiser l'utilisation des jetons.

Stratégie 9 : Intégrer des outils non-LLM

Si les LLM sont puissants, ils ne constituent pas toujours la solution la plus rentable pour chaque tâche. L'intégration d'outils nonOutils LLM dans vos flux de travail peut réduire de manière significative les coûts opérationnels tout en maintenant des résultats de haute qualité.

L'incorporation de scripts Python pour traiter des tâches spécifiques qui ne nécessitent pas les capacités complètes d'un LLM peut entraîner des économies substantielles. Par exemple, le traitement de données simples ou la prise de décision basée sur des règles peuvent souvent être traités plus efficacement par des approches de programmation traditionnelles.

Lors de l'équilibrage du LLM et des outils traditionnels dans les flux de travail, il faut tenir compte de la complexité de la tâche, de la précision requise et des économies potentielles. Une approche hybride qui exploite les forces des LLM et des outils conventionnels donne souvent les meilleurs résultats en termes de performance et de rentabilité.

Il est essentiel de procéder à une analyse approfondie des coûts et des avantages des approches hybrides. Cette analyse doit prendre en compte des facteurs tels que

Coûts de développement et de maintenance des outils personnalisés

Temps de traitement et ressources nécessaires

Précision et fiabilité des résultats

Évolutivité et flexibilité à long terme

Stratégie 10 : Audits réguliers et optimisation

La mise en place de techniques de gestion des coûts du LLM est un processus continu qui nécessite une vigilance et une optimisation constantes. Un audit régulier de l'utilisation et des coûts du LLM est essentiel pour identifier les inefficacités et mettre en œuvre des améliorations pour le contrôle des coûts.

On ne saurait trop insister sur l'importance d'une gestion et d'une réduction continues des coûts. Au fur et à mesure que vos applications LLM évoluent et s'étendent, de nouveaux défis et de nouvelles opportunités d'optimisation apparaissent. En surveillant et en analysant constamment votre utilisation du LLM, vous pouvez éviter les dépassements de coûts potentiels et vous assurer que vos investissements dans l'IA apportent une valeur maximale.

Pour identifier les jetons gaspillés, mettez en œuvre des outils de suivi et d'analyse robustes. Recherchez des modèles de requêtes redondantes, des fenêtres contextuelles excessives ou des conceptions d'invite inefficaces. Utilisez ces données pour affiner vos stratégies LLM et éliminer la consommation inutile de jetons.

Enfin, la promotion d'une culture de sensibilisation aux coûts au sein de votre organisation est la clé d'un succès à long terme dans la gestion efficace des ressources LLM. Encouragez les équipes à prendre en compte les implications financières de leur utilisation du LLM et à rechercher activement des opportunités d'optimisation et de contrôle des dépenses. En faisant de la rentabilité une responsabilité partagée, vous pouvez vous assurer que votre entreprise profite pleinement des avantages de la technologie LLM tout en gardant les dépenses sous contrôle.

Le bilan

Alors que les grands modèles de langage continuent d'avoir un impact sur les applications d'IA d'entreprise, la maîtrise de la gestion des coûts LLM devient cruciale pour le succès à long terme. En mettant en œuvre les dix stratégies décrites dans cet article, de la sélection intelligente des modèles à l'audit et à l'optimisation réguliers, votre organisation peut réduire considérablement les coûts des LLM tout en maintenant, voire en améliorant, les performances. N'oubliez pas qu'une gestion efficace des coûts est un processus continu qui nécessite un contrôle, une analyse et une adaptation permanents. En encourageant une culture de prise en compte des coûts et en utilisant les bons outils et techniques, vous pouvez exploiter tout le potentiel des LLM tout en gardant les coûts opérationnels sous contrôle, garantissant ainsi que vos investissements dans l'IA apportent une valeur maximale à votre entreprise.

N'hésitez pas à nous contacter pour en savoir plus sur le LLM en gestion des coûts.