Unser 4-Tool-Stack + Strategie für den Aufbau von Unternehmensanwendungen auf LLMs - AI&YOU#53

Statistik/Fakten der Woche: Der globale LLM-Markt wird voraussichtlich von $1,59 Mrd. im Jahr 2023 auf $259,8 Mrd. im Jahr 2030 wachsen, was einer CAGR von 79,8% im Zeitraum 2023-2030 entspricht (Quellen)

Große Sprachmodelle (LLMs) haben sich als Schlüssel zum Aufbau intelligenter Unternehmensanwendungen erwiesen. Um die Leistungsfähigkeit dieser Sprachmodelle zu nutzen, ist jedoch ein robuster und effizienter LLM-Anwendungsstack erforderlich.

Mit unserem LLM-App-Stack können wir bei Skim AI leistungsstarke Anwendungen mit fortschrittlichen Funktionen zur Interaktion mit natürlicher Sprache erstellen. Unser Stack umfasst sorgfältig ausgewählte Tools und Frameworks, wie LLM-APIs, LangChain und Vektordatenbanken.

In dieser Ausgabe von AI&YOU stellen wir in unseren Blogs unser 4-Tool-Stack und unsere Strategie für die Entwicklung von LLM-Anwendungen für Unternehmen vor:

Wie Sie Ihren LLM-App-Stack mit diesen 4 Tools und Frameworks aufbauen

Die 5 besten LLM-API-Integrationsstrategien für Ihr Unternehmen

- Unser 4-Tool-Stack und unsere Strategie für die Entwicklung von Unternehmensanwendungen auf LLMs - AI&YOU #53

- Werkzeug 1: Eine LLM-API wie GPT, Claude, Llama oder Mistral

- Faktoren, die bei der Auswahl eines LLM-API zu berücksichtigen sind

- Werkzeug 2: LangChain

- LangChain's verschiedene Tools und Unterstützung

- Werkzeug 3: Eine Vektordatenbank wie Chroma

- Integration von Chroma in Ihren LLM-Stack für Unternehmen

- Werkzeug 4: crewAI für Multi-Agenten-Systeme

- Die Macht der Spezialisierung nutzen

- Entfaltung der Leistungsfähigkeit von LLMs mit dem richtigen Anwendungsstack

- Die 5 besten LLM-API-Integrationsstrategien für Ihr Unternehmen

- Die 5 besten Open Source LLMs für Ihr Unternehmen

Unser 4-Tool-Stack und unsere Strategie für die Entwicklung von Unternehmensanwendungen auf LLMs - AI&YOU #53

Mit unserem LLM-Stack für Unternehmen können Entwickler nahtlos integrieren Domänenspezifische Daten, Feinabstimmung von Modellen, Erstellung effizienter Datenpipelines für den Abruf kontextbezogener Daten und vieles mehr.

Dies ermöglicht es Unternehmen, Anwendungen zu entwickeln, die Benutzeranfragen mit beispielloser Genauigkeit und Kontextwissen verstehen und beantworten.

Gleichzeitig besteht eine der wichtigsten Techniken, die mit diesem Stack einhergehen, darin, die vorhandenen Tools und Frameworks zu nutzen, die von den verschiedenen Komponenten bereitgestellt werden. Dadurch können sich die Entwickler auf die Erstellung von Anwendungen konzentrieren, anstatt Tools von Grund auf neu zu entwickeln, was wertvolle Zeit und Mühe spart.

Werkzeug 1: Eine LLM-API wie GPT, Claude, Llama oder Mistral

Das Herzstück Ihres LLM-Anwendungsstacks sollte eine LLM-API sein. LLM-APIs bieten eine Möglichkeit, leistungsstarke Sprachmodelle in Ihre Anwendungen zu integrieren, ohne dass Sie die Modelle selbst trainieren oder hosten müssen. Sie fungieren als Brücke zwischen Ihrer Software und den komplexen Algorithmen, die Sprachmodelle antreiben, und ermöglichen es Ihnen, Ihren Anwendungen mit minimalem Aufwand fortschrittliche Funktionen zur Verarbeitung natürlicher Sprache hinzuzufügen.

Einer der Hauptvorteile der Verwendung einer LLM-API ist die Möglichkeit, hochmoderne Sprachmodelle zu nutzen, die anhand großer Datenmengen trainiert wurden. Diese Modelle, wie z. B. GPT, Claude, Mistralund Lamasind in der Lage, menschenähnliche Texte mit bemerkenswerter Genauigkeit und Geläufigkeit zu verstehen und zu erzeugen.

Durch API-Aufrufe zu diesen Modellen können Sie Ihren Anwendungen schnell eine breite Palette von Funktionen hinzufügen, z. B. Texterstellung, Stimmungsanalyse, Fragenbeantwortung und vieles mehr.

Faktoren, die bei der Auswahl eines LLM-API zu berücksichtigen sind

Bei der Auswahl einer LLM-API für Ihren Stack gibt es mehrere Faktoren zu berücksichtigen:

Leistung und Genauigkeit: Vergewissern Sie sich, dass die API Ihr Arbeitsaufkommen bewältigen und zuverlässige Ergebnisse liefern kann.

Anpassungsfähigkeit und Flexibilität: Überlegen Sie, ob Sie das Modell auf Ihren speziellen Anwendungsfall abstimmen oder es in andere Komponenten Ihres Stacks integrieren müssen.

Skalierbarkeit: Wenn Sie mit einem hohen Anfragevolumen rechnen, sollten Sie sicherstellen, dass die API entsprechend skaliert werden kann.

Unterstützung und Gemeinschaft: Beurteilen Sie den Grad der Unterstützung und die Größe der Community rund um die API, da dies die langfristige Lebensfähigkeit Ihrer Anwendung beeinflussen kann.

Das Herzstück der meisten LLM-APIs sind tiefe neuronale Netze, die in der Regel auf Transformer-Architekturen basieren und auf großen Mengen von Textdaten trainiert werden. Der Zugriff auf diese Modelle erfolgt über eine API-Schnittstelle, die Aufgaben wie Authentifizierung, Anfragerouting und Antwortformatierung übernimmt. LLM-APIs enthalten häufig auch zusätzliche Komponenten für die Datenverarbeitung, wie Tokenisierung und Normalisierung, sowie Tools für die Feinabstimmung und Anpassung.

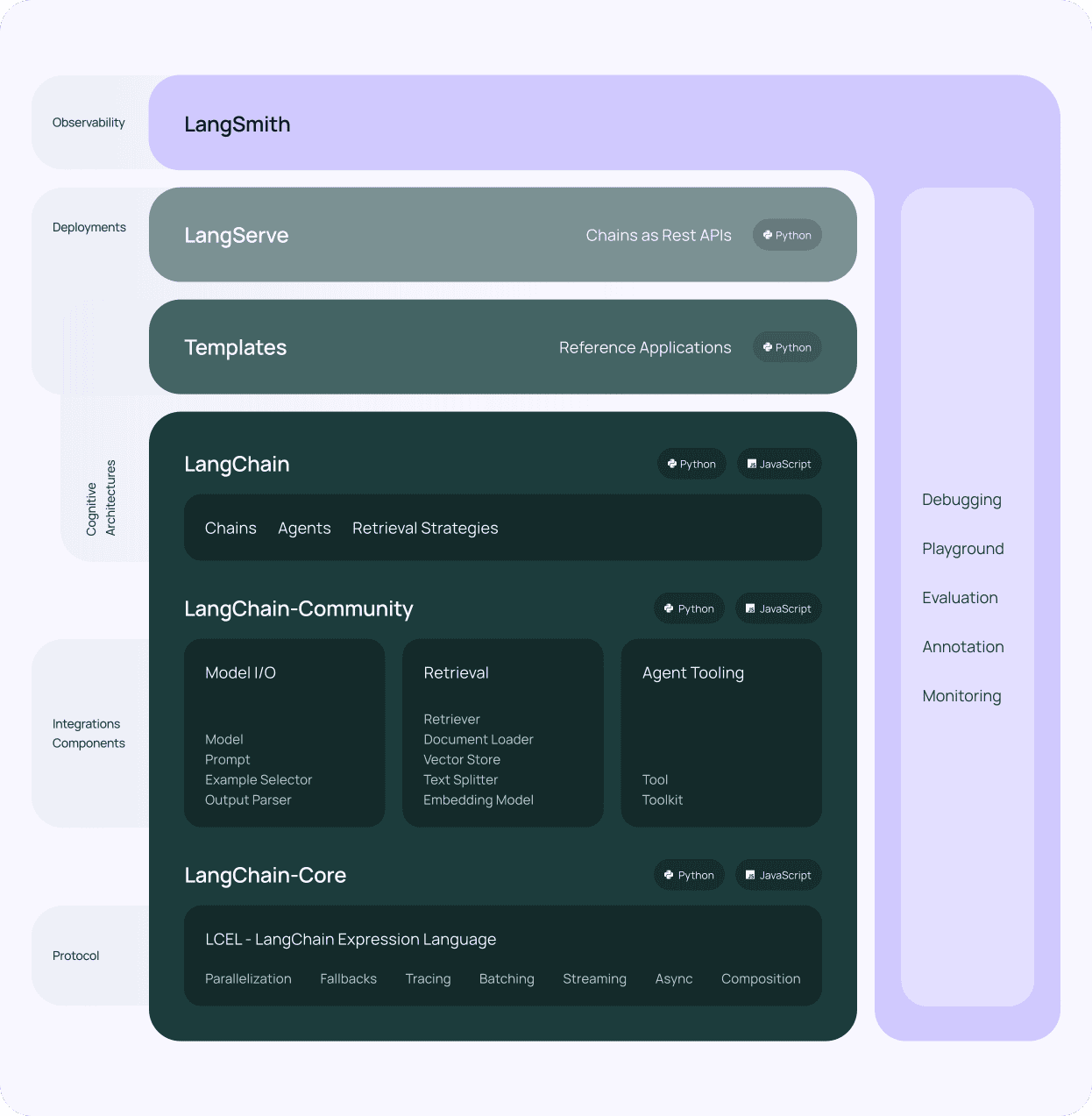

Werkzeug 2: LangChain

Nach der Auswahl einer LLM-API für Ihren LLM-Anwendungsstapel ist die nächste zu berücksichtigende Komponente LangChain. LangChain ist ein leistungsfähiges Framework, das entwickelt wurde, um den Prozess der Erstellung von Anwendungen auf der Grundlage von großen Sprachmodellen zu vereinfachen. Es bietet eine standardisierte Schnittstelle für die Interaktion mit verschiedenen LLM-APIs, was die Integration in Ihren LLM-Technologiestapel erleichtert.

Einer der Hauptvorteile von LangChain ist seine modulare Architektur. LangChain besteht aus mehreren Komponenten, wie Prompts, Ketten, Agenten und Speicher, die kombiniert werden können, um komplexe Workflows zu erstellen. Diese Modularität ermöglicht es Ihnen, Anwendungen zu erstellen, die eine breite Palette von Aufgaben bewältigen können, von der einfachen Beantwortung von Fragen bis hin zu fortgeschrittenen Anwendungsfällen wie der Generierung von Inhalten und der Datenanalyse, die eine natürlichsprachliche Interaktion mit Ihren domänenspezifischen Daten ermöglichen.

LangChain's verschiedene Tools und Unterstützung

LangChain bietet auch eine Reihe von Tools und Dienstprogrammen, die die Arbeit mit LLMs vereinfachen. Zum Beispiel bietet es Werkzeuge für die Arbeit mit Einbettungen, die numerische Darstellungen von Text sind, die für Aufgaben wie semantische Suche und Clustering verwendet werden. Darüber hinaus enthält LangChain Dienstprogramme für die Verwaltung von Prompts, d. h. von Eingabezeichenfolgen, die das Verhalten von Sprachmodellen steuern.

Ein weiteres wichtiges Merkmal von LangChain ist die Unterstützung von Vektordatenbanken. Durch die Integration mit Vektordatenbanken wie Chroma (die wir verwenden), ermöglicht LangChain die Erstellung von Anwendungen, die große Datenmengen effizient speichern und abrufen können. Diese Integration ermöglicht es Ihnen, wissensintensive Anwendungen zu erstellen, die auf eine breite Palette von Informationsquellen zurückgreifen können, wodurch die Abfrage von kontextbezogenen Daten für Ihren LLM-App-Stack verbessert wird.

LangChain ist ein wesentlicher Bestandteil jeder Unternehmen LLM Anwendungsstapel. Der modulare Aufbau, die leistungsstarken Tools und die aktive Community machen es zu einem unverzichtbaren Werkzeug für die Entwicklung anspruchsvoller sprachbasierter Anwendungen.

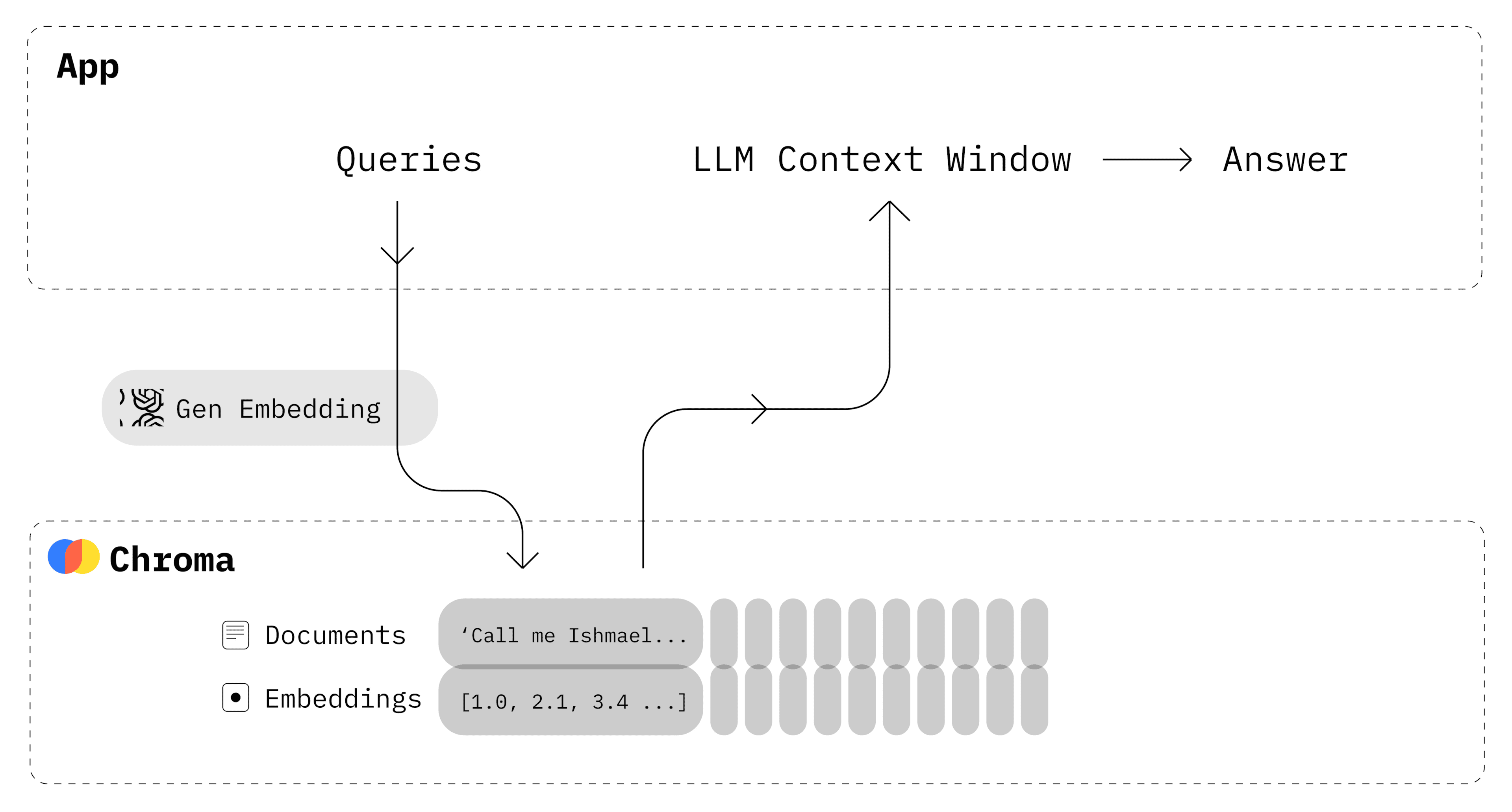

Werkzeug 3: Eine Vektordatenbank wie Chroma

Neben einer LLM-API und LangChain ist eine Vektordatenbank eine weitere wesentliche Komponente Ihres LLM-App-Stacks. Vektordatenbanken sind spezialisierte Datenspeicher, die für die Speicherung und Suche von hochdimensionalen Vektoren optimiert sind, wie z. B. Einbettungen, die von großen Sprachmodellen erzeugt werden. Durch die Integration einer Vektordatenbank in Ihren LLM-Tech-Stack können Sie eine schnelle, effiziente Suche nach relevanten Daten auf der Grundlage semantischer Ähnlichkeit ermöglichen.

Chroma ist eine beliebte Open-Source-Wahl für eine Vektordatenbank in LLM-Anwendungsstacks, und wir verwenden sie hier bei Skim AI. Sie ist so konzipiert, dass sie nahtlos mit LangChain und anderen Komponenten Ihres Stacks zusammenarbeitet und eine robuste und skalierbare Lösung zum Speichern und Abrufen von Einbettungen bietet.

Einer der Hauptvorteile von Chroma ist seine Fähigkeit, große Datenmengen effizient zu verarbeiten. Chroma verwendet fortschrittliche Indizierungstechniken, um eine schnelle Ähnlichkeitssuche auch in großen Datenmengen zu ermöglichen. Dies macht es zu einer idealen Wahl für Anwendungen, die große Mengen an Textdaten speichern und durchsuchen müssen, wie z. B. Dokumenten-Repositories, Wissensdatenbanken und Content-Management-Systeme.

Chroma bietet auch erweiterte Funktionen wie Filterung und Unterstützung von Metadaten. Sie können neben Ihren Einbettungen zusätzliche Metadaten speichern, z. B. Dokument-IDs, Zeitstempel oder benutzerdefinierte Attribute. Diese Metadaten können zum Filtern von Suchergebnissen verwendet werden und ermöglichen einen präziseren und gezielteren Abruf von kontextbezogenen Daten.

Integration von Chroma in Ihren LLM-Stack für Unternehmen

Die Integration von Chroma in Ihren LLM-App-Stack ist dank der Kompatibilität mit LangChain und anderen gängigen Tools und Frameworks unkompliziert. LangChain bietet eine integrierte Unterstützung für Chroma, die es einfach macht, von Ihren Sprachmodellen generierte Einbettungen zu speichern und abzurufen. Diese Integration ermöglicht es Ihnen, leistungsstarke Suchmechanismen zu entwickeln, mit denen Sie schnell relevante Informationen auf der Grundlage der Interaktion mit natürlicher Sprache anzeigen können.

Die Verwendung einer Vektordatenbank wie Chroma in Verbindung mit LLMs eröffnet neue Möglichkeiten für die Entwicklung intelligenter, kontextbezogener Anwendungen. Indem Sie die Leistungsfähigkeit von Einbettungen und Ähnlichkeitssuche nutzen, können Sie Anwendungen erstellen, die Benutzeranfragen mit beispielloser Genauigkeit und Relevanz verstehen und darauf reagieren können.

In Kombination mit LangChain und einer LLM-API bildet Chroma eine leistungsstarke Grundlage für den Aufbau intelligenter, datengesteuerter Anwendungen, die die Art und Weise verändern können, wie wir mit Unternehmensdaten und domänenspezifischen Informationen interagieren.

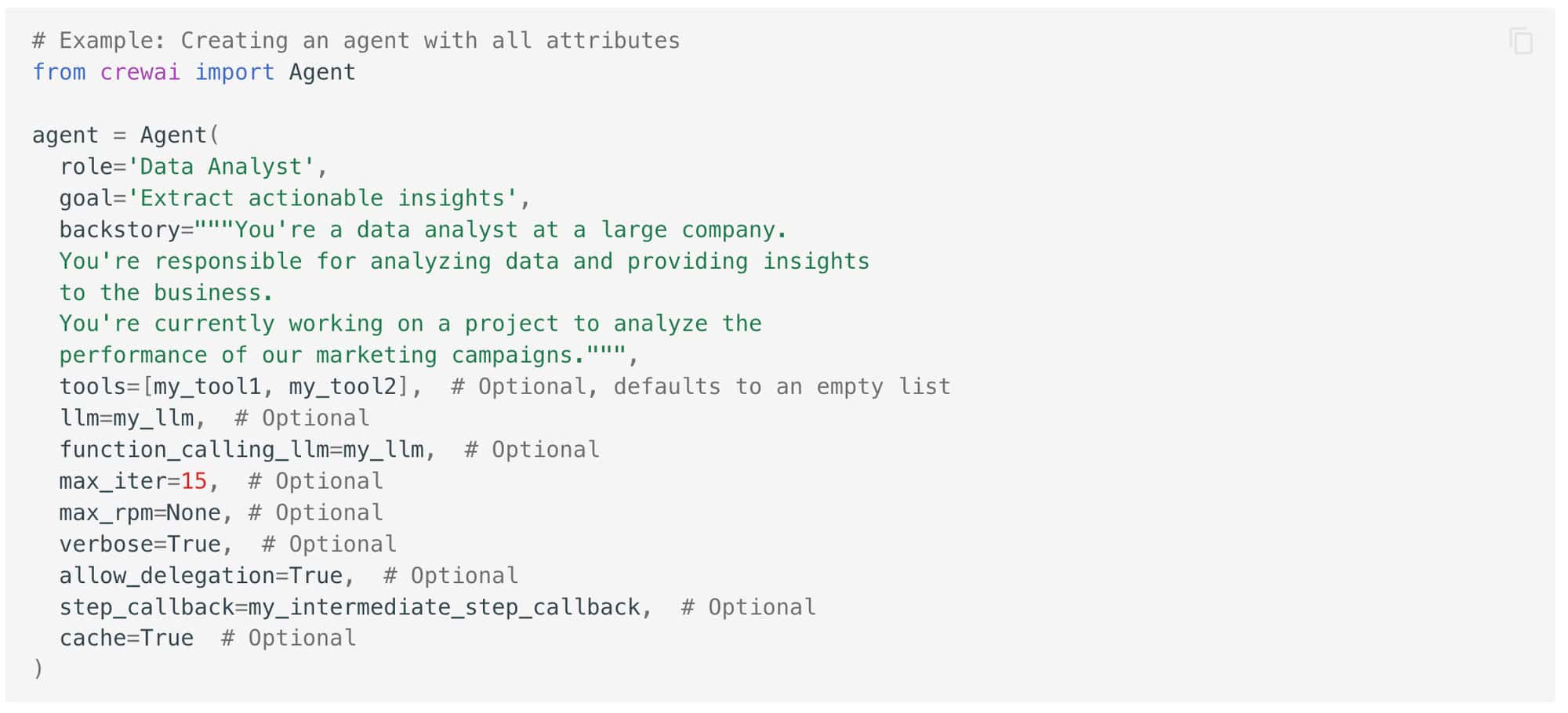

Werkzeug 4: crewAI für Multi-Agenten-Systeme

Wir bei Skim AI wissen, dass die Zukunft der KI-Workflows agentenbasiert ist. Deshalb ist ein Multi-Agenten-System heute für jedes Unternehmen wichtig.

crewAI ist ein weiteres leistungsstarkes Tool, das Sie Ihrem LLM-App-Stack hinzufügen können, um die Fähigkeiten Ihrer Anwendungen zu verbessern. crewAI ist ein Framework, mit dem Sie Multi-Agenten-Systeme erstellen können, in denen mehrere KI-Agenten zusammenarbeiten, um komplexe Aufgaben zu bewältigen.

Im Kern ist crewAI darauf ausgelegt, die Zusammenarbeit zwischen mehreren KI-Agenten zu erleichtern, von denen jeder seine eigene spezifische Rolle und Expertise hat. Diese Agenten können miteinander kommunizieren und sich abstimmen, um komplexe Probleme in kleinere, besser zu bewältigende Teilaufgaben zu zerlegen.

Die Macht der Spezialisierung nutzen

Einer der Hauptvorteile der Verwendung von crewAI in Ihrem LLM-Tech-Stack ist die Fähigkeit, die Macht der Spezialisierung zu nutzen. Indem Sie verschiedenen Agenten spezifische Rollen und Aufgaben zuweisen, können Sie ein System schaffen, das effizienter und effektiver ist als ein einzelnes, monolithisches KI-Modell. Jeder Agent kann für seine spezielle Aufgabe trainiert und optimiert werden, so dass er auf einem höheren Niveau arbeitet als ein Allzweckmodell und eine gezieltere Abfrage von Kontextdaten aus Ihren domänenspezifischen Datensätzen ermöglicht.

Die Verwendung von crewAI in Kombination mit anderen Komponenten Ihres LLM-Tech-Stacks kann Ihnen helfen, neue Möglichkeiten für den Aufbau intelligenter Multi-Agenten-Systeme zu erschließen, die komplexe Aufgaben in der realen Welt bewältigen können. Indem Sie die Kraft der Spezialisierung und Zusammenarbeit nutzen, können Sie Anwendungen erstellen, die effizienter, effektiver und benutzerfreundlicher sind als herkömmliche Einzelmodellansätze.

Entfaltung der Leistungsfähigkeit von LLMs mit dem richtigen Anwendungsstack

Dieser Stack ermöglicht Ihnen die nahtlose Integration domänenspezifischer Daten, die effiziente Abfrage kontextbezogener Informationen und die Erstellung anspruchsvoller Workflows, mit denen Sie komplexe reale Herausforderungen bewältigen können. Indem Sie die Leistungsfähigkeit dieser Tools und Frameworks nutzen, können Sie die Grenzen dessen, was mit sprachbasierten KI-Anwendungen möglich ist, verschieben und wirklich intelligente Systeme schaffen, die die Art und Weise, wie Ihr Unternehmen mit Daten und Technologie interagiert, verändern können.

Die 5 besten LLM-API-Integrationsstrategien für Ihr Unternehmen

In dieser Woche haben wir auch die 5 besten LLM-API-Integrationsstrategien für Ihr Unternehmen untersucht.

Von der modularen Integration bis zur kontinuierlichen Überwachung und Optimierung sind diese Strategien darauf ausgerichtet, eine reibungslose Implementierung, optimale Leistung und langfristigen Erfolg zu gewährleisten.

Modulare Integration beinhaltet die Aufteilung des LLM-API-Integrationsprozesses in kleinere, überschaubare Module, die schrittweise implementiert werden können. Dieser Ansatz ermöglicht eine schrittweise Implementierung, eine einfachere Fehlerbehebung und flexiblere Aktualisierungen und Erweiterungen.

Eine API-Gateway fungiert als zentraler Einstiegspunkt für alle API-Anfragen und verwaltet die Authentifizierung, die Ratenbegrenzung und die Weiterleitung von Anfragen. Es bietet eine zentralisierte Authentifizierung, Ratenbegrenzung und wertvolle Einblicke in die API-Nutzung und -Leistung.

Microservices-Architektur beinhaltet die Aufteilung einer monolithischen Anwendung in kleinere, lose gekoppelte Dienste, die unabhängig voneinander entwickelt, bereitgestellt und skaliert werden können. Dies ermöglicht eine unabhängige Entwicklung, eine granulare Skalierbarkeit sowie eine erhöhte Agilität und Flexibilität.

Anpassung und Feinabstimmung der LLM-APIs beinhaltet die Anpassung an die Anforderungen bestimmter Branchen, Bereiche oder Anwendungen. Dies verbessert die Genauigkeit und Relevanz der Ergebnisse und ermöglicht die Anpassung an Terminologie, Stile und Formate.

Kontinuierliche Überwachung und Optimierung beinhalten die Verfolgung von Leistungsmetriken, die Bewertung der Qualität/Relevanz der Ergebnisse und die Durchführung iterativer Verbesserungen. Dies ermöglicht die proaktive Identifizierung von Problemen, die Anpassung an sich ändernde Anforderungen und die kontinuierliche Verbesserung des Wertes von LLM-API-Integrationen.

Unternehmen, die in robuste, skalierbare und anpassungsfähige Integrationsstrategien investieren, werden gut positioniert sein, um das volle Potenzial dieser transformativen Tools auszuschöpfen, denn die LLM-Technologie entwickelt sich rasant weiter.

Die 5 besten Open Source LLMs für Ihr Unternehmen

Open-Source große Sprachmodelle (LLMs) haben sich als eine leistungsfähiges Werkzeug für Unternehmen im Jahr 2024.

Einer der Hauptvorteile der Verwendung von Open-Source-LLMs ist die Flexibilität und Anpassungsfähigkeit, die sie bieten. Darüber hinaus bieten Open-Source-LLMs eine kostengünstige Alternative zur Entwicklung und Pflege proprietärer Modelle. Durch die Nutzung der kollektiven Bemühungen der KI-Gemeinschaft können Unternehmen auf modernste Sprachmodelle zugreifen, ohne umfangreiche Investitionen in Forschung und Entwicklung tätigen zu müssen.

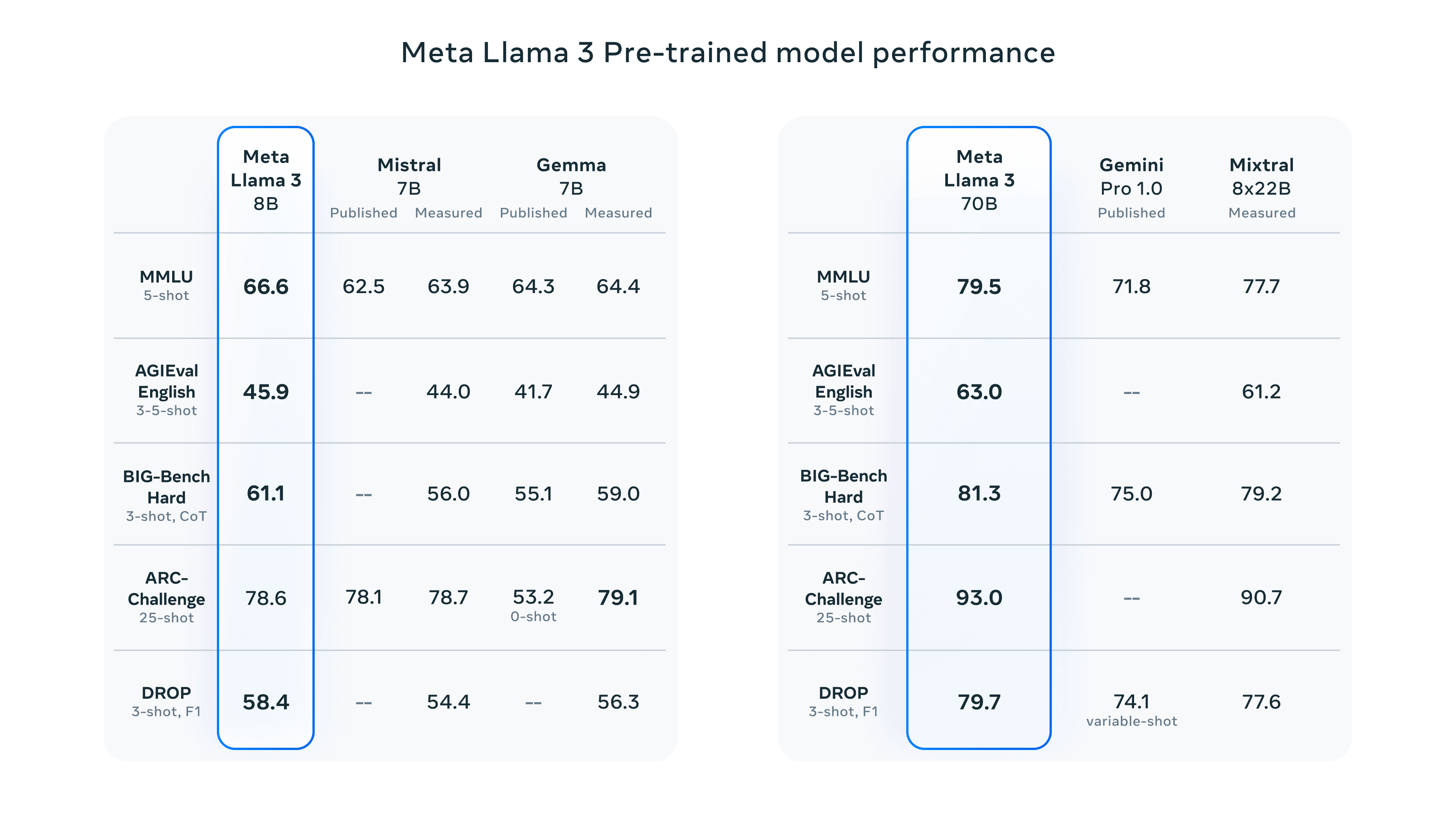

Llama 3 von Meta: Llama 3 ist ein hochmodernes Open-Source-Sprachmodell mit zwei Größenvarianten (8B und 70B Parameter), die jeweils Base- und Instruct-Modelle bieten. Es eignet sich hervorragend für verschiedene NLP-Aufgaben, ist einsatzfreundlich und hält sich an verantwortungsvolle KI-Praktiken.

Claude 3 von Anthropic: Claude 3 gibt es in drei Varianten (Haiku, Sonnet, Opus), die für verschiedene Anwendungsfälle optimiert sind. Es zeigt eine beeindruckende Leistung bei kognitiven Aufgaben wie logischem Denken, Expertenwissen und flüssiger Sprache und übertrifft Modelle wie GPT-4.

Grok von xAI: Grok, entwickelt von Elon Musks xAI, ist auf die Zusammenfassung und das Verstehen von Texten spezialisiert. Die neueste Version, Grok-1.5, bietet langes Kontextverständnis, fortgeschrittene Schlussfolgerungen und starke Codier-/Mathe-Fähigkeiten.

BERT von Google: BERT ist ein Pionier im Bereich des bidirektionalen Sprachverständnisses und eignet sich hervorragend für Aufgaben wie Textklassifizierung, Stimmungsanalyse und Beantwortung von Fragen. Durch sein Vortraining kann es menschenähnlichen Text generieren und kontextrelevante Antworten geben.

Mistral Large von Mistral AI: Mistral Large, mit 314B Parametern, glänzt bei komplexen Denkaufgaben und speziellen Anwendungen. Er bietet mehrsprachige Unterstützung, das Befolgen von Anweisungen und das Aufrufen von Funktionen, was seine Vielseitigkeit erhöht.

Da die Open-Source-KI-Gemeinschaft die Grenzen dessen, was mit Sprachmodellen möglich ist, immer weiter verschiebt, werden Unternehmen, die diese leistungsstarken Tools nutzen, gut positioniert sein, um der Zeit voraus zu sein und langfristig erfolgreich zu sein.

Für noch mehr Inhalte zum Thema KI für Unternehmen, einschließlich Infografiken, Statistiken, Anleitungen, Artikeln und Videos, folgen Sie Skim AI auf LinkedIn

Sie sind Gründer, CEO, Risikokapitalgeber oder Investor und suchen nach fachkundiger KI-Beratung oder Due-Diligence-Dienstleistungen? Holen Sie sich die Beratung, die Sie brauchen, um fundierte Entscheidungen über die KI-Produktstrategie Ihres Unternehmens oder Investitionsmöglichkeiten zu treffen.

Wir entwickeln maßgeschneiderte KI-Lösungen für von Venture Capital und Private Equity unterstützte Unternehmen in den folgenden Branchen: Medizintechnik, Nachrichten/Content-Aggregation, Film- und Fotoproduktion, Bildungstechnologie, Rechtstechnologie, Fintech und Kryptowährungen.